简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

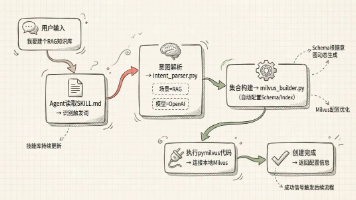

本文介绍了Anthropic推出的Skills工具调用标准,相比传统MCP方法具有更精简的上下文、更高标准化和更强可控性。文章详细讲解了Skills的目录结构(SKILL.md核心文件、scripts执行脚本、templates文档模板和resources参考资料),并以创建Milvus Skills为例,演示了如何通过自然语言描述自动构建RAG系统或Milvus Collection。实战部分包

本文介绍了基于AWS云平台构建企业级RAG(检索增强生成)系统的实践方案。针对传统大模型在企业应用中的知识时效性差、幻觉率高等问题,提出采用MVC架构设计,整合AWS Bedrock、Nova模型、Titan Embeddings和Zilliz Cloud等组件。文章详细阐述了系统架构设计思路、技术选型依据(包括AWS Lambda、Bedrock多模型支持、Zilliz向量数据库优势等),并提供

本文介绍了企业在大模型落地过程中面临的向量数据库选型难题,指出传统测试数据集(如SIFT)与真实业务场景存在维度差异,导致性能评估失真。为解决这一问题,文章推荐使用真实业务数据进行测试,并详细介绍了Zilliz团队开源的VectorDBBench工具。该工具支持多种数据库性能评测,允许用户接入自定义数据集。文章提供了从数据准备到测试的完整指南,包括如何将CSV/NPY格式数据转换为符合要求的Par

前言最近,通义开源的QwQ-32B模型可谓是火的一塌糊涂。作为一个中型推理模型,QwQ-32B只有320亿参数,但却在多个基准测试中展现出优秀的推理能力,几乎直逼满血版DeepSeek R1,在数学计算、写作与代码编程方面的表现更是相当不错。最重要的是,QwQ-32B不仅性能强大,还极其“亲民”,它体积小、推理快,支持消费级显卡部署,像RTX 4090这样的显卡就能轻松运行,非常适合普通个人开发者

去年11月,硅谷AI独角兽Anthropic正式推出了MCP——模型上下文协议,让开发者只需一次编写,就能为大模型对接不同的API、数据库与文件系统,极大降低了模型的配置难度。原因很简单,在做旅行规划的时候,大模型缺乏必要的天气、机票、铁路、导航、酒店等必要数据与工具的接入。Milvus不仅擅长管理海量数据,其高效的相似性搜索和可扩展的向量存储功能,更是让其成为AI Agent的理想之选。有了MC

要补的话,补多少才合适?早期我们主要靠人工加正则表达式,从这些描述里提取关键词来判断机型,但部分物料的模糊匹配准确率并不理想,而随着物料越来越多、描述越来越乱,这套方法不仅效率低,出错率还不小,维护起来也特别头大。更重要的是,大家不仅能回忆当初,还能基于数据做出更扎实的总结和判断,帮助采购团队精准制定补货策略,避免缺货风险,同时控制好库存规模,提升资金效率。有了这个基础,不管是老物料还是新物料,只

此外,对于Milvus的选型,沃尔沃也没选择比较新的 PyMilvus v2 SDK 及其内置的embedding集成功能,而是选择了 SDK v1 中基于collection的旧版本,从而保证团队能够设计详细的元数据结构,并明确定义每种文档的存储、索引和检索方式。此外,针对格式繁多的非结构化数据,Milvus 支持的字段类型多达 64 种,这让沃尔沃不仅能存储嵌入向量,还能存储丰富的元数据 ——

Milvus 架构的这一轮革新,不仅简化了整体系统设计,优化了成本结构,也提升了数据Freshness与故障恢复速度。Woodpecker 采用 “ZeroDisk” 架构,所有日志数据存储于云对象存储,元数据则由 etcd 等分布式 KV 系统管理,彻底消除了本地磁盘依赖,降低了运维压力,并提升了数据持久性和扩展能力。通过 Streaming Service,Milvus 实现了原生的数据订阅能

相比之下,步骤 2 中调用 Embedding API 的延迟,如果高达数百毫秒甚至数秒,就会成为用户能明显感受到的、阻塞整个流程的‘第一道坎’,因此常常是实际的性能瓶颈点。你不再需要在代码中分别对接各个厂商的 SDK,只需在 Milvus 中配置好 Function 并提供你的 API Key(Bring Your Own Key, BYOK),就可以轻松切换和对比不同模型在真实 Milvus

引言"又是一个通宵,就为了部署离线Milvus集群,结果ImagePullBackOff又报错了,镜像拉不下来,证书过期了,存储类找不到,etcd集群起不来……相信这是不少开发者在离线环境部署Milvus时,都遇到过的痛苦经历。平心而论,Kubernetes固然强大,但陡峭的学习曲线和繁琐的配置让人望而生畏。尤其是对于Milvus这样的分布式向量数据库,涉及etcd、MinIO等多个组件的协同部署