简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

基于pytorch,利用class和sequential搭建卷积神经网络

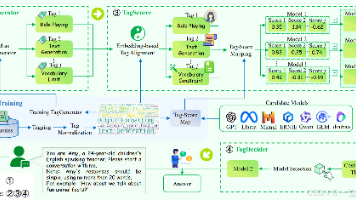

《模型路由新范式TagRouter:清华&百度提出无需训练的多LLM协作方案》 摘要:清华大学与百度智能云团队联合推出TagRouter,创新性地解决了多LLM协同中的效率与成本问题。该系统通过标签驱动机制,无需训练即可实现智能路由:首先将用户查询标签化,再评估各模型在不同标签下的能力,最终综合性能和成本进行分流。TagRouter具有三大优势:1) 完全无需训练,适配模型快速迭代;2) 在百度B

计算技术的发展历史大致可分为四个阶段,算盘的出现标志着人类进入第一代——机械计算时代,第二代——电子计算的标志是出现电子器件与电子计算机,互联网的出现使我们进入第三代——网络计算,当前人类社会正在进入第四阶段——智能计算。早期的计算装置是手动辅助计算装置和半自动计算装置,人类计算工具的历史是从公元1200年的中国算盘开始,随后出现了纳皮尔筹(1612年)和滚轮式加法器(1642年),到1672年第

一、从官网下载最新的yolov5代码二、新建VOCData文件夹三、VOCData文件夹结构1、新建Annotations文件夹,存放标签简单的xml文件,应该长这样复杂的xml文件,应该长这个样子2、新建images文件夹,存放图片数据注意:需要观察自己的图片文件的后缀名,后面需要用到,不然可能出现程序找不到图片的情况3、新建split_train_val.py,用来划分训练集与验证集运行之后,

我们经常会使用到hugging face开源的transformers包,调用from_pretrained方法直接下载模型时,经常会下载很久甚至失败.而且由于它自动将下载的模型保存至文件夹下,这不方便我们对模型进行备份。为了解决这个问题,下面我们将实现“下载huggingface-transformers模型至本地,并使用from_pretrained方法加载”。

目标检测在使用了基于深度学习的端到端模型后效果斐然。目前,常用的目标检测算法,无论是One-stage的SSD系列算法、YOLO系列算法还是Two-stage的基于RCNN系列的算法,非极大值抑制都是其中必不可少的一个组件。在现有的基于anchor的目标检测算法中,都会产生数量巨大的候选矩形框,这些矩形框有很多是指向同一目标,因此就存在大量冗余的候选矩形框。非极大值抑制算法的目的正在于此,它可以消

转化为格式1的代码:(需要注意的是,读取文件和写入文件的encoding需要指定为一致,不然会导致gbk和utf混用,导致评测和微调的时候出现字符错误)转化为格式2的代码:(注意需要将jsonl的’转化为”)

基于pytorch,利用class和sequential搭建卷积神经网络

准备1.运行环境:VS2010与VS2017均可,opencv2.9与opencv2.9以上均可。2.拍十五张标定板图片3.放到calibdata.txt目录下4.代码#include "opencv2/core/core.hpp"#include "opencv2/imgproc/imgproc.hpp"#include "opencv2/calib3d/calib3d.hpp"#include

当需要根据已有的时间序列数据,预测未来多个时刻的状态时,被称之为时间序列多步预测。时间序列多步预测有五种策略,分别为:1、直接多步预测(Direct Multi-step Forecast)2、递归多步预测(Recursive Multi-step Forecast)3、直接递归混合预测(Direct-Recursive Hybrid Forecast)4、多输出预测(Multiple Outpu