简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

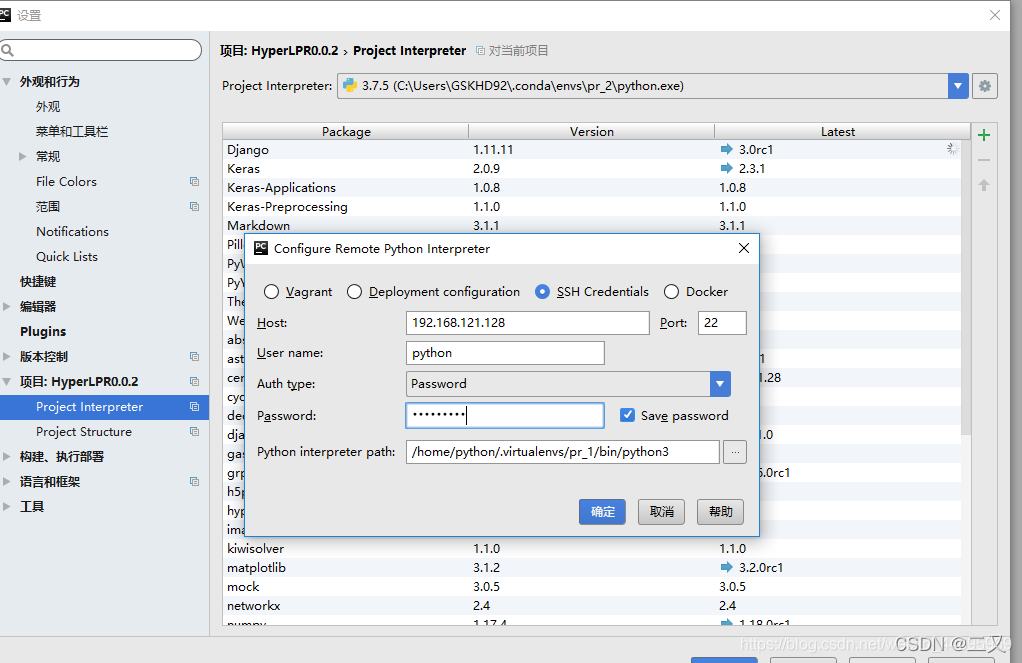

关于pycharm远程连接服务器的傻瓜时间今天特别惨因为pycharm专业版过期没及时激活导致pycharm直接崩了!!!太坑了,我必须要告诉大家,教育邮箱注册的pycharm是可以在同学之间共享账号的,所以没关系只要借个账号我还是一条憨憨~正常人按照大佬写的一步步去做应该没问题Pycharm设置远程服务器运行环境但是总有人像我一样盲目自信,忽略细节:大佬的files->settings-&

在base下搜索之后找到缺失的py文件’_sysconfigdata_x86_64_conda_linux_gnu’复制将此文件复制到丢失文件的环境下,解决了我的问题。

python数据类型->Numpy数据类型->Pytorch的cup tensor->Pytorch的gpu tensor转载a为基本的int类型数据b=np.array(a), b为numpy数据类型c=torch.from_numpy(b),c为CPU的tensord=c.cuda(),d为GPU的tensor

点击datasets,然后选择Broad_Depmap_data,选择自己需要的数据类型然后选择下载,这里我选择了counts数据。

本人参考这位大佬的文章,并加了自己的填坑过程。anaconda无法激活新建环境,提示没有那个文件或目录:路径问题1、执行 conda activate base(激活环境)等等于conda相关命令时,会报一个关于路径找不到的错误。这种问题一般的解决方法就是到报错的路径下看看有没有这个东东,没有当然会报错。例如我执行:(ges) ges@gpu-1:~$ pip install prepro报错:-

卷积和全连接层参数量计算公式:转载卷积层参数量=(filter size * 前一层特征图的通道数 )* 当前层filter数量+当前层filter数量全连接层的计算量 = 映射的特征图大小(77512)*输出一维向量的维度(4096)假设输入神经元数为M,输出神经元数为N,则:(1)bias为True时:则参数数量为:M*N + N(bias的数量与输出神经元数的数量是一样的)(2)bias为F

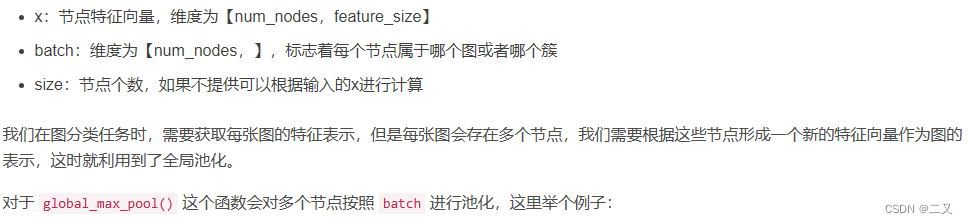

python数据类型->Numpy数据类型->Pytorch的cup tensor->Pytorch的gpu tensor转载a为基本的int类型数据b=np.array(a), b为numpy数据类型c=torch.from_numpy(b),c为CPU的tensord=c.cuda(),d为GPU的tensor