简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

FlashMLA 是由 depseek-ai (深度求索)开发的一个开源项目,针对Hopper 架构GPU(例如 H100 或 H800)的高效的 MLA 推断(Inference)解码内核,旨在加速 MLA 机制的计算,特别适用于 DeepSeek 系列模型(如 DeepSeek-V2、V3 和 R1)。DeepSeek V3/R1 介绍(来源:中存算半导体)其中 MLA 是 DeekSeek

向量数据库是一种将数据存储为高维向量的数据库,高维向量是特征或属性的数学表示。每个向量都有一定数量的维度,根据数据的复杂性和粒度,可以从数十到数千不等。向量通常是通过对原始数据(如文本、图像、音频、视频等)应用某种转换或嵌入函数来生成的。嵌入函数可以基于各种方法,如机器学习模型、词嵌入和特征提取算法。向量数据库的主要优点是,它允许基于数据的向量距离或相似性进行快速和准确的相似性搜索和检索。这意味着

OpenAI近期推出了一款名为Deep Research的高级AI研究工具,旨在帮助用户高效完成复杂的研究任务。该工具基于OpenAI最新的o3模型,专为网络浏览和数据分析优化。在本文写作过程中,笔者在思索如何对Deep Research做本地化复现的过程中,也有几个思考想要做一个分享:1、数据会成为未来企业的生存红线,掌握优质数据的企业,也就拥有了Deep Research +N,脱颖而出的机会

投资理财类专业的研报大数据平台(可下载APP)。国家高端产业智库,研究报告免费下载PDF版本。全面专业的数据报告下载,学术专利知识查询。全球领先的新经济行业数据分析报告发布平台。科技与产业创新机构,研究数据报告PDF。科技行业数据报告,可下载PDF版本。全球知名的咨询公司,行业洞察分析。阿里出品,阿里相关产品数据报告。引领设计变革,设计行业数据报告。行业分析报告,提供PDF下载。各种数据报考在线浏

过去两年,AI智能体(AI Agent)成为AI落地的热门方向。从 ChatGPT 的对话助手,到自动化办公、代码助手,再到多智能体协作平台,智能体被视为未来人机交互的核心形态。然而在实际落地中,很多企业会发现一个残酷现实:构建一个真正可用的智能体,90% 的工作是软件工程,只有 10% 才是 AI。这一观点最早由 Rakesh Gohel 在其著名的AI Agent冰山模型中提出,并在业内引发了

1、Ai-Bot 是2021年推出的一款全新自动化测试框架2、它支持Windows 桌面程序、Android APP 和 浏览器chrome、edge ie所有版本自动化测试’3、基于node.js语言,JavaScript开发人员也能做自动化测试和办公自动化机器人开发4、结合AI人工智能技术,满足开发者各种场景需求(验证码识别,图片文字识别等…)5、底层构架C++实现,windows底层稳定急速

DualPipe 的设计目标是最大化集群设备的计算性能,通过在前向传播(Forward)和后向传播(Backward)阶段实现计算与通信的完全重叠,显著减少传统流水线并行中的 “气泡”(Pipeline Bubble,即空闲等待时间)。这种方法在保持计算通信比例恒定的情况下,即使模型规模进一步扩大,也能维持接近零的通信开销。为保证 MoE 部分不同专家之间的负载均衡,会将共享专家和高负载的细粒度专

3FS 的设计初衷是为 DeepSeek 的 AI 基础设施(如 Fire-Flyer AI-HPC)和模型(如 DeepSeek-V3、R1)提供底层存储 + 数据支持。3FS 涵盖训练数据预处理、数据集加载、检查点保存与重载、嵌入向量搜索以及推理过程中的 KVCache(键值缓存)查找等环节。3FS 显然是 DeepSeek 高效训练体系的关键组件,进一步体现了 DeepSeek 的硬件基因。

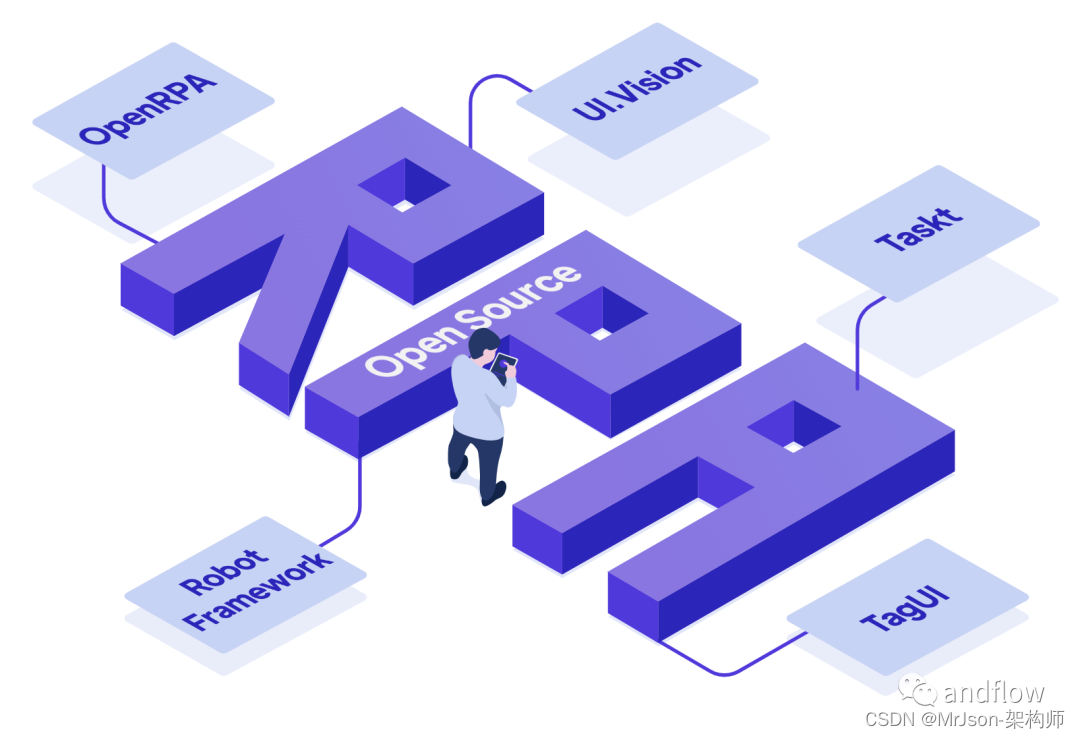

在最近两年中,RPA加上AI,即智能自动化流程,已经成为频繁讨论的话题,特别是在企业和机构的数字化转型过程中。自动化与智能化成为了提高效率的关键手段,而RPA便是迈向这一未来的起始步骤。可以将RPA视为人体的躯干神经系统,而AI则相当于大脑。AI的角色在于引入智能化处理,而RPA的作用则是模拟人类与软件系统的交云动,通过自动化软件来执行业务流程。RPA软件机器人能够识别应用程序界面上的数据,并且能

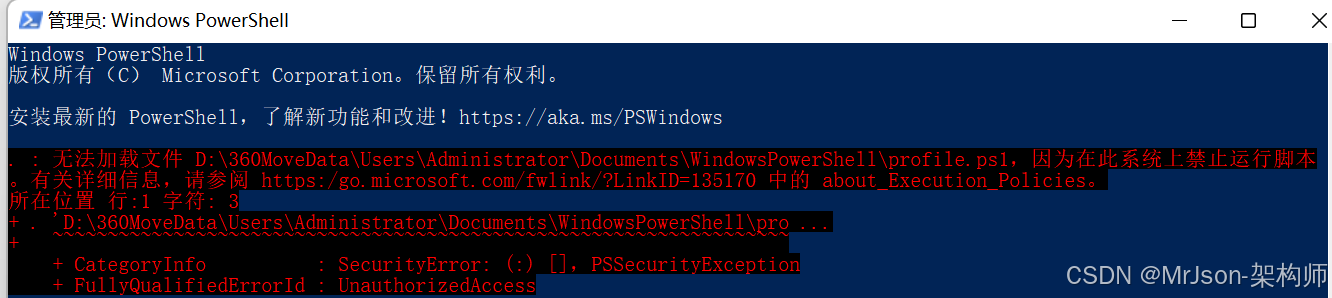

以管理员身份运行PowerShell:右键点击 PowerShell 图标,选择“以管理员身份运行”,以获得更高的权限;在终端 get-ExecutionPolicy,如果输出 Restricted,就说明执行策略设置为过于严格,则可能阻止未签名的脚本运行。首先要确保 C:\Users***\Documents\WindowsPowerShell\profile.ps1 路径下的 script.p