简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

可以发现上面的 Seq2Seq 方式只是将编码器的最后一个节点的结果进行了输出,但是对于一个序列长度特别长的特征来说,这种方式无疑将会遗忘大量的前面时间片的特征。每个单词(而不是一个字母,也不是一句话)是一个输出,为了满足自然语言的特征,单词与单词之间,是有关联的,不是相互独立的。即输入虽然没有序列,但输出是有序列的。即多个输入,如“我”、“打”、“你”,如果时序关系不同,其含义也是不相同的,即为

一般来说,xi的大部分元素(也就是特征)都是和最终的输出yi没有关系或者不提供任何信息的,在最小化目标函数的时候考虑xi这些额外的特征,虽然可以获得更小的训练误差,但在预测新的样本时,这些没用的特征权重反而会被考虑,从而干扰了对正确yi的预测。我们首先将数据集划分为训练集和测试集,由于模型的构建过程中也需要检验模型,检验模型的配置,以及训练程度,过拟合还是欠拟合,所以会将训练数据再划分为两个部分,

Adagrad优化算法就是在每次使用一个 batch size 的数据进行参数更新的时候,算法计算所有参数的梯度,那么其想法就是对于每个参数,初始化一个变量 s 为 0,然后每次将该参数的梯度平方求和累加到这个变量 s 上,然后在更新这个参数的时候,学习率就变为。Adagrad 的核心想法就是,如果一个参数的梯度一直都非常大,那么其对应的学习率就变小一点,防止震荡,而一个参数的梯度一直都非常小,那

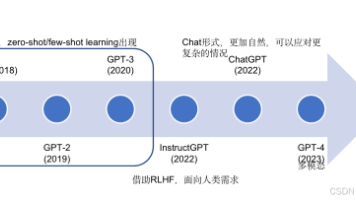

ChatGPT是怎么变聪明的?想象一下,ChatGPT一开始就像个刚学说话的小孩,虽然懂一些知识,但回答得不太好。科学家们为了让它的回答更符合人类喜好,用了三步训练法,让它像打游戏升级一样,越练越强!第1步:先教它“标准答案”(监督学习)方法:从网上找一大堆问题和答案(比如“怎么煮咖啡?”),让ChatGPT学习正确的回答方式。结果:它学会了基本的对话能力,但还不够

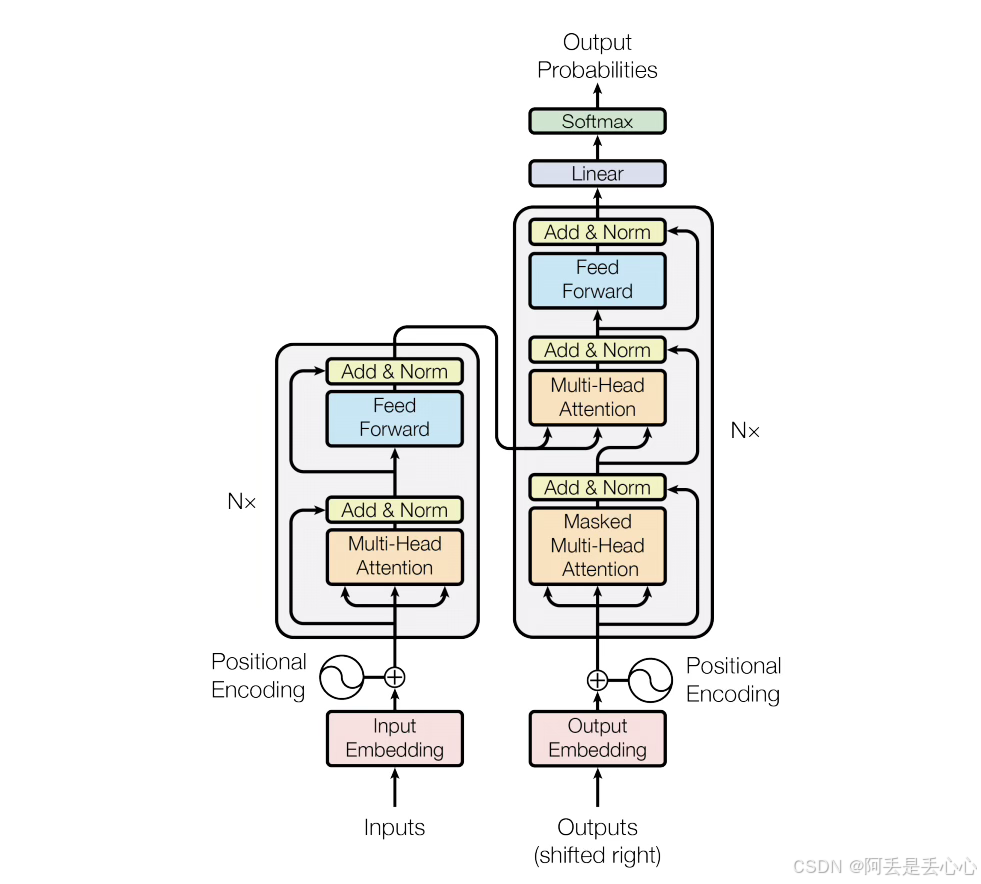

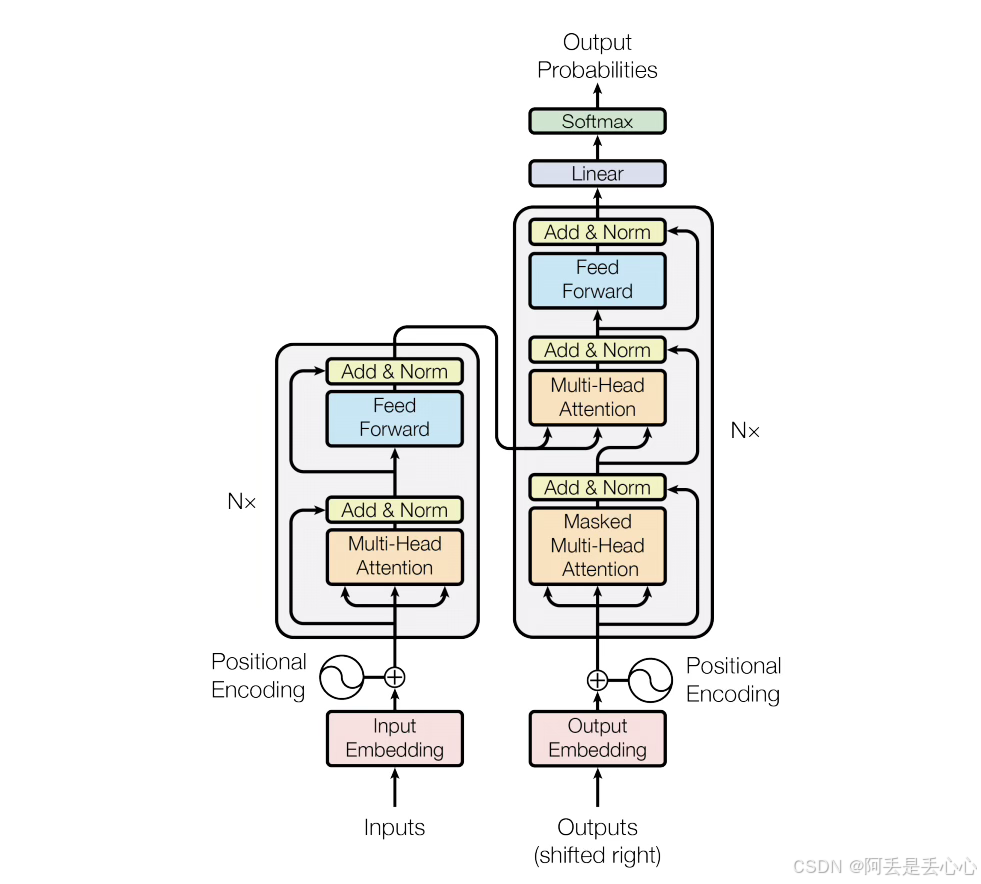

首先,我们会把需要处理的文本序列转换为一个输入词嵌入向量(Word Embedding),它负责将输入的词转换成词向量。然后,我们会为这些词向量添加位置编码(Positional Encoding),从而为模型提供位置信息,如下图所示。由于Transformer模型不使用循环神经网络,因此无法从序列中学习到位置信息。为了解决这个问题,需要为输入序列添加位置编码,将每个词的位置信息加入词向量中。正弦

Adagrad优化算法就是在每次使用一个 batch size 的数据进行参数更新的时候,算法计算所有参数的梯度,那么其想法就是对于每个参数,初始化一个变量 s 为 0,然后每次将该参数的梯度平方求和累加到这个变量 s 上,然后在更新这个参数的时候,学习率就变为。Adagrad 的核心想法就是,如果一个参数的梯度一直都非常大,那么其对应的学习率就变小一点,防止震荡,而一个参数的梯度一直都非常小,那

首先,我们会把需要处理的文本序列转换为一个输入词嵌入向量(Word Embedding),它负责将输入的词转换成词向量。然后,我们会为这些词向量添加位置编码(Positional Encoding),从而为模型提供位置信息,如下图所示。由于Transformer模型不使用循环神经网络,因此无法从序列中学习到位置信息。为了解决这个问题,需要为输入序列添加位置编码,将每个词的位置信息加入词向量中。正弦

Adagrad优化算法就是在每次使用一个 batch size 的数据进行参数更新的时候,算法计算所有参数的梯度,那么其想法就是对于每个参数,初始化一个变量 s 为 0,然后每次将该参数的梯度平方求和累加到这个变量 s 上,然后在更新这个参数的时候,学习率就变为。Adagrad 的核心想法就是,如果一个参数的梯度一直都非常大,那么其对应的学习率就变小一点,防止震荡,而一个参数的梯度一直都非常小,那

Adagrad优化算法就是在每次使用一个 batch size 的数据进行参数更新的时候,算法计算所有参数的梯度,那么其想法就是对于每个参数,初始化一个变量 s 为 0,然后每次将该参数的梯度平方求和累加到这个变量 s 上,然后在更新这个参数的时候,学习率就变为。Adagrad 的核心想法就是,如果一个参数的梯度一直都非常大,那么其对应的学习率就变小一点,防止震荡,而一个参数的梯度一直都非常小,那

先说几个常用的可以下载数据集的地方和鲸社区(阿里天池(下面使用的数据集来源与。