简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本人项目地址大全:Victor94-king/NLP__ManVictor: CSDN of ManVictor写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!我们都知道GPT在推理时是每步根据当前的序列预测下一个token。假设我们输入 “I am a”,GP

GGUF(GPTQ for GPUs Unified Format)是一种针对大语言模型(LLM)权重文件的统一格式,旨在简化和标准化不同模型格式之间的转换和加载。随着大语言模型的快速发展,不同的框架(如Hugging Face Transformers、TensorFlow、PyTorch等)和优化工具(如GPTQ、LoRA、INT8/INT4量化)可能生成不同格式的模型文件。GGUF格式的引入

KV Cache 在已经成为了 LLM 推理系统中必须要用到的一个优化技术。KV Cache 的想法很简单,即。

在解析(1)使用MinerU将PDF转换为Markdown中我们提到了将各种文档解析为Markdown的好处,本文我们接着上一篇文章处理后的Markdown,讲解如何对Markdown文档进行切分。在很多文档中,标题都是非常重要的信息,例如企业内部的办理流程,稍微规范点的文档,标题里面都会体现重点信息的。既然转成了Markdown,标题肯定是保留下来了,本文将首先介绍基于Markdown标题的切分

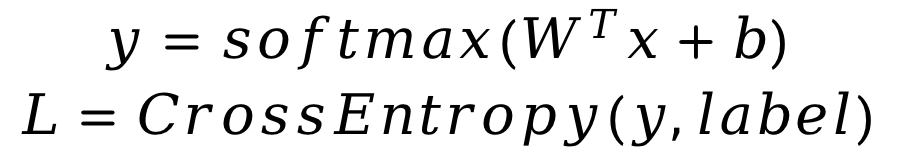

本次案例中,你需要用python实现Softmax回归方法,用于MNIST手写数字数据集分类任务。你需要完成前向计算loss和参数更新。你需要首先实现Softmax函数和交叉熵损失函数的计算。在更新参数的过程中,你需要实现参数梯度的计算,并按照随机梯度下降法来更新参数。

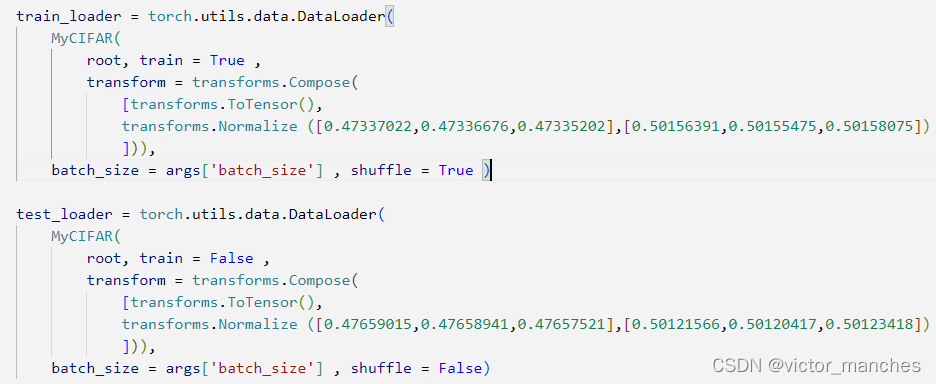

用多层感知机( MLP) 和卷积网络( ConvNet) 完成CIFAR10分类

使用 pip: pip install markitdown。或者,从源代码安装它:pip install -e .RAG有这么一个说法:“垃圾进,垃圾出”,文档解析与处理以获取高质量数据至关重要。,一款将各种文件转换为 Markdown 的实用程序(用于索引、文本分析等)。

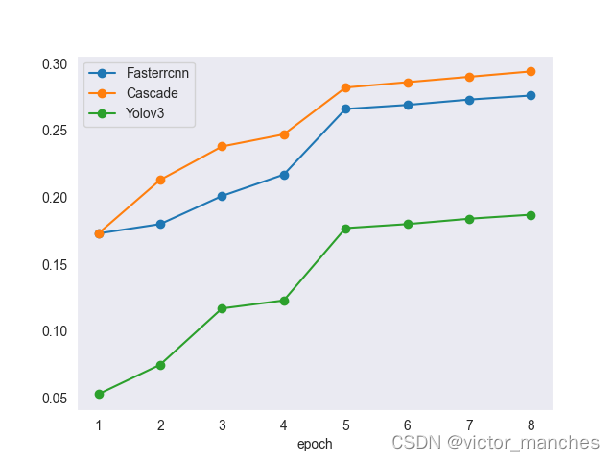

本次案例将使用深度学习技术来完成城市交通场景下的目标检测任务,案例所使用的数据集由滴滴出行提供,基于D2-City大规模行车记录视频数据集[1],经过视频抽帧等预处理步骤得到。数据集共包含12,000张图像,每张图像的大小为1080×1920或720×1280,已划分为训练集(10,000张)、验证集(1,000张)、测试集(1,000张),其中训练集和验证集提供了检测标签,测试集仅提供图像,用于

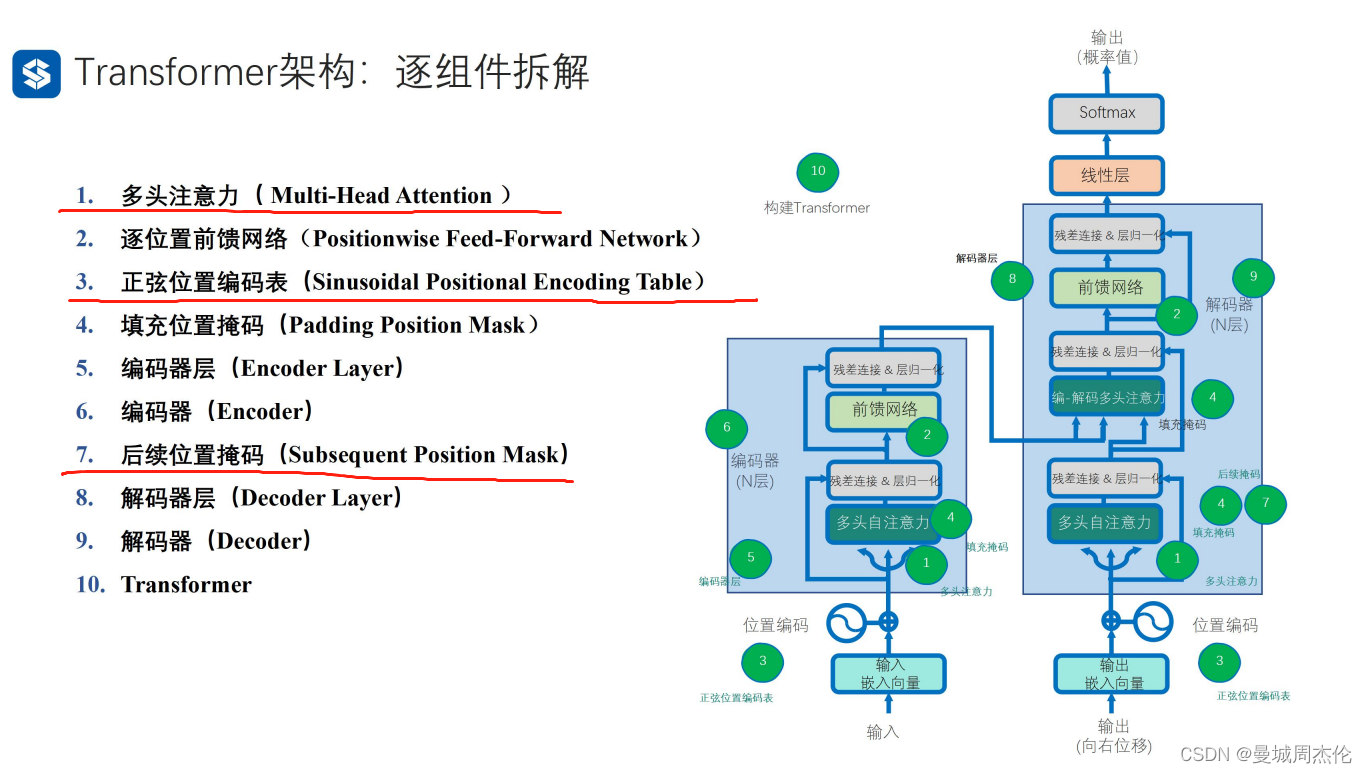

解码器也是由N层解码器层深度叠加实现的,其中与编码器层结构类似,但是添加了几个特别的点是编解码多头注意力 , 这里比较好理解就是因为在解码器得到自己的自注意力后,需要与编码器的输出做注意力整合, 除此之外还有一个后续位置掩码。序列生成任务中,解码器的每个实践步都依赖于前面已经生成的部分序列,在解码器中,生成的自注意力由于每次生成的内容不能关注到后续位置的注意力,换句话说就是为了防止解码器在生成当前

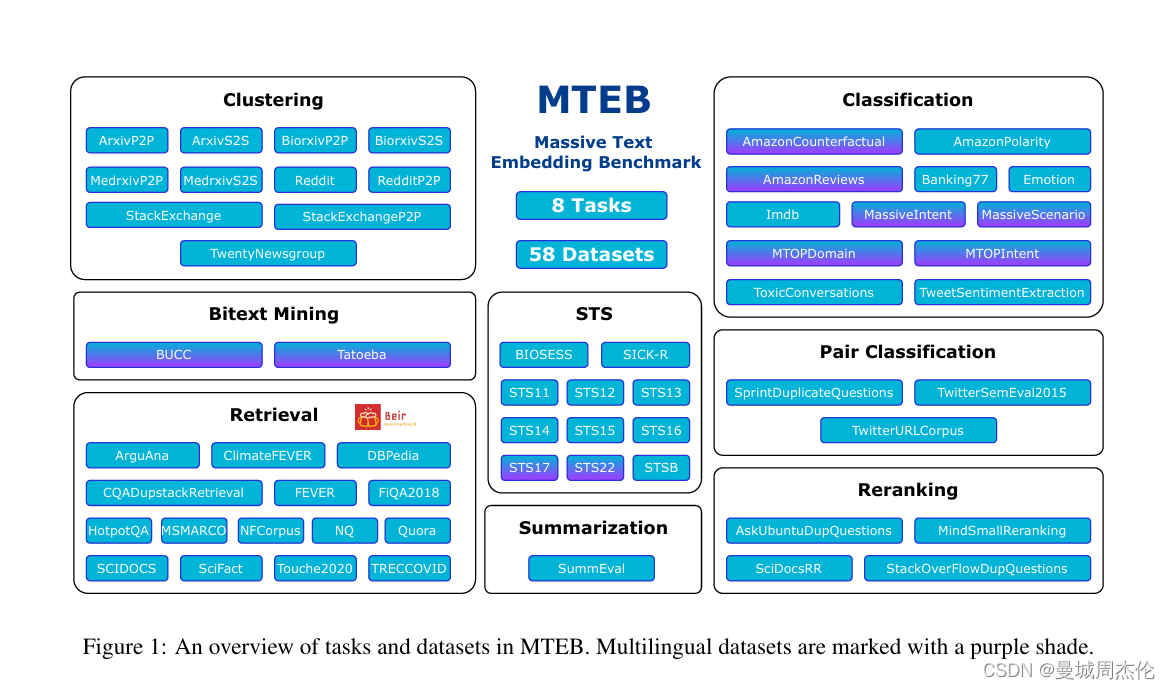

文章链接:项目地址:github地址:NLP的应用中,有一个最关键的步骤就是将文字/其他多模态的模型转换成词嵌入/向量化,而对应的这个模型便称之为Embedding模型。那么在这么多embedding模型里,如何评价好坏呢?本文就会介绍,(Massive Text Embedding Benchmark)是目前评测文本向量很重要的一个参考,其也是各大文本向量模型用来展示与其他向量模型强弱的一个竞技