简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

数据扩增数据扩增是扩充数据的一项重要手段,原理是基于已有的标注数据,进行相应变化,其对应的标签不作改变或者也跟着有相应的变化。本次只对原始图片进行更改,label保持不变。即只变动原始数据,生成新的图像的label与原始图像一样,只是文件名变了import skimageimport osimport shutilimport sysfrom PIL import Image, ImageEnha

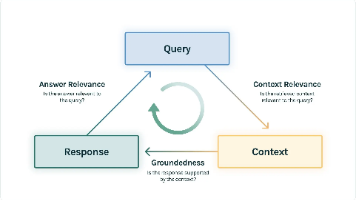

摘要: 检索增强生成(RAG)技术已成为企业级AI应用的核心方案,但其落地效果依赖科学评估。本文提出基于RAG三元组的评估框架,从上下文相关性(检索质量)、忠实度(生成可靠性)、答案相关性(用户价值)三个维度构建全链路评估体系。通过分层评估(检索评估聚焦精确率/召回率等指标,响应评估量化端到端表现)精准定位问题根源,如检索噪声或生成幻觉。该框架为开发者提供标准化评估方法,确保RAG系统在金融、医疗

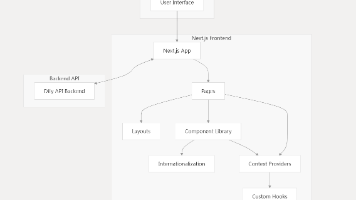

本文介绍Dify Web前端技术架构,采用Next.js框架构建,主要技术栈包括TypeScript、Tailwind CSS和i18next。系统采用模块化设计,包含基础组件、领域组件和页面组件三层架构,支持多语言国际化。通过React Context API进行状态管理,利用Next.js路由实现高效导航。该架构实现了组件复用、状态共享和多语言支持,提供了良好的开发体验和用户交互。

系统设计支持可扩展性、可部署性,并能适应多种环境(包括自托管和云部署)。概述了 Dify 的系统架构,解释主要组件如何协同工作以提供大语言模型(LLM)应用开发平台。对话系统负责管理用户与大型语言模型(LLM)之间的交互,处理聊天历史记录、消息格式化和上下文管理。工作流系统支持创建和执行复杂的AI流程,将LLM交互与工具、分支逻辑和数据转换相结合。Dify使用了一套全面的配置系统,该系统支持环境变

通过合理配置Gunicorn,可以显著提升Python Web应用的性能。无论是CPU密集型还是I/O密集型应用,都有对应的优化策略

TechBeat: 强化学习ppo让决策智能演化出无限可能

因此,在多层网络中,零初始化是绝对不可取的。然而,这一过程充满了不确定性,就像在未知的道路中选择下山路径,每次重新初始化就如同重新选择道路,即使使用相同的初始化算法,也会给训练结果带来显著差异。通过对神经网络权重矩阵初始化方法的深入研究和理解,能够在构建和训练神经网络时,根据具体的网络结构和激活函数,选择最为合适的初始化方法,从而为神经网络的成功训练和高效性能奠定坚实基础。随着神经网络研究的不断深

各种self-attention

目标在本章中,将学习利用calib3d模块在图像中创建一些3D效果基础在上一节相机校准中,了解了相机矩阵、失真系数等。给定图案图像,可以利用以上信息来计算其姿势或物体在空间中的位置,例如其旋转方式, 对于平面物体,可以假设Z=0Z = 0Z=0,问题就变成了如何将相机放置在空间中以查看图案图像。 因此,如果知道对象在空间中的位置,可以在其中绘制一些2D图来模拟3D效果。问题是,想在棋盘的第一个角上

学习地址:https://www.kaggle.com/learn/python注:注册个人账号需要翻墙确认,学习形式Jupyter notebook学习目录:Hello, Python简单介绍python的常量、变量赋值以及算术运算练习: Syntax, Variables, and NumbersFunctions and Getting Help函数定...