简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

昨晚Qwen3发布了完整的技术报告,介绍了最新的 Qwen3 系列模型,包含稠密架构和 MoE 架构,参数规模从 0.6B 到 235B。Qwen3 将“思考模式”(用于复杂、多步推理)和“非思考模式”(用于快速、上下文驱动的响应)整合入统一框架,无需切换模型。同时引入“思考预算”机制,用户可自适应地分配计算资源。实验评估表明,Qwen3 在代码生成、数学推理、智能体任务等多个基准测试上取得了业界

Kimi在近期发布了最大规模开源模型K2,其为MOE架构,包含1.04T参数,32B激活。K2 重点强调了其大规模的智能体(agentic)数据合成流水线和联合强化学习方法,模型通过与真实和合成环境的交互来增强其能力。实验评测显示,K2在agentic 能力和编程、数学、推理能力上均在开源非思考模型中取得最佳性能表现。

消息流中的错误无论怎么试都无法继续使用。后续检索发现是限额问题,于是便搜集整理了一下目前的ChatGPT模型限额的相关信息,特此记录。

问题说明项目需要,要加载一个具有两千多万条样本的两万多分类问题的数据集在BERT模型上进行Fine tune,我选取了其中2%的数据(约50万条)作为测试集,然后剩下的两千多万条作为训练集。我按照 Transformers库官方文档里的 Fine-tuning with custom datasets一文中对BERT模型在IMDb数据集上Fine tune的过程进行改写。原代码如下:train_t

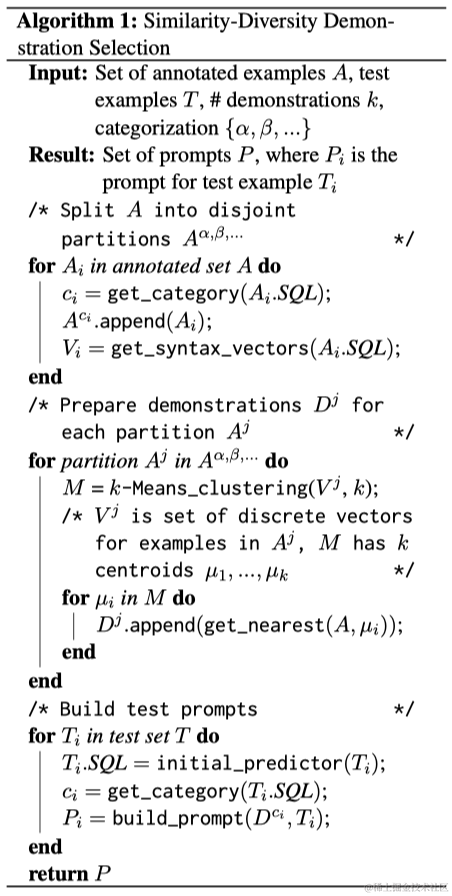

本研究探索了用于文本到SQL领域语义解析任务的各种提示设计方法。本文提出了一种利用示例的SQL语法结构来选择示例演示的方法,强调多样性和相似性作为采样目标。此外,本文发现大型语言模型(LLMs)从与数据库相关的知识增强中受益。未来的研究可以基于本文的发现来检验本文方法在其他领域的可转移性。通过持续改进LLMs在语义解析方面的能力,本文旨在为开发更准确、更稳健和更易理解的问答系统做出贡献。

问题描述昨天跟着一篇博客BERT 的 PyTorch 实现从头写了一下BERT的代码,因为原代码是在CPU上运行的,于是就想将模型和数据放到GPU上来跑,会快一点。结果,在将输入数据和模型都放到cuda上之后,仍然提示报错:"RuntimeError: Input, output and indices must be on the current device"原因与解决方法通过打印检查了很多次

阿里通义实验室提出WebDancer——一套从数据构建到训练策略的端到端信息检索智能体构建范式,支持多轮、多工具交互与长程推理。该系统在 GAIA与 WebWalkerQA 等复杂多跳信息检索任务中表现优异,验证其方法有效性与可扩展性。

WebSailor 是一套开源智能体训练方法,旨在提升其在复杂信息检索任务中的超人类推理能力。现有开源网页智能体在 BrowseComp-en/zh 等任务中几乎无法作答,其原因在于缺乏应对高不确定性、缺乏预定义路径任务的推理能力。WebSailor 通过高不确定性任务构造、RFT 冷启动、强化学习算法 DUPO 的集成流程,显著提升了模型在复杂搜索任务中的能力,性能首次与专有系统接近。

Codalab是一个用于复现深度学习研究的协作平台,由斯坦福大学和微软合作开发。其核心理念是在云端运行机器学习实验,像jupyter notebook一样在数字实验室中管理实验,同时可以发布实验的 worksheet 以便其他人可以复现实验结果。Colab官网展示的三个步骤为:上传文件:首先将代码和数据集文件上传至平台。进行实验:运行代码,进行训练或者测试。

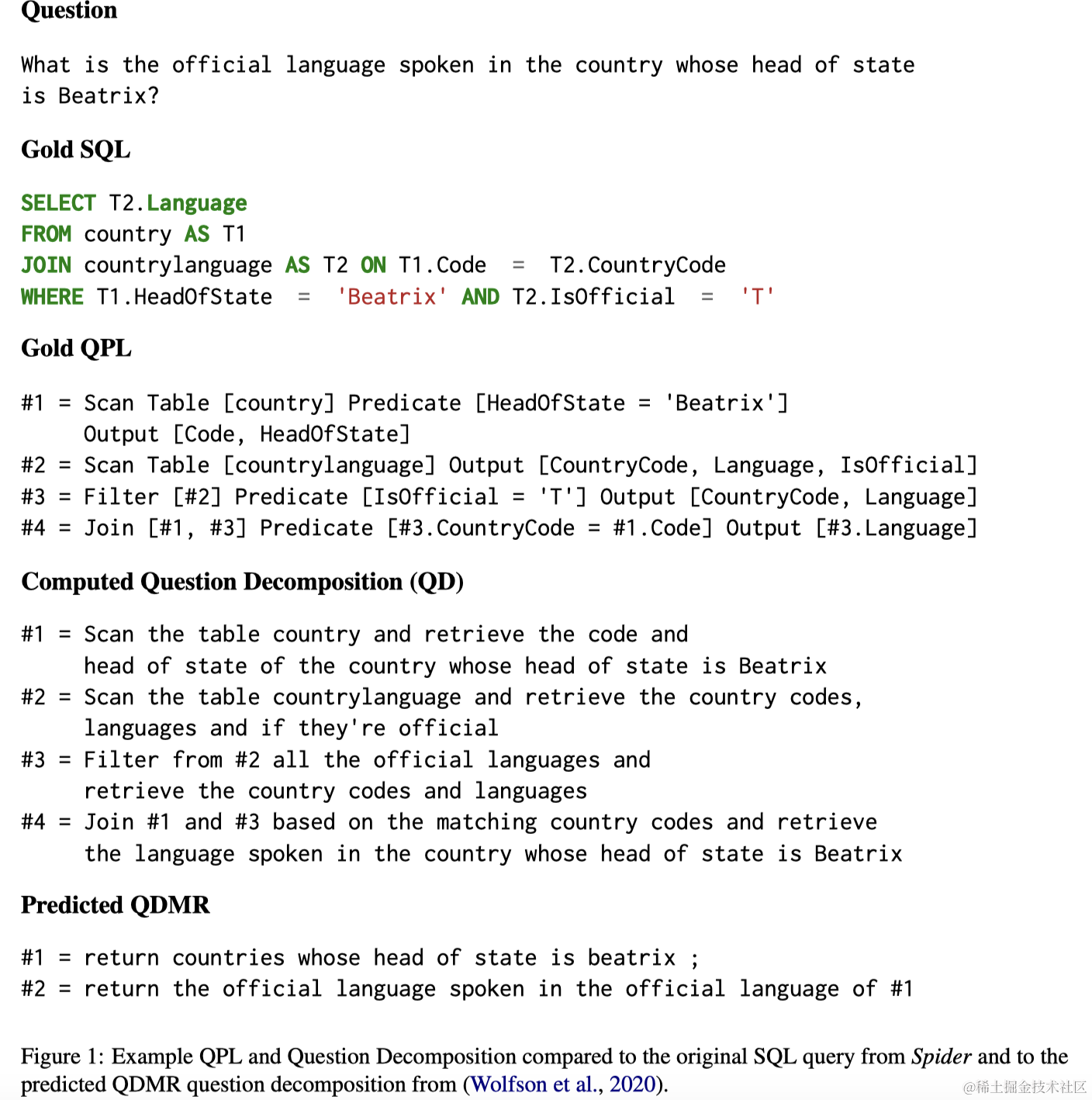

本文提出了一种叫做Query Plan Language (QPL)的语言,用来将复杂SQL语句分解为更加简单的子语句。QPL具有以下优势:1)可以转述为简单问题,从而创建了一个复杂问题,分解问题的数据集。在这个数据集上训练,获得了一个敏感于数据库模式的数据检索问题分解器。2)QPL对于非专家处理复杂查询更易于接近,使语义解析器的输出更易于理解。