简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

据新华社报道,全国人大常委会于 8 月 20 日通过了《个人信息保护法》,该法自 11 月 1 日起施行。它全面和具体地规定了企业保护个人信息安全的各项义务,同时指出违反法规最高可面临 5000 万或一年度营业额 5% 的巨额罚款。这是我国首部针对个人隐私保护的法律,立法的严格程度堪比欧盟《通用数据保护条例》(GDPR)。它的出炉不仅是对顶层制度的查缺补漏,还进一步释放出了国家决心整治市场侵害个人

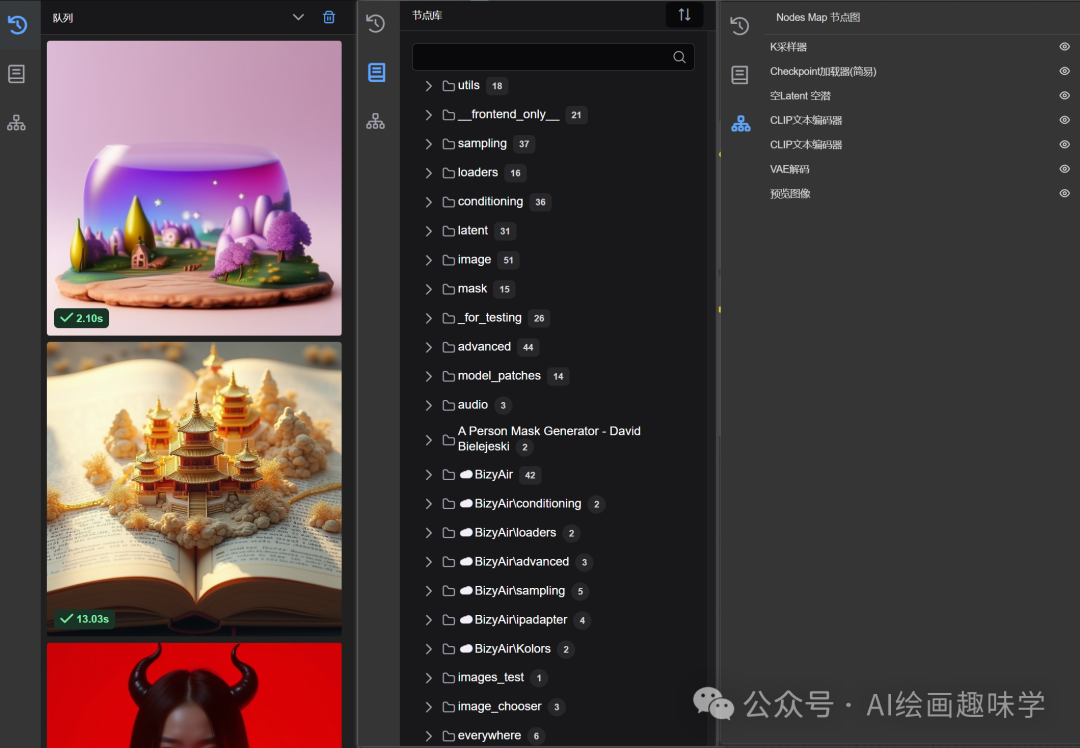

最近ComfyUI前端新版8月16号就推出了,但是我之前升级后又回退了,因为不好用,挺多bug,今天又心血来潮去体验了下,发现很多问题都解决了,也找到了中文搜索不支持的替代方案,整体使用了一会,发现还不错,今天就来给大家分享下如何升级以及一些优化体验的操作。

ComfyUI 系列(11):SD 3.5 工作流引言Stable Diffusion 3.5(SD 3.5)是当前最先进的文本到图像生成模型之一,具备更强的文本理解能力、更高的图像细节以及更好的一致性。相比于 SDXL 和 SD 1.5,SD 3.5 在复杂场景生成、文字嵌入、角色一致性等方面都有显著提升。SD 3.5 模型是最近新出的,以后所有工作流都以3.5模型为基础。

今天小编给大家带来了一款来自“凉一”大佬的Flux电商产品写实大模型——FLUX简朴归真-电商大模型。该模型适用美妆日用手表食品产品海报,“凉一”大佬用简朴归真来形容这个大模型真的再恰当不过了,结合着Flux这款优质大模型,只需一句简单的提示词,便可以轻松直出商业写真产品摄影照。该款模型的出图质量可以说是很高了,非常适合电商产品使用,详情页与主图、海报KV,可以做出很多渲染创意的场景例如、产品写实

在电商的视觉战场上,产品展示图的吸引力关乎成败。白底图虽简洁,却难在竞争中脱颖而出。本案例实操将为你揭秘如何利用 Stable Diffusion 扭转乾坤,把单调白底图转化为吸睛的电商模特场景图,开启创意无限的电商视觉营销新篇章。今天分享一下SD模特+化妆品,艺术创作的教程。本次教程按照从上到下的操作顺序写的①选好大模型②输入关键词③选好LORA模型,设置出图参数④设置ControlNet1、选

不管使用Stable Diffusion的文生图或图生图进行AI绘画,都可以用提示词描述相关图像效果,通过尝试不同提示词组合和参数,从而达成更好的AI绘图效果和创意。与其天天在网上找别人的提示词,不如自己学会写好提示词,读懂本篇攻略让你轻松驾驭SD提示词prompt。1 SD提示词语法格式2 提示词技巧3 SD提示词实战。

为了帮助大家更好地掌握 ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了。

在数字图像的世界里,追求极致的清晰度与丰富细节从未停歇。如今,我们迎来了一场实战盛宴,将运用当下最为强大的 FLUX 模型,结合 Comfyui 平台,开启图像高清放大并增添细节的奇妙旅程,探索视觉表现的无限可能,见证图像质的飞跃。1.首先加载FLUX 1 模型(由于电脑配制较低,使用简化版模型)2.加载需要放大并增加细节的图片3.输入提示词:水中的鱼,户外摄影,溪流,真实,杰作摄影,8K4.使用

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。感兴趣的小伙伴,赠送