简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Ollama是一款专注于简化大型语言模型本地部署和运行的开源框架,基于Go语言实现,支持跨平台运行,并以“开箱即用”为核心理念,适合个人开发者和轻量化场景。而vLLM是一个高效的大模型推理与服务引擎,基于PyTorch构建,创新性地引入了PagedAttention技术,旨在解决大模型服务中的显存效率与吞吐量瓶颈,支持张量并行和流水线并行,可横向扩展至多机多卡集群。

国产AI大模型发展迅速,百度文心一言、腾讯元宝、阿里通义千问等纷纷入局。根据2025年最新数据,网站端访问量DeepSeek居首,APP端豆包领先。头部互联网企业占据竞争优势,对于大多数用户,网站端使用DeepSeek,手机端选择豆包AI即可满足需求。两大模型均拥有强大技术支持和丰富用户经验,是编程开发者的理想选择。

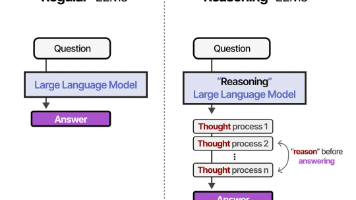

DeepSeek-R1的推理能力让世人为之刮目,全球首创的推理过程显性化让世界为之震撼。那么大模型的推理过程是如何实现的呢?推理大模型是指能够在传统的大语言模型基础上,强化推理、逻辑分析和决策能力的模型。它们通常具备额外的技术,比如强化学习、神经符号推理、元学习等,来增强其推理和问题解决能力。例如DeepSeek-R1,GPT-o3等等,它们在逻辑推理、数学推理和实时问题解决方面表现突出。:适用于

Ollama是一款专注于简化大型语言模型本地部署和运行的开源框架,基于Go语言实现,支持跨平台运行,并以“开箱即用”为核心理念,适合个人开发者和轻量化场景。而vLLM是一个高效的大模型推理与服务引擎,基于PyTorch构建,创新性地引入了PagedAttention技术,旨在解决大模型服务中的显存效率与吞吐量瓶颈,支持张量并行和流水线并行,可横向扩展至多机多卡集群。

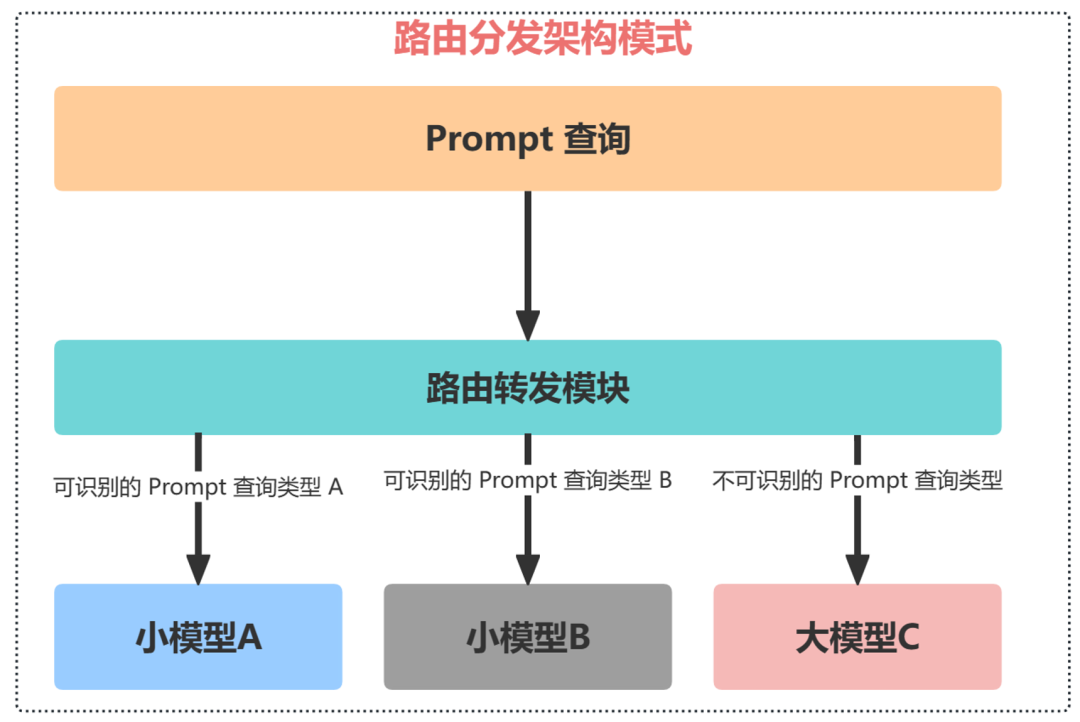

在过去的两年间,AI 大模型的能力得到了显著增强,有些大模型的幻觉问题甚至已经消失。。我们必须认识到,AI大模型并非全能,尽管在某些领域它们表现出色,但并不意味着它们能够解决所有问题。那么,如何应对这些挑战呢?的解决方案应运而生。

过程奖励模型(PRMs)作为一种颇具潜力的方法,被应用于大语言模型(LLMs)的数学推理过程监督,旨在识别并减少推理过程中的中间错误。然而,开发有效的 PRMs 面临着重大挑战,尤其是在数据标注和评估方法方面。在本文中,通过大量实验,我们证明了与 “大语言模型充当裁判” 以及人工标注方法相比,常用于 PRMs 的基于蒙特卡洛(MC)估计的数据合成,通常性能和泛化能力较差。MC 估计依赖于完成模型来

在科技飞速发展的 2025 年,Deepseek犹如一颗璀璨的新星,迅速在全球范围内爆火。但凡体验过它强大功能的用户,无一不被其卓越的表现所折服,纷纷称赞其巨好用。而在实际使用过程中,不同用户收获的效果却存在着显著的差异,这其中的关键因素,往往就体现在提问方式上。可以毫不夸张地说,掌握一套高效的提问方法论,就如同手握开启宝藏的钥匙,能让完美变身为你的 “职场军师”,为你在职场的复杂棋局中出谋划策;

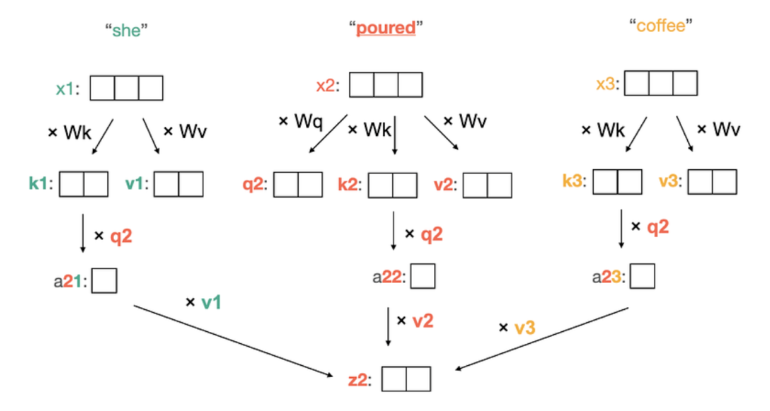

在深入研究 KV 缓存之前,我们需要先了解一下 transformer 中使用的注意力机制。了解它的工作原理是发现和理解 KV 缓存如何优化 transformer 推理的必要条件。当我们通过传递 “She” 来提示模型开始生成时,它将生成一个单词,例如“poured”(为了避免干扰,我们继续假设一个 token 是一个单词)。然后,我们可以将 “She poured” 传递给模型,它会生成 “c

a. 若智能体判定答案已足够完善,则返回给用户。b. 若智能体认为答案有待改进,则尝试改写用户查询并重复这个生成循环(generation loop)。此处体现了常规 RAG 与 Agentic RAG 的第二大差异。近期 Anthropic 的开源项目 MCP,将为 Agentic RAG 的开发提供强劲助力。

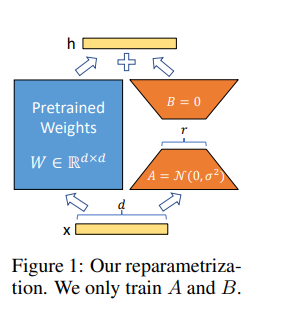

全参数微调是一种较为传统的微调方式,它对大模型的所有参数进行更新和优化。这种方式的优势在于能够让模型在特定任务上进行充分的学习和调整,从而达到较好的性能。例如,一个拥有数十亿参数的大语言模型在进行全参数微调时,可以针对特定的文本生成任务,如新闻报道生成,通过对所有参数的调整,使模型生成的新闻内容更加符合新闻的语言风格和逻辑结构,准确率可以提升15% - 25%左右。然而,全参数微调的缺点也十分明显