简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

导言:超越 $Mutex$ 的并发性能在并发编程领域,我们追求的目标始终是:最大化利用多核 CPU 资源,同时最小化线程间的同步开销。一个朴素的生产者-消费者模型,通常依赖一个全局的、受 $Mutex$ 保护的任务队列。然而,在高并发场景下,这个全局锁会迅速成为性能瓶颈,导致“一核工作,多核围观”。Work-Stealing 算法正是在这种背景下诞生的。它是一种的调度策略,被广泛应用于 Cilk、

摘要(150字): Docker网络通过四种模式实现容器互联与隔离:默认Bridge模式需端口映射对外通信;Host模式共享宿主机网卡提升性能;None模式完全断网保障安全;Container模式实现容器间localhost直连。核心痛点是默认Bridge网络的IP动态变化问题,解决方案是创建自定义网络实现基于容器名的DNS解析。Docker Compose自动构建项目专属网络,服务间可直接通过服

注意力机制:信息加权的数学游戏 注意力机制是AI领域的核心突破,本质是通过动态加权实现信息筛选。生物因算力限制进化出注意力(如鸡尾酒会效应),AI则通过数学建模解决类似问题。传统RNN因固定长度向量导致信息瓶颈,而注意力机制通过查询(Q)、键(K)、值(V)的交互实现动态权重分配:计算相似度→归一化为概率→加权求和。这种机制赋予模型语境感知能力,如Transformer的多头注意力可并行捕捉语法、

在机器学习界有一句名言:**"You get what you optimize for."(你得到的就是你优化的。)**如果你发现你的模型对异常值极其敏感,或者在分类时盲目自信,又或者在小样本类别上彻底躺平,请不要急着怪罪网络结构或数据。通常情况下,罪魁祸首是你选错了损失函数。损失函数不仅是一个数学公式,它是模型与现实世界之间的**契约**。本文将从回归、分类、正则化以及高维空间几何四个维度,深

摘要:2024-2025年是AI工程化落地的关键时期,但基础设施成为主要瓶颈。Kurator作为分布式云原生平台,通过整合Volcano调度器、Karmada多云编排和KubeEdge边缘计算,有效解决AI工程化的三大挑战:算力资源弹性调度、分布式训练复杂性和多云管理碎片化。平台支持大模型训练、边缘AI推理和MLOps实验平台等场景,显著提升资源利用率并降低成本。未来,Kurator有望通过增强A

本文系统梳理了边缘检测的技术发展脉络。从早期Roberts、Prewitt和Sobel等基础微分算子入手,分析了它们通过像素差分检测边缘的原理及优缺点。重点讲解了Canny算子的创新性四步流程:高斯滤波降噪、梯度计算、非极大值抑制和双阈值检测,揭示了其实现边缘精确定位与噪声抑制的设计思想。文章还对比了不同场景下算子选择的工程策略,并强调高斯预处理的关键作用。这些经典算法为现代计算机视觉中的特征提取

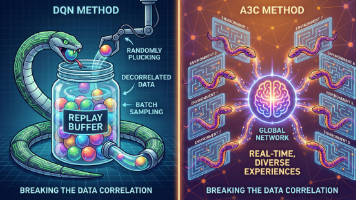

A3C/A2C算法通过并行化解决了强化学习中的样本相关性难题。A3C采用异步多线程架构,每个Worker独立探索并异步更新全局网络,利用N-step回报计算优势函数;A2C改为同步更新,所有Worker数据打包后统一训练。并行化实现了三大突破:增强状态空间遍历性、替代经验回放池、保持On-Policy训练稳定性。这种"算力换算法"的思想奠定了分布式强化学习的基础,后续PPO、I

摘要: 多智能体强化学习早期面临独立学习(IQL)的非平稳性与完全中心化的通信瓶颈问题。CTDE(中心化训练,去中心化执行)范式通过训练阶段利用全局信息(Critic)与执行阶段依赖局部观测(Actor)解决了这一矛盾。MADDPG作为CTDE的代表算法,其Critic网络输入所有智能体的状态与动作以稳定Q值学习,而Actor仅基于自身观测决策。代码实现中,Critic需拼接全局信息,Actor则

摘要:ModelEngine作为AI应用开发平台,从知识库构建到多智能体协作提供全链路支持。其亮点包括:知识库自动生成摘要功能,提升检索置信度;Prompt自动增强可将简单指令转化为结构化提示词;所见即所得的调试台支持实时预览修改效果;独有的MCP服务让Agent具备本地工具调用能力。相比Dify和Coze等平台,ModelEngine在多源工具集成和调试透明度方面更具优势,既降低了开发门槛,又提

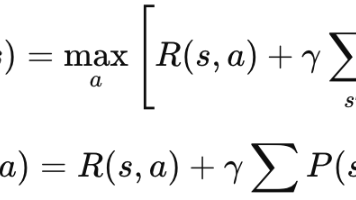

本文用通俗语言解析强化学习的四大数学基础:1. MDP(马尔可夫决策过程)是描述强化学习问题的框架,包含状态、动作、转移概率和奖励;2. 奖励函数是智能体的评分系统,即时奖励和考虑未来折扣的累积奖励;3. 策略是智能体的行动指南,分为确定性策略和随机策略;4. 价值函数评估状态或动作的长期价值,包括状态价值函数V(s)和动作价值函数Q(s,a)。文章还解释了核心的贝尔曼方程,并提供了公式速查表和常