简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

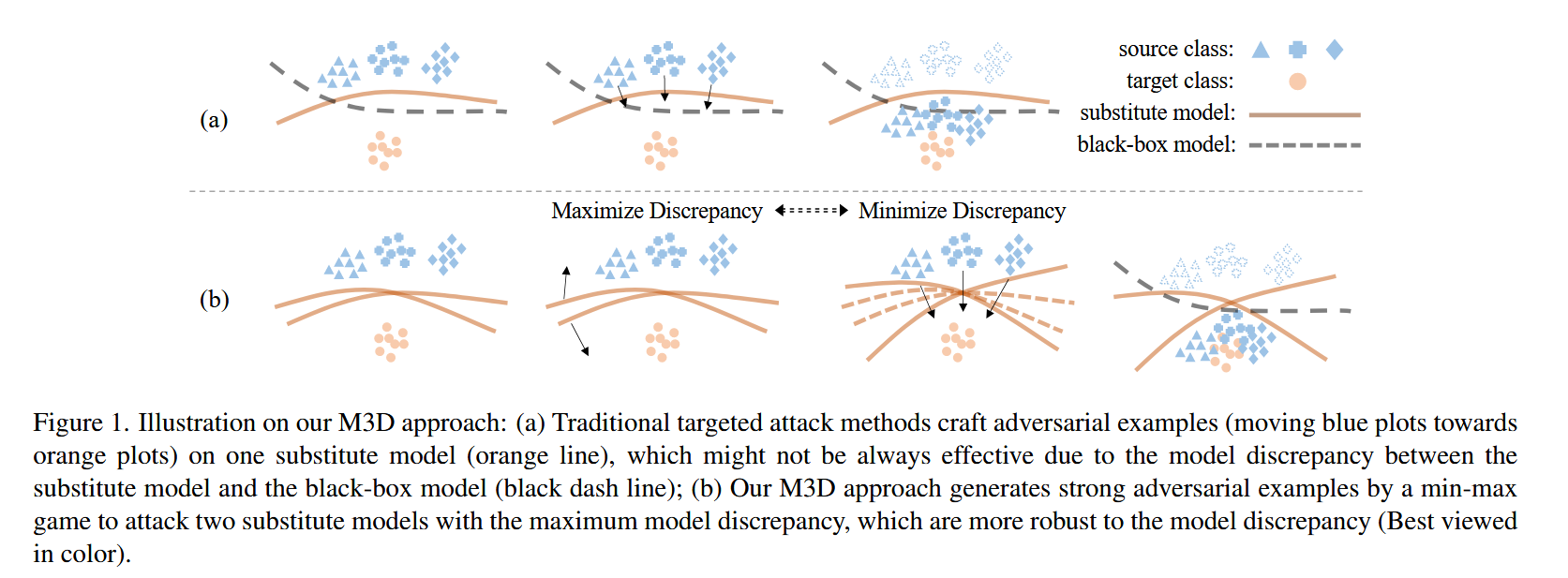

本文 “Minimizing Maximum Model Discrepancy for Transferable Black-box Targeted Attacks” 从模型差异视角研究黑盒有针对性攻击问题,提出泛化误差界并设计 M3D 攻击算法,实验结果显著优于现有方法。

本文 “Maximizing the Position Embedding for Vision Transformers with Global Average Pooling” 提出 MPVG 方法,用于解决视觉 Transformer 中全局平均池化(GAP)与分层结构结合时位置嵌入(PE)的问题。

本文 “LibraGrad: Balancing Gradient Flow for Universally Better Vision Transformer Attributions” 指出基于梯度的解释方法在 Transformer 中存在梯度流不平衡问题,导致归因不忠实。为此提出 LibraGrad,这是一种通过修剪和缩放反向路径来纠正梯度不平衡的后处理方法,且不改变前向传递和增加计算开销

本文 “Delving Into Transferable Adversarial Examples And Black-Box Attacks” 首次在ImageNet模型上广泛研究对抗样本可迁移性,表明现有方法对非目标性攻击有效,但目标攻击方法难生成可迁移样本,提出基于集成模型的方法,首次实现大量目标对抗样本迁移;首次展示为ImageNet训练模型生成的目标对抗样本可迁移至未知的Clarifa

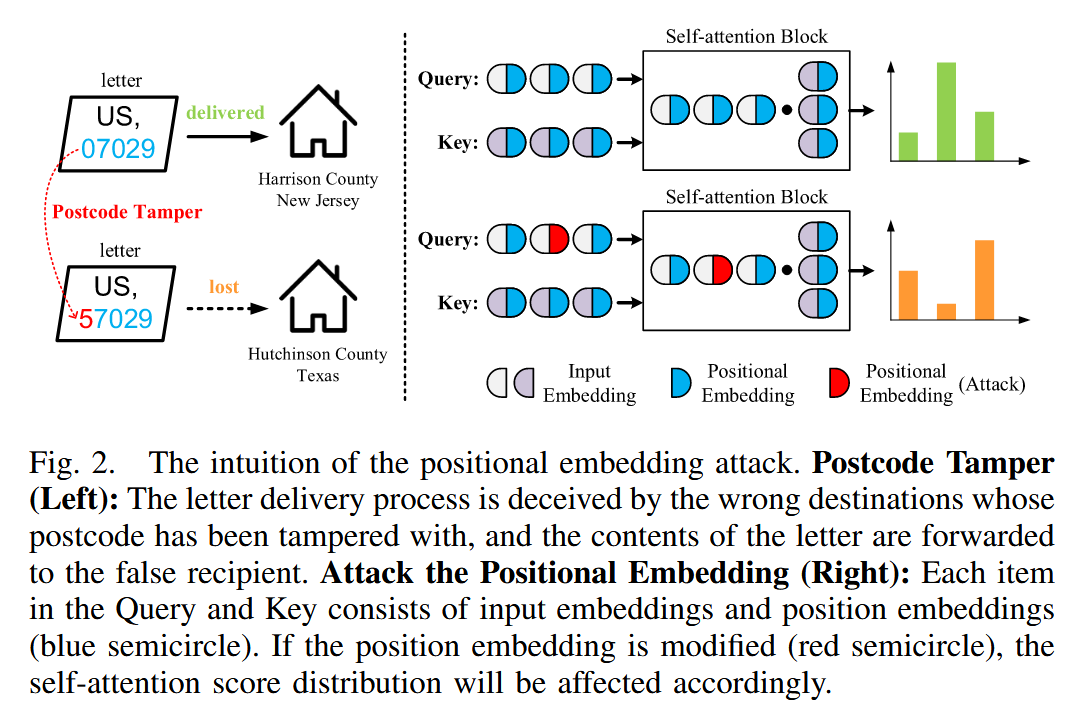

本文 “PE-Attack: On the Universal Positional Embedding Vulnerability in Transformer-Based Models” 指出 Transformer 模型中位置嵌入(PEs)存在潜在漏洞。

本文 “Not All Prompts Are Secure: A Switchable Backdoor Attack Against Pre-trained Vision Transfomers” 提出了一种针对预训练视觉 Transformer 的可切换后门攻击方法 SWARM,揭示了预训练并提示范式下的安全威胁,通过实验验证了攻击的有效性和隐蔽性,为后续防御研究提供了方向。

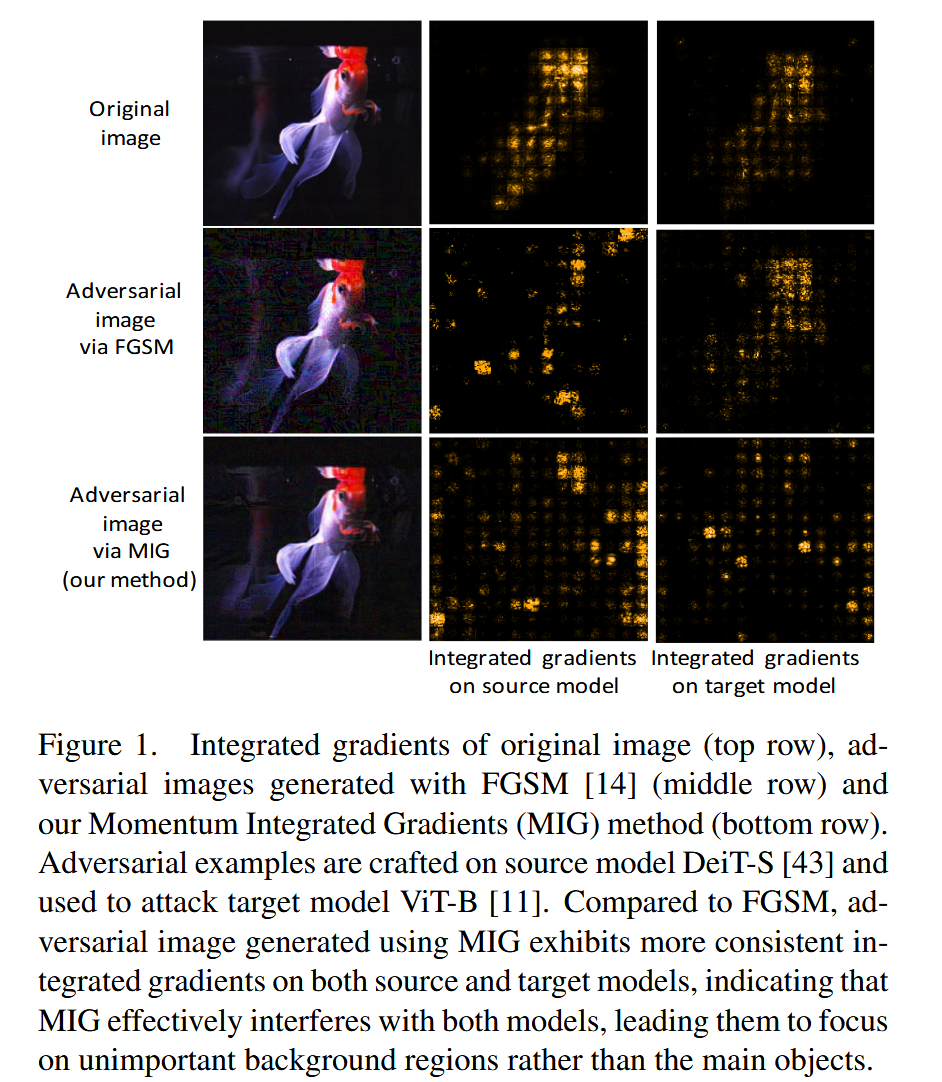

本文 “Transferable Adversarial Attack for Both Vision Transformers and Convolutional Networks via Momentum Integrated Gradients” 提出了动量积分梯度(MIG)攻击方法,利用积分梯度和动量迭代策略,有效攻击视觉 Transformer(ViTs)和卷积神经网络(CNNs),提升

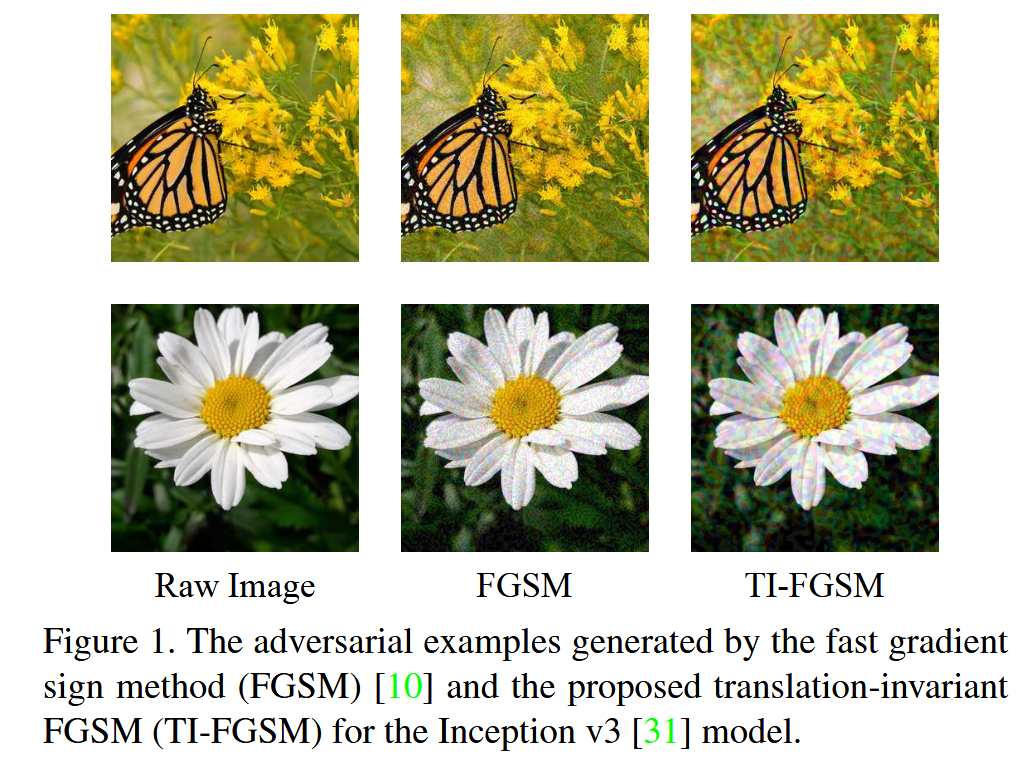

本文 “Evading Defenses to Transferable Adversarial Examples by Translation-Invariant Attacks” 针对防御模型对可迁移对抗样本的抵抗性,提出一种平移不变性攻击方法,通过对一组平移图像优化生成对抗样本,使其对被攻击白盒模型的判别区域不敏感,从而提高对防御模型的可迁移性,实验证明该方法能有效提升黑盒攻击成功率,暴露了

本文 “TAPT: Test-Time Adversarial Prompt Tuning for Robust Inference in Vision-Language Models” 提出一种测试时对抗提示调整(TAPT)方法,以增强视觉语言模型(VLMs)在推理时的鲁棒性。通过在 11 个基准数据集上的实验,证明 TAPT 能有效提升模型对抗攻击的能力,且保持在干净样本上的性能。

本文 “Boosting Adversarial Transferability with Spatial Adversarial Alignment” 提出空间对抗对齐(SAA)技术,通过空间感知对齐和对抗感知对齐,利用对齐损失和见证模型微调代理模型,显著提升对抗样本的迁移性,特别是在跨架构攻击场景中。