简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

我这边离线机器跑起来居然没有报错,成功后可以访问10012端口看看,一般会显示detail Not Found,访问后缀加/web/index.html即可进入聊天页面。其中gguf_path为gguf文件路径,需要有config配置文件在同一路径;记录一次在离线机器上使用kt框架部署Deepseek:671B模型过程。model_path为模型路径,不知道为什么没有后会报错(再看看;cpu_in

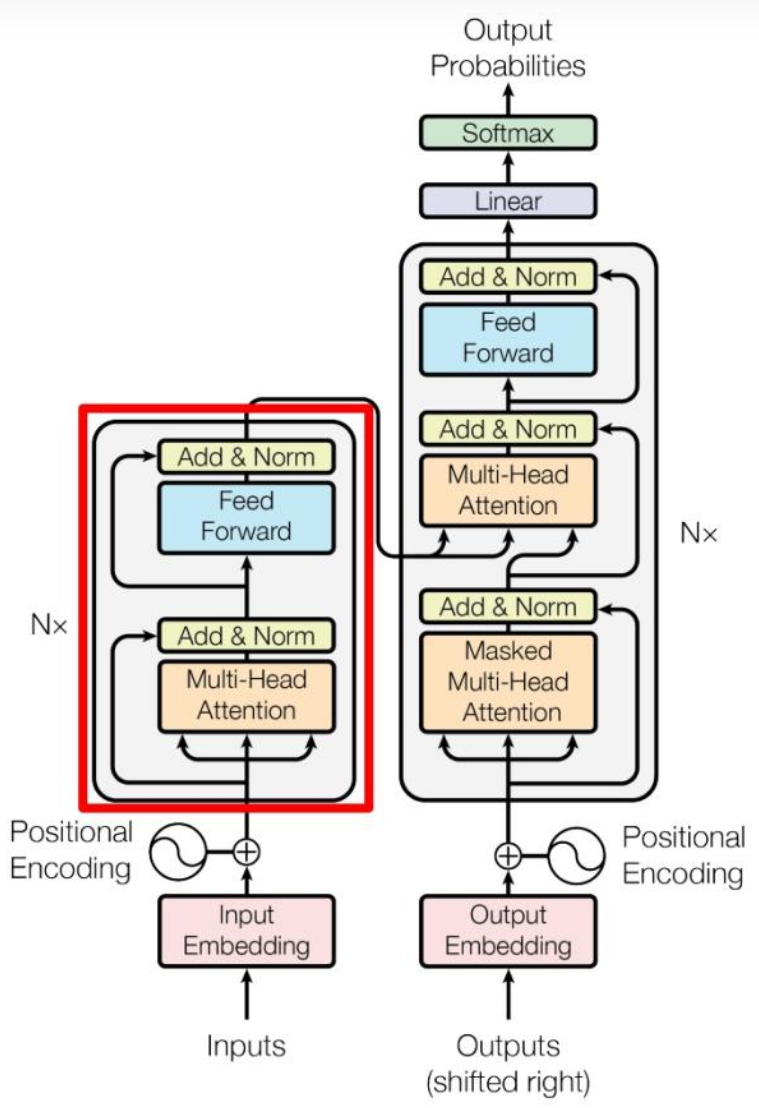

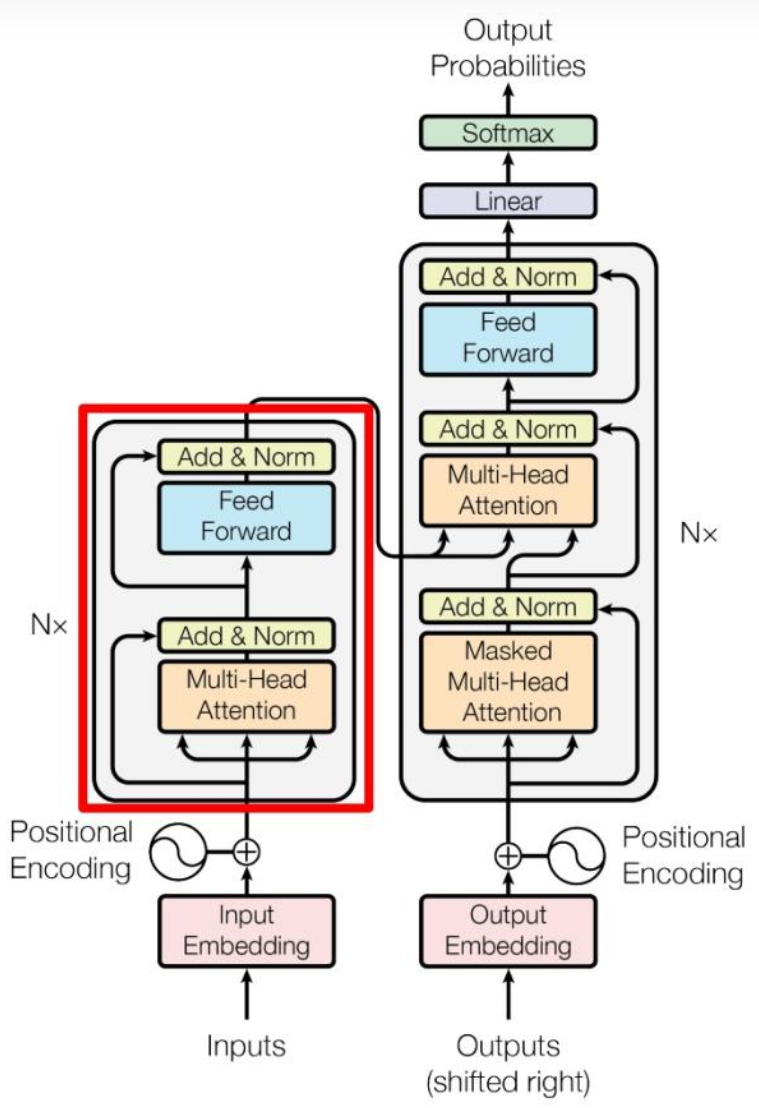

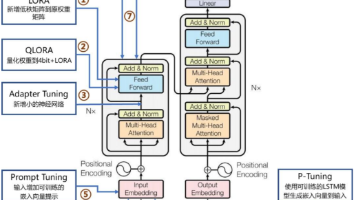

本文主要记录入门大模型学习的相关知识,以期为后续工作学习提供帮助。(除了我自己截图外,引用的我尽量标注来源,有些忘记来源了请告诉我orz)

新版本本地化的fastgpt接入重排模型

本文以DeepSeek-R1-Distill-Qwen-7B大模型为例,详细解析了大模型文件的结构及其参数意义。主要文件包括config.json(模型架构配置)、generation_config.json(生成控制配置)、tokenizer_config.json(分词器配置)及model.safetensors(模型权重文件)等。文章对比了不同模型文件的差异,如DeepSeek与Qwen系列

本文以DeepSeek-R1-Distill-Qwen-7B大模型为例,详细解析了大模型文件的结构及其参数意义。主要文件包括config.json(模型架构配置)、generation_config.json(生成控制配置)、tokenizer_config.json(分词器配置)及model.safetensors(模型权重文件)等。文章对比了不同模型文件的差异,如DeepSeek与Qwen系列

本文主要记录入门大模型学习的相关知识,以期为后续工作学习提供帮助。(除了我自己截图外,引用的我尽量标注来源,有些忘记来源了请告诉我orz)

摘要:DeepSeek大模型系列通过技术创新持续演进,从DeepSeek-V2的MoE架构到V3引入MTP、FP8混合精度训练等技术,再到DeepSeek-R1采用强化学习框架GRPO和蒸馏技术。MoE架构通过细粒度专家划分和共享专家策略优化计算效率,MLA技术则通过低秩压缩减少KVcache显存占用。微调方法包括LoRA、AdapterTuning等,强化学习方面PPO、DPO和GRPO各有特点

在机器学习中,我们使用随机采样方法,从数据集D划分训练集和测试(验证)集进行模型的选择,也就是人工智能中模型评估常用的三种方法:留出法、交叉验证法和自助法(其中留出法也叫简单的交叉验证法)。本文则针对其中交叉验证法和自助法的异同进行探讨。ps:本文主要为个人查询网络资料的总结,便于后续的学习过程,如有不妥,敬请指教。

新版本本地化的fastgpt接入重排模型

新版本本地化的fastgpt接入重排模型