简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

咱们先得想明白一个最基本的问题:AI的出现,到底让什么东西变得“不值钱”了?说白了,就是那些“模式化”的、“有标准答案”的、“无需太多思考”的编码工作,变得越来越廉价。比如,写个“登录注册”模块,实现个“冒泡排序”,或者根据一个明确的需求文档,把业务逻辑翻译成if-else。在过去,这些活儿是一个初级程序员价值的主要体现。你能熟练地把产品经理的“人话”,翻译成机器能懂的“鬼话”,你就能领一份薪水。

如今,AI的发展趋势非常之猛,作为普通人的我们并不能改变什么,前两天熊猫翻招聘软件甚至看到一些公司已经开始将熟练使用AI作为招聘要求了。技术的发展并不会取代人,但不会新技术的人一定会被其他人取代。

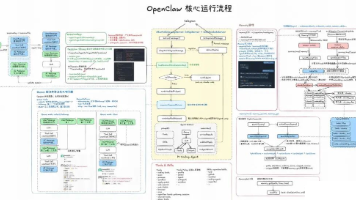

OpenClaw 是一个通过Gateway,连接即时通讯平台(Channel, 如 Telegram、Discord、Slack 等)与本地AI Agent ,能24×7 运行的个人助手。它不仅仅是一个简单的消息转发器,而是一个具备完整。

“爬虫”是一种形象的说法。互联网比喻成一张大网,爬虫是一个程序或脚本在这种大网上爬走。碰到虫子(资源),若是所需的资源就获取或下载下来。这个资源通常是网页、文件等等。可以通过该资源里面的url链接,顺藤摸瓜继续爬取这些链接的资源。

本文分享了作者28天内推152家公司、狂面33场,最终拿下4个50k+AI大模型应用开发Offer的求职经历,并推出完整学习清单。文章强调AI大模型是2026年风口,建议有后端基础的朋友转岗,或了解大模型、RAG、Prompt、Agent等概念以提升求职竞争力。提供6大学习模块:大模型基础认知、核心技术模块、开发基础能力、应用场景开发、项目落地流程、面试求职冲刺,帮助读者快速入门并抓住AI机遇。2

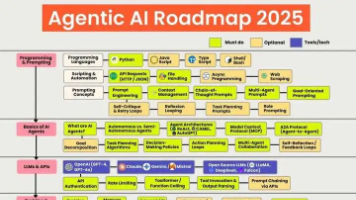

这张图系统梳理从 0 到 1 构建智能体 AI所需的知识、工具与实践路径”。无论是初学者入门,还是开发者查漏补缺,都能通过它快速定位自己需要的技术方向、工具链,以及未来需要深入学习的领域。

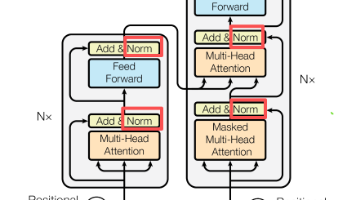

Transformer里归一化的核心,就是解决特征‘喧宾夺主’、训练不稳定、泛化能力差这3个问题。因为Transformer处理的是句子(序列长度不一样),而且训练大模型时Batch Size经常很小,所以不用BatchNorm,选LayerNorm——它单个样本就能算,不依赖其他样本,语义上也更合理。实战里,大厂都是优先用Pre-LN,解决深层训练崩掉的问题;

RAG(检索增强生成)技术通过检索外部知识库增强大模型回答能力,有效解决知识时效性、幻觉问题和私有数据接入难题。其工作流程包括检索相似文本、构建增强提示词并生成答案。搭建RAG系统仅需向量数据库、嵌入模型和大模型三组件,比微调更轻量灵活。尽管面临检索质量、上下文限制等挑战,但通过高级RAG、GraphRAG等优化方案可提升性能。该技术正推动AI时代的知识问答革新,相关技能成为就业市场新热点。

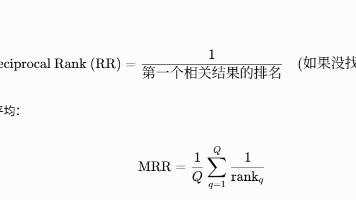

本文详细介绍了Embedding模型的工作原理及其评估方法。通过分布式假设将文本转化为向量,解释了向量维度与语义特征的关系。重点分析了Recall@K和MRR等评估指标在不同场景下的适用性,并推荐参考MTEB排行榜进行模型选型。文章还列举了实际应用中需要考虑的关键因素,包括任务性质、领域特性、多语言支持等,强调应根据业务需求和技术约束选择最合适的模型。最后指出AI时代掌握大模型技能的重要性,并提供

本文围绕LLM高效微调的核心知识点,拆解了主流方法、LoRA原理、数据准备、硬件选型、模型评估五大模块,补充了大量行业实践细节和权威延伸知识,核心逻辑可总结为三句话:•1. 高效微调的本质:“冻结核心,训练细节”,通过少量参数的训练,让通用模型适配垂直任务,实现“小成本、高收益”;•2. LoRA是当前最优解:兼顾效果、速度、存储成本,适配绝大多数场景,是个人和企业微调的首选方法;•3. 微调成功