简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

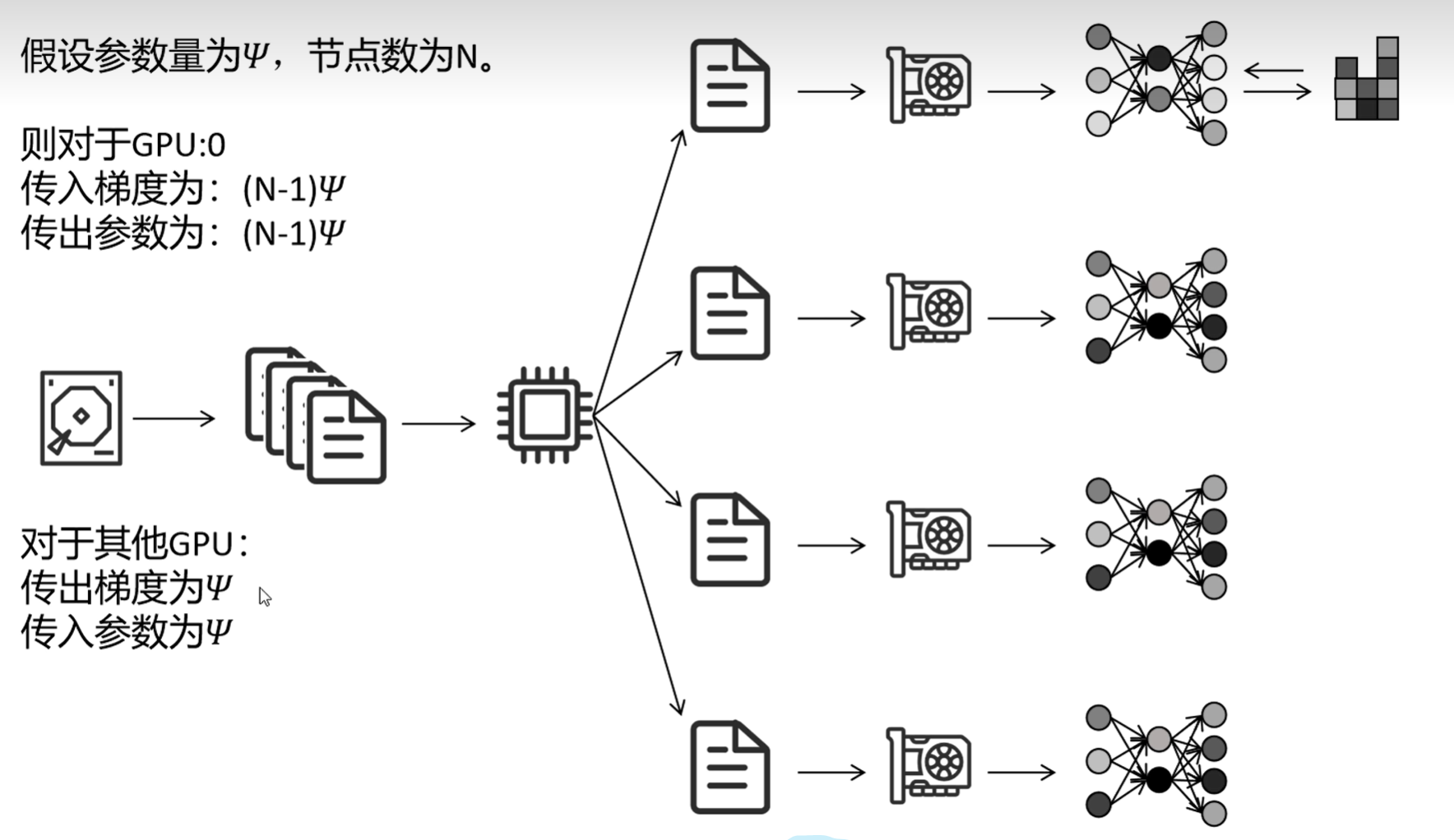

在大规模深度学习训练中,随着模型参数规模和硬件集群规模不断增长,单卡训练已难以满足内存与吞吐需求。以下从,以及微软 DeepSpeed 针对极大模型提出的1/2/3 三个阶段,逐一介绍它们的原理、优势与适用场景。

结构特性:卷积层提取空间特征,池化层增强鲁棒性数学本质:局部连接 + 权值共享工程价值:计算机视觉任务的基础架构%20bn%29%20x。

结构本质:通过时间步循环传递隐藏状态,建模序列依赖核心缺陷:基础RNN存在梯度消失/爆炸,需LSTM/GRU优化工程价值:语音、文本等时序任务的基础架构%20b_h%29%20b_y%29%20b_i%29%20b_f%29%20b_z%29%20b_r%29%20b_h%29%20b_y。

测试对比# 输出: x=0.5: ReLU=0.50, GELU=0.34, Mish=0.41激活函数的演变史反应了深度学习对非线性认知的深化。

MIT CSAIL实验室主任Antonio Torralba教授指出:"Grad-CAM不仅解决了'模型如何决策'的问题,更开启了'如何优化模型决策'的新研究范式。"当医疗影像系统通过热力图展示其对病灶区域的关注,而不仅给出诊断结果时,医患之间的信任鸿沟正在被技术弥合。Grad-CAM是一种可视化深度学习决策机制的技术,它像医学扫描仪一样,能够揭示神经网络在识别图像时的"注意力焦点"。Grad-C

损失函数设计是深度学习工程中微妙的平衡艺术——在数学严谨性与应用需求之间,在理论完备性与计算效率之间。