简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

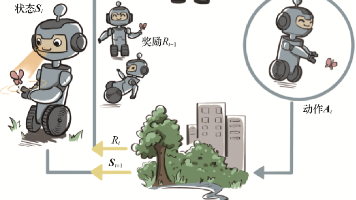

多智能体强化学习(Multi-Agent Reinforcement Learning, MARL,旨在解决多个智能体在共享环境中通过与环境和其他智能体交互来学习最优策略的问题。

强化学习(Reinforcement Learning,简称RL)是机器学习的一个分支,其主要关注如何使智能体(Agent)通过与环境的交互学习,以在面临不同情境时做出最优决策。在强化学习中,智能体通过试错过程,通过观察环境的反馈(奖励或惩罚)来调整其行为,从而最大化累积奖励。1.序贯决策问题: 强化学习适用于需要按照一系列动作来达到某个目标的问题,这些问题通常是序列型的,每个动作的影响可能取决于

在强化学习(Reinforcement Learning, RL)中,、 和是几个关键概念,它们各自有不同的含义和作用。下面是对这三个概念的详细解释及其区别与联系:定义:作用:示例:定义:作用:示例:定义:作用:示例:层次不同:用途不同:定义方式不同:共同目标:相互依赖:动态关系:、 和在强化学习中扮演着不同的角色,但它们之间又存在紧密的联系,共同推动着强化学习算法的学习过程。

表达式: ( \text{Swish}(x) = x \cdot \sigma(\beta x) ),其中 ( \sigma ) 是 Sigmoid 函数。表达式: ( \text{Leaky ReLU}(x) = \max(\alpha x, x) ),其中 ( \alpha ) 是一个小的正数。表达式: ( \text{PReLU}(x) = \max(\alpha x, x) ),其中 (

1.2.

这个就不用多说了,你都可以上GPT帐号了,哈……

看了文档的评测,tianshou速度快过所有的强化学习库,但是功能上还不够完全,多智能体等算法未实现,可能要考虑转向ray了,ray作为一个分布式框架,就不禁让我想起了spark和mllib令我奔溃的日子。本人因为一些比赛的原因,有使用到强化学习,但是因为过于紧张与没有尝试快速复现强化学习的代码,并没有获得很好的成绩,故尝试用库进行快速复现。上面都是脚本式的运作,将参数定义在args里面相对的方便

好的,我们来详细、清晰地重新回答这个问题:如何比较 main.tex 的两个不同版本(旧版和新版),并生成一个带有修改标记(删除线、高亮、修订注释)的 PDF 或文本输出?这个问题的标准解决方案是使用一个名为 latexdiff 的专用工具。latexdiff 能够智能地分析两个 LaTeX 源文件的差异,并生成一个全新的、可编译的 LaTeX 文件,其中包含了所有修改的视觉标记。🛠 解决方案:

在 LaTeX 中,从主文件 main.tex 调用另一个文件 branch.tex 中的部分内容,最常用且推荐的方法是使用 \input 或 \include 命令,并结合 \includeonly 命令来实现选择性编译。将 branch.tex 的不同部分分别保存为独立的 .tex 文件(例如 sec1.tex, sec2.tex),然后在 main.tex 中按需调用。这样,main.tex

表达式: ( \text{Swish}(x) = x \cdot \sigma(\beta x) ),其中 ( \sigma ) 是 Sigmoid 函数。表达式: ( \text{Leaky ReLU}(x) = \max(\alpha x, x) ),其中 ( \alpha ) 是一个小的正数。表达式: ( \text{PReLU}(x) = \max(\alpha x, x) ),其中 (