简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

主要关注点在于安全应用程序领域,深入研究利用 LLM 发起网络攻击。

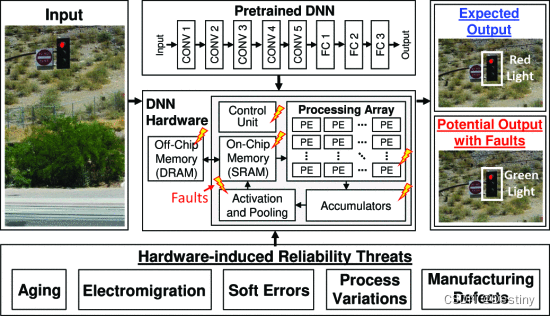

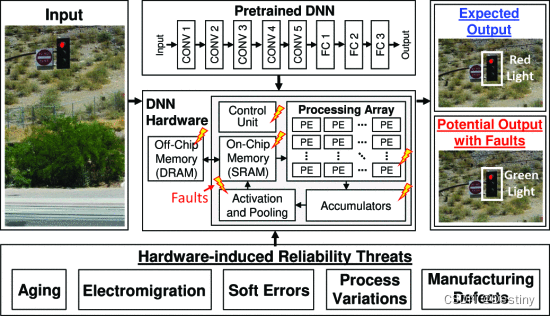

由于激进的技术扩展,现代系统越来越容易受到可靠性威胁的影响,例如软错误、老化和工艺变化。这些威胁在硬件级别表现为位翻转,并且根据位置,可能会损坏输出,从而导致不准确或潜在的灾难性结果。传统的缓解技术基于冗余,例如双模块化冗余 (DMR) [16] 和三重模块化冗余 (TMR) [17]。然而,由于 DNN 的计算密集型性质,这些技术会导致巨大的开销,对系统的效率产生负面影响。纠错码 (ECC) 和

由于激进的技术扩展,现代系统越来越容易受到可靠性威胁的影响,例如软错误、老化和工艺变化。这些威胁在硬件级别表现为位翻转,并且根据位置,可能会损坏输出,从而导致不准确或潜在的灾难性结果。传统的缓解技术基于冗余,例如双模块化冗余 (DMR) [16] 和三重模块化冗余 (TMR) [17]。然而,由于 DNN 的计算密集型性质,这些技术会导致巨大的开销,对系统的效率产生负面影响。纠错码 (ECC) 和

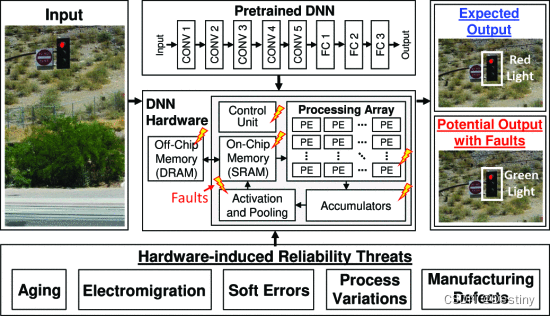

Hign Level设计安全威胁模型用法内存安全问题在本指南中,我们将探讨机密计算在现代计算平台中的作用,并解释机密计算的原理。然后,我们将介绍 Arm 机密计算架构 (Arm CCA) 如何在 Arm 计算平台中实现机密计算。定义机密计算描述一个复杂的系统信任链了解 Realm 是由 Arm CCA 引入的受保护的执行环境解释如何在 Arm CCA 的实现上创建、管理和执行 Realm定义可信执

主要关注点在于安全应用程序领域,深入研究利用 LLM 发起网络攻击。

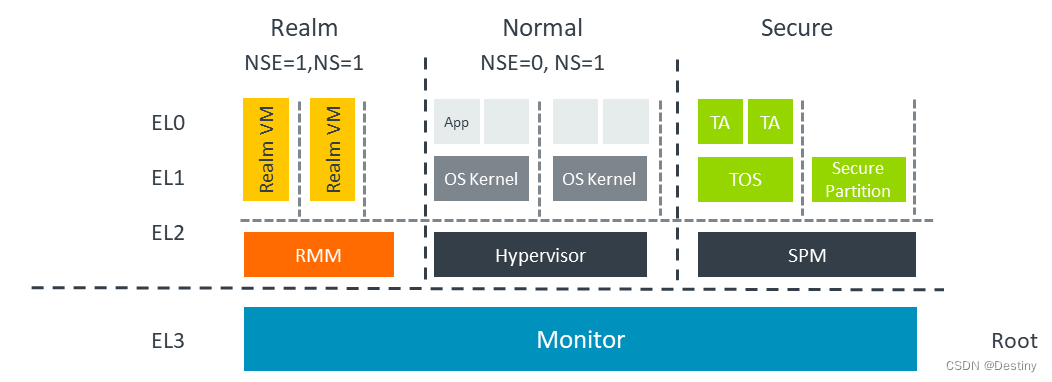

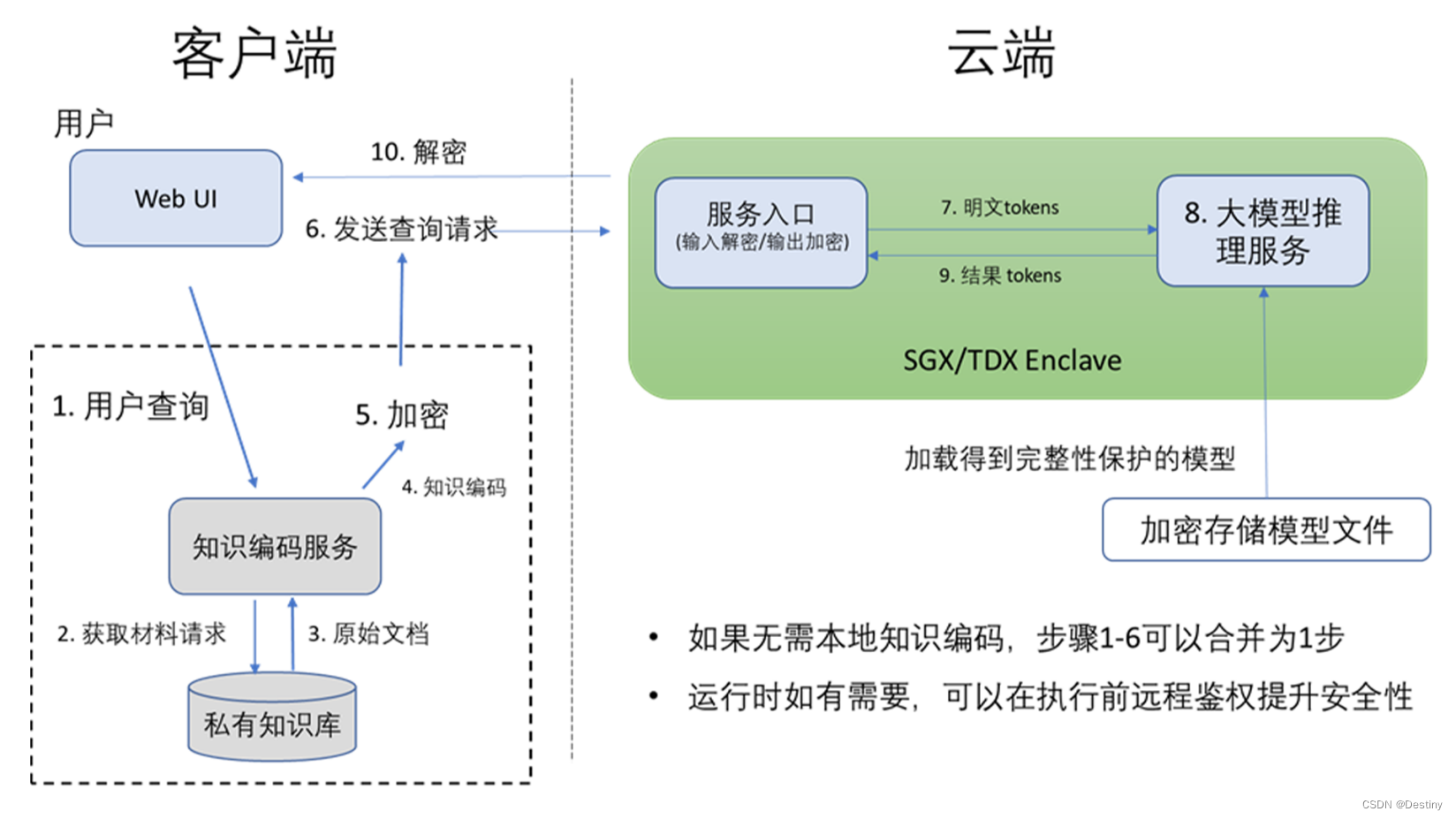

当交换完成时,GPU 驱动程序和 SEC2 都持有相同的对称会话密钥。在大模型公有云服务方面,以百度、阿里等为代表的互联网与云服务公司,从大模型全生命周期视角出发,涵盖大模型训练、精调、推理、大模型部署、大模型运营等关键阶段面临的安全风险与业务挑战,在自有技术体系内进行深入布局,探索打造安全产品与服务。360等第三方独立的人工智能与安全科技公司,探索“以模型管理模型”方式,打造以大模型为核心的AI

由于激进的技术扩展,现代系统越来越容易受到可靠性威胁的影响,例如软错误、老化和工艺变化。这些威胁在硬件级别表现为位翻转,并且根据位置,可能会损坏输出,从而导致不准确或潜在的灾难性结果。传统的缓解技术基于冗余,例如双模块化冗余 (DMR) [16] 和三重模块化冗余 (TMR) [17]。然而,由于 DNN 的计算密集型性质,这些技术会导致巨大的开销,对系统的效率产生负面影响。纠错码 (ECC) 和

当交换完成时,GPU 驱动程序和 SEC2 都持有相同的对称会话密钥。在大模型公有云服务方面,以百度、阿里等为代表的互联网与云服务公司,从大模型全生命周期视角出发,涵盖大模型训练、精调、推理、大模型部署、大模型运营等关键阶段面临的安全风险与业务挑战,在自有技术体系内进行深入布局,探索打造安全产品与服务。360等第三方独立的人工智能与安全科技公司,探索“以模型管理模型”方式,打造以大模型为核心的AI

主要关注点在于安全应用程序领域,深入研究利用 LLM 发起网络攻击。

在安全环境中,通过底层硬件隔离,不同执行级别,安全鉴权方式等方式,从最根本的安全机制上提供基于信任根(Root of Trust)的可信执行环境TEE(Trusted Execution Environment),通过可信服务(Trusted Services)接口与和通用环境REE(Rich Execution Environment)进行安全通信,可以保护TEE中的安全内容不能被非安全环境的任