简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

特征选择和特征工程

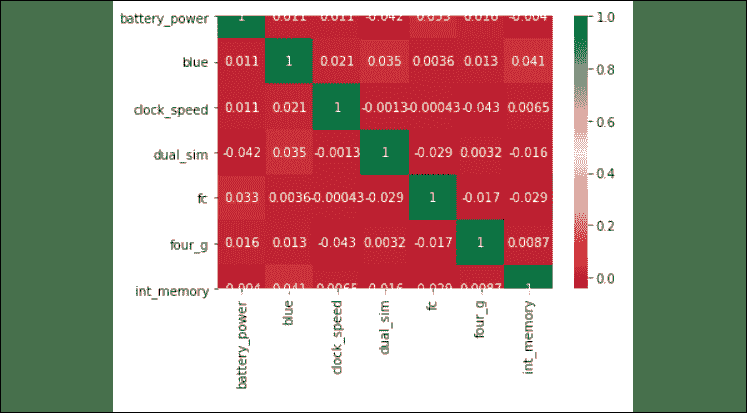

删除特征的一个重要原因是。因此,可以删除这些输入变量,而不会造成很多信息丢失。冗余和无关是两个截然不同的概念,因为一个相关特征在存在与之高度相关的另一个相关特征的情况下可能是多余的。在某些方面,特征工程与特征选择相反。使用特征选择,可以删除变量。在特征工程中,可以创建新变量来增强模型。在许多情况下,将使用领域知识进行增强。

李宏毅机器学习特训营-PM2.5预测

PM2.5预测课程链接:李宏毅课程-机器学习文章目录PM2.5预测数据集介绍1.数据分析1.1观察数据1.1特征抽取1.1数据分析1.1归一化2.训练3.测试4.预测5.保存数据集介绍本次作业使用丰原站的观测记录,分成 train set 跟 test set,train set 是丰原站每个月的前 20 天所有资料。test set 则是从丰原站剩下的资料中取样出来。train.csv: 每个月

到底了