简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

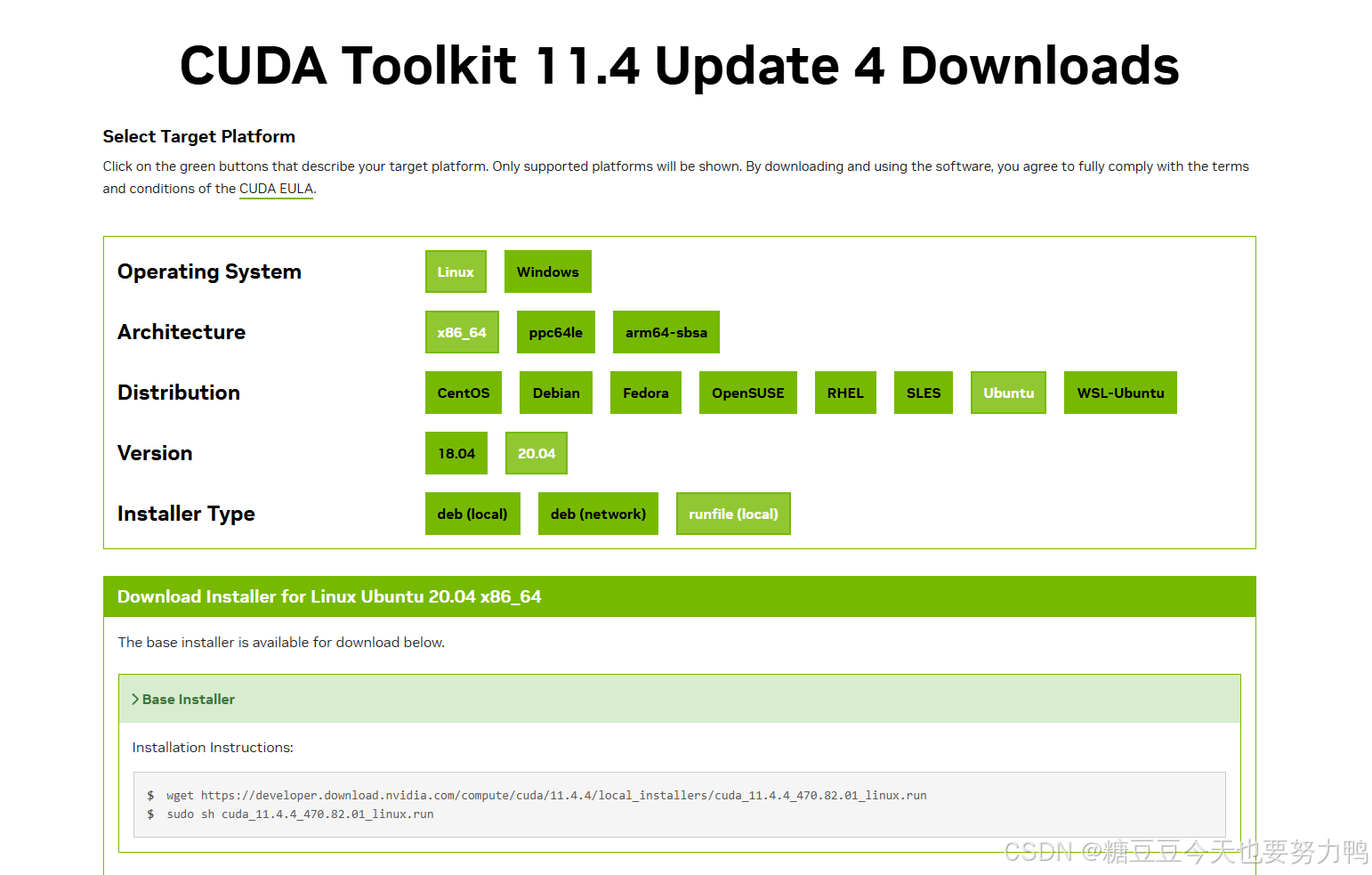

---------------------------------------------------一些碎碎念--------------------------------------------------------服务器的驱动掉了,得重装一个,在大佬的指点下飞速整了一个,记录一下。好在遇到的bug大多数都是见过的(把所有的坑都踩过了:))服务器是P4000的,选择如下,点查找。紧急来工位

是的还是这个代码。我又双叒叕遇到bug了。报错如题。解决方法:https://blog.csdn.net/qq_24282081/article/details/107087552我租的是矩池云的TeslaK80,算力3.7,按照上述博客改一下Makefile就行。但是!重新编译前要make clean一下,也就是把.o文件删掉,否则还是会报错的。(直接删应该也没问题)...

【转载】ImportError: libstdc++.so.6: version `GLIBCXX_3.4.29‘和ImportError: libcudart.so.10.0报错解决

4090安装cuda11.8记录

---------------------------------------------------一些碎碎念--------------------------------------------------------服务器的驱动掉了,得重装一个,在大佬的指点下飞速整了一个,记录一下。好在遇到的bug大多数都是见过的(把所有的坑都踩过了:))服务器是P4000的,选择如下,点查找。紧急来工位

报错解决:RuntimeError: CUDA error: no kernel image is available for execution on the device

---------------------------------------------------一些碎碎念--------------------------------------------------------服务器的驱动掉了,得重装一个,在大佬的指点下飞速整了一个,记录一下。好在遇到的bug大多数都是见过的(把所有的坑都踩过了:))服务器是P4000的,选择如下,点查找。紧急来工位

这几天纷纷扰扰的毕设事情,把自己搞得很烦。最难受的还是出力没讨好,还花了钱。想写点东西让自己冷静冷静。其实这篇文章去年就应该写了,但是由于一系列事情(主要是懒)一直没有动手,总算有了一点想写的欲望。就一点点来吧。一、前期准备我的本科专业是计算机科学与技术,这个专业啥都学,但啥也学不太深。啥都学是有好处的,我在思考研究生方向的时候纵览本科三年学过的科目,发现唯有一个数字图像处理是当时以及现在都比较感

【转载】scp用法及not a regular file报错解决

4090安装cuda11.8记录