简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

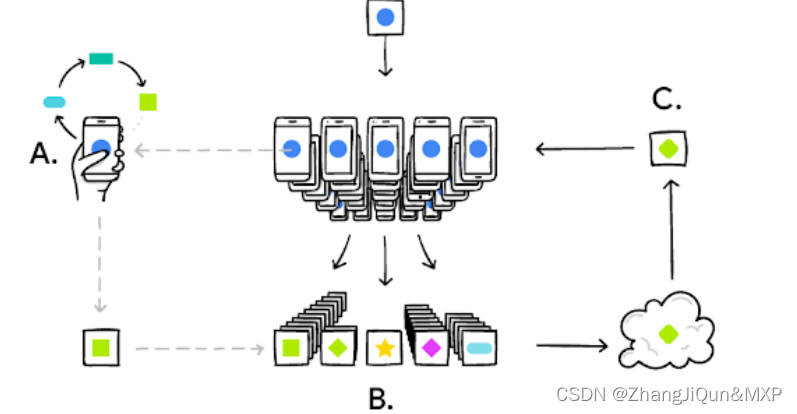

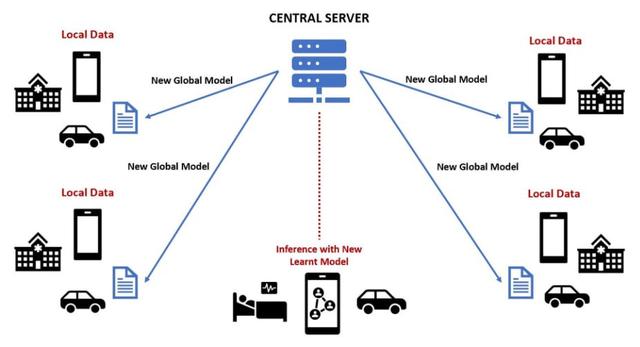

联邦学习系统客户端/服务器架构当参与方不少于两个时,启动联邦学习过程。在正式开始训练之前,中央服务器先将初始模型分发给各参与方然后各参与方根据本地数据集分别对所得模型进行训练各参与方将本地训练得到的模型参数加密上传至中央服务器中央服务器对所有模型梯度进行聚合,再将聚合后的全局模型参数加密传回至各参与方

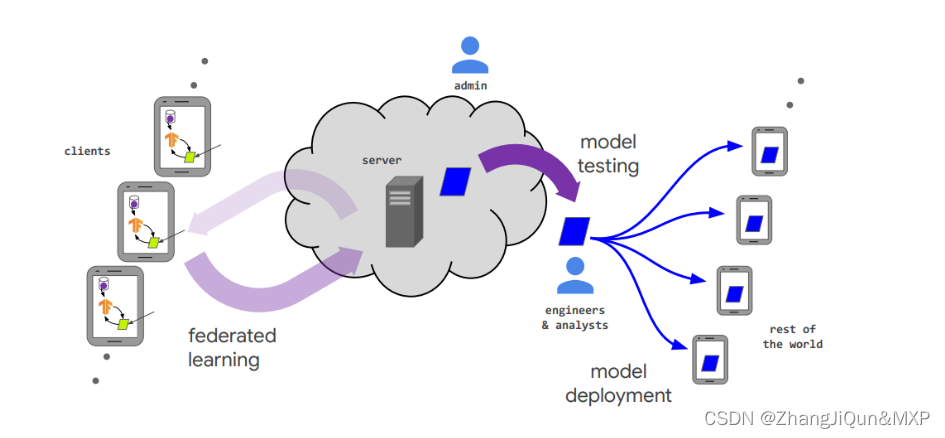

因此,编写TFF代码时会遇到非常多“反Python逻辑”的要求,例如:要求提供函数的输入参数的类型、要求使用它规定的几种数据类型、要求确定value的存放位置(S端/C端),原生Python逻辑不会在训练时执行等等。如果我们编写的一些函数使用到了不同端的数据,在真正执行的时候,一个函数甚至会被拆分到不同的机器上执行。在编写模型、训练代码的时候,clients和server应当是看作一个整体(也就是

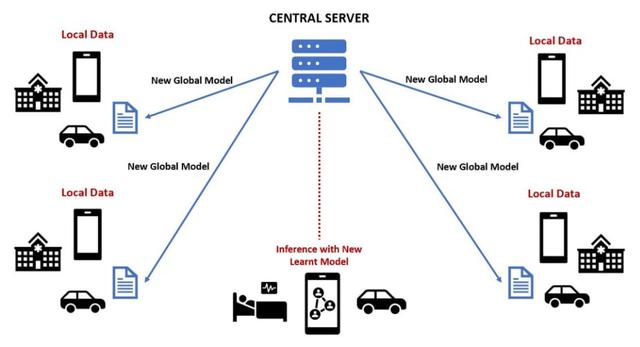

联合学习 (FL) 是一种出色的 ML 方法,它使多个设备(例如物联网 (IoT) 设备)或计算机能够在模型训练完成时进行协作,而无需共享它们的数据。“客户端”是 FL 中使用的计算机和设备,它们可以彼此完全分离并且拥有各自不同的数据,这些数据可以应用同不隐私策略,并由不同的组织拥有,并且彼此不能相互访问。使用 FL,模型可以在没有数据的情况下从更广泛的数据源中学习。FL 的广泛使用的领域如下:卫

智慧农业可以结合多种计算机理论实现创新,并发表相关文章。

联邦学习是一种分布式机器学习方法,中心节点为server(服务器),各分支节点为本地的client(设备)。联邦学习的模式是在各分支节点分别利用本地数据训练模型,再将训练好的模型汇合到中心节点,获得一个更好的全局模型。联邦学习的提出是为了充分利用用户的数据特征训练效果更佳的模型,同时,为了保证隐私,联邦学习在训练过程中,server和clients之间通信的是模型的参数(或梯度、参数更新量),本地

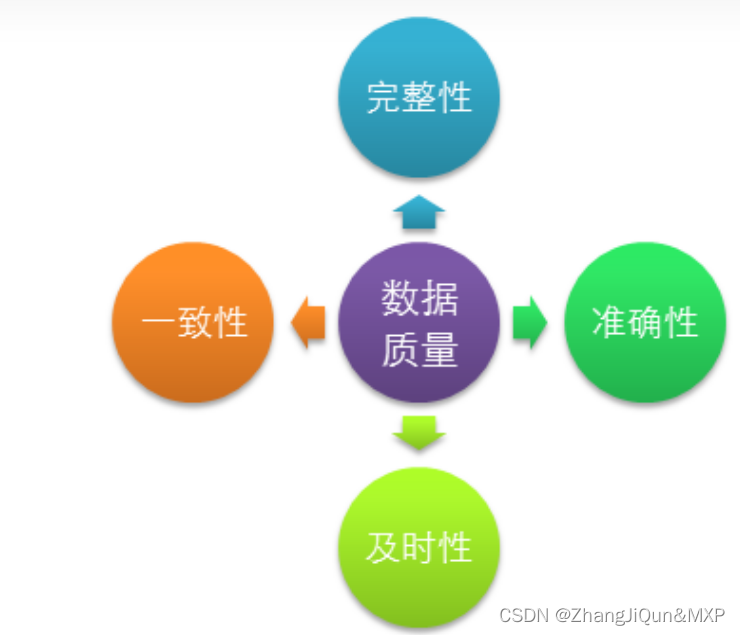

为了评估数据的质量,可以从每个参与方的数据中随机抽样一部分数据,构建一个验证集,并使用该验证集来评估模型的性能。数据融合可以将多个参与方的数据集合并为一个数据集,使用标准的数据质量评估方法对数据集进行评估。联邦学习中的数据质量评估需要结合具体的场景和任务来进行,并采取适当的方法和技术来确保数据的质量。在实际应用中,需要根据联邦学习的特点和需求选择合适的方法,以确保数据的质量和模型的性能。在联邦学习

联合学习 (FL) 是一种出色的 ML 方法,它使多个设备(例如物联网 (IoT) 设备)或计算机能够在模型训练完成时进行协作,而无需共享它们的数据。“客户端”是 FL 中使用的计算机和设备,它们可以彼此完全分离并且拥有各自不同的数据,这些数据可以应用同不隐私策略,并由不同的组织拥有,并且彼此不能相互访问。由于数据隐私对于许多应用程序(例如医疗数据)来说是一个大问题,因此 FL 主要用于保护客户的

1. 基于信任度的节点选择:在联邦学习中,可以通过一些机制来评估节点的信任度,例如节点的历史参与情况、节点所在机构的信誉等等。2. 基于模型贡献度的利益分配:根据每个数据提供者的模型贡献度来进行利益分配,即数据提供者上传的模型对最终模型的贡献越大,其获得的利益也越多。3. 然后,对于每个参与方,我们计算其上传模型准确率与平均准确率之间的差值,即 $d_i = |A_i - A_m|$,其中 $A_

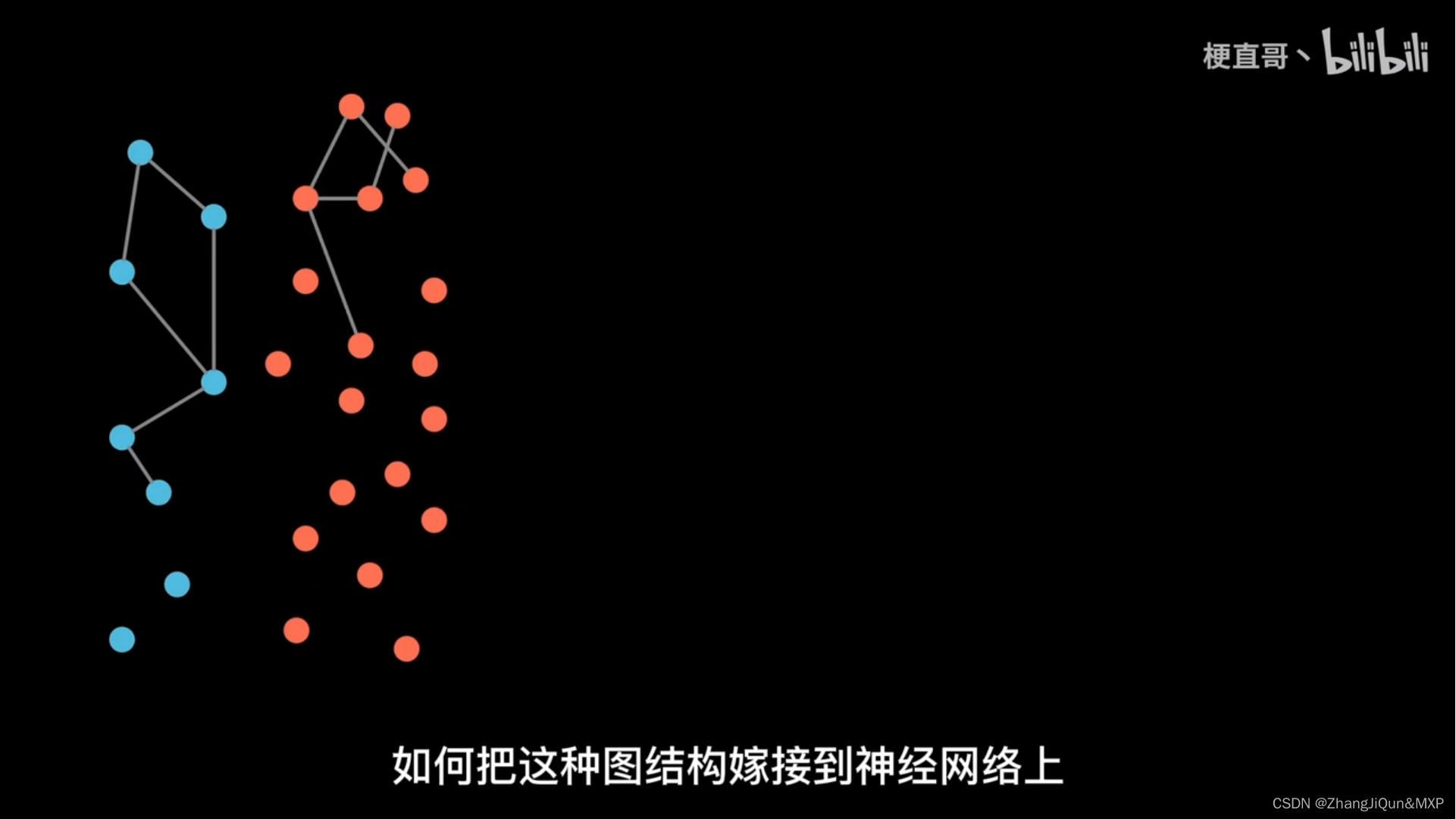

欧氏空间中神经网络发挥巨大最作用,DNA,知识图谱三维或者多维空间不行邻接矩阵实现图结构的矩阵化表示:造梦师局和操作实现层内消息传递:带线的连接机传递消息GCN通过邻域聚合实现特征提取SVM支持向量机编辑硬分类:无错误软分类:存在一定错误编辑线性不可分的:高纬度问题编辑通过core进行升维:进行分类编辑一个空间的混乱在另一个空间是秩序的

asp是什么ASP有两个含义:一是英文Application Service Provider的缩写,意思是网络应用服务供应商;另一个是英文Active Server Page的缩写,是微软推出的一种动态网页技术。Microsoft Active Server Pages 即我们所称的 ASP,其实是一套微软开发的服务器端脚本环境, ASP 内含于 IIS 3.0 和 4.0之中 , 通过 ASP