简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在“交互式建模(DSW)”中新建实例,阿里云自带的示例镜像是很少的,所以我们只需要筛选出适合你的项目的CUDA版本就好。DSW实例可以看作是一个Linux虚拟机,之后我们在实例中新建另一个Python环境使用即可。解压zip:unzip your_zip_file.zip -d output_directory。新建完实例后我们打开实例控制台,切换到Terminal终端板块,开始安装Python。

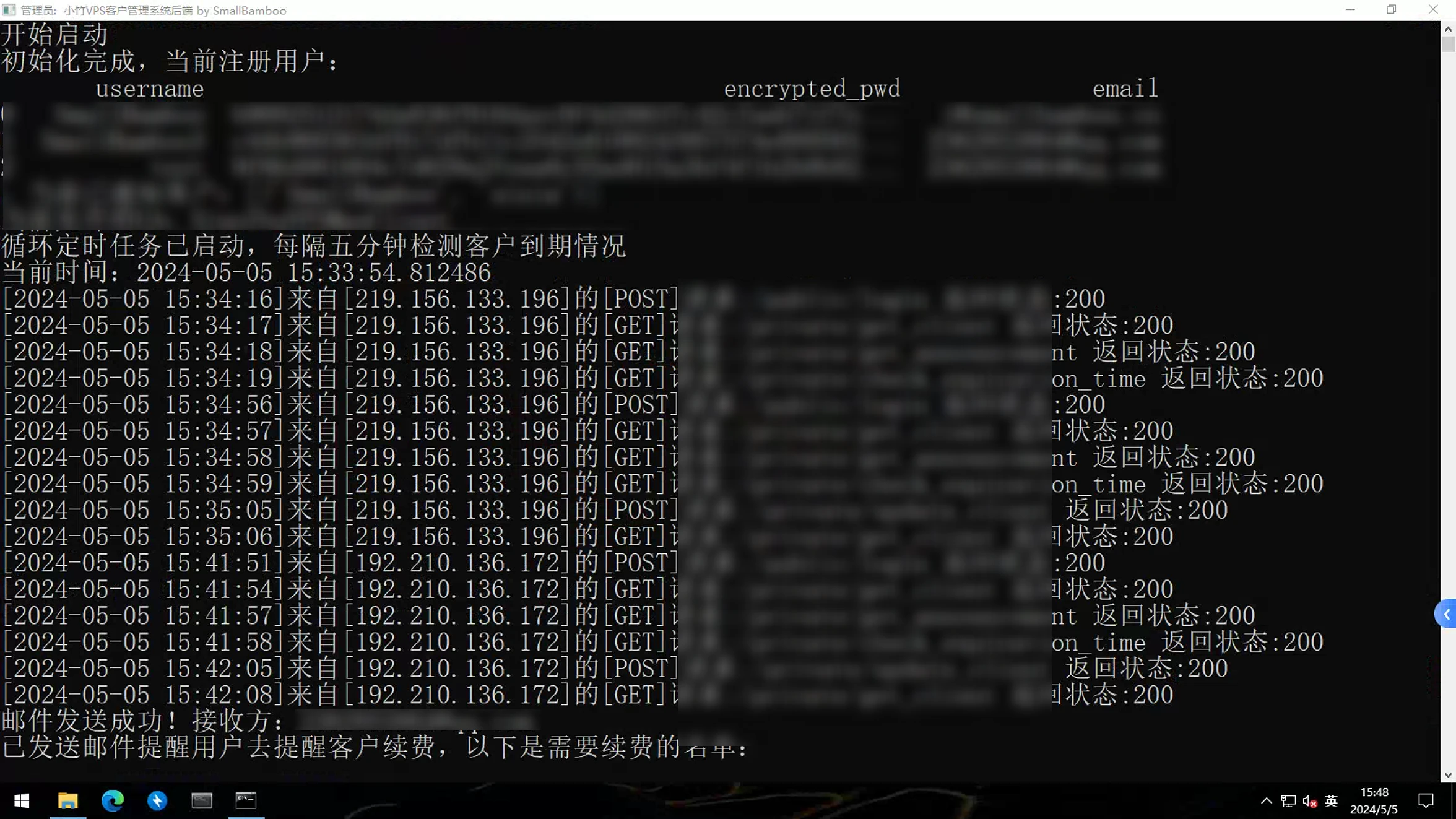

想要在Windows Server上部署flask应用,当然不能只下一个anaconda配完环境之后直接启动py文件,这样的话后台会有一段警告,意思就是直接使用app.run()开启的服务器只是一个开发服务器,官方提示不要把它放到生产环境,需要使用一个WSGI服务器。

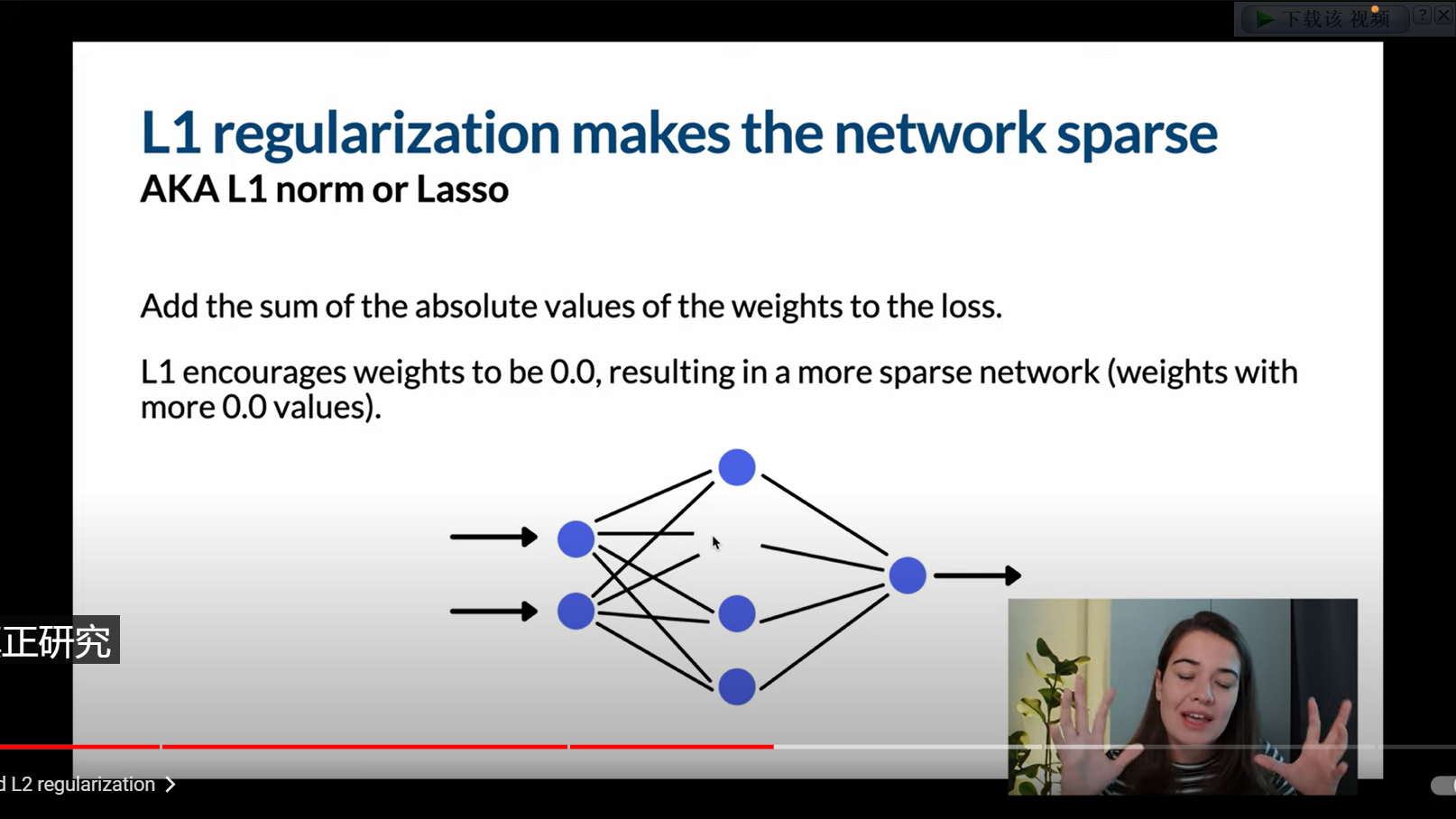

过拟合意味着模型具有很高的方差(高方差意味着模型对训练数据中的微小变化非常敏感),当你的模型中的参数越多,模型的灵活性就越大(拟合能力强),在模型中调整的东西越多,就越有可能有高方差。例如我们现在要把右图的灰色和绿色点区分开,需要使用神经网络进行拟合函数,若函数有n次项,那么预测函数就会有n个弯曲点,弯曲点越多在某种程度上表示拟合度更大,所以我们需要减少高次项或者其权重(高次项的系数)。正则化有两

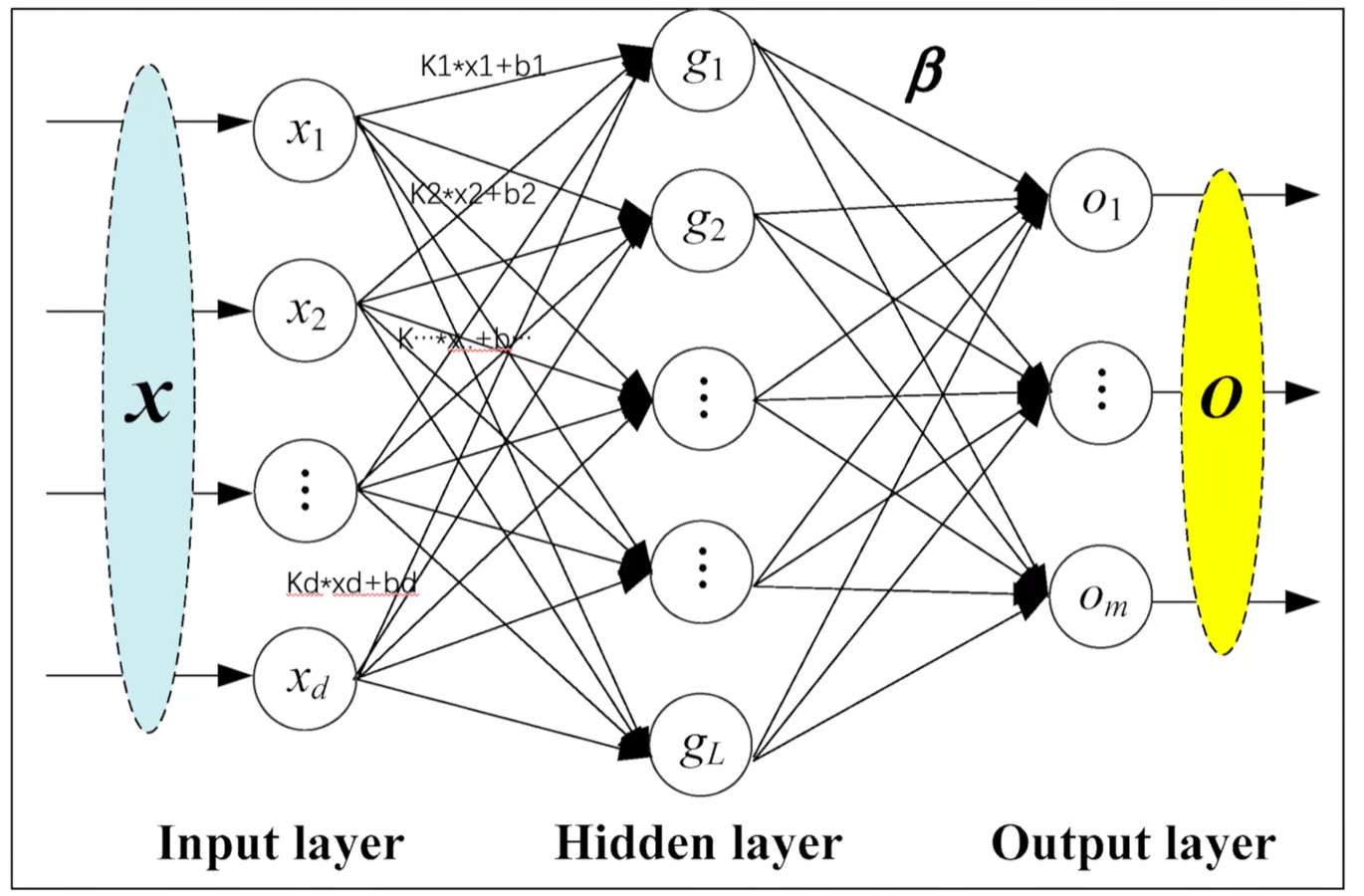

nn.Linear在PyTorch中是用于创建全连接层(全连接神经网络层)的类。全连接层也被称为密集连接层或者全连接神经网络层,是深度学习中常用的一种网络层类型。全连接层的作用是将上一层的所有节点都连接到当前层的每个节点,这样每个节点都与上一层的所有节点相连,形成了完全连接的网络结构。这种结构可以学习到输入数据之间的复杂非线性关系,从而提高模型的表达能力。在PyTorch中,使用nn.Linear

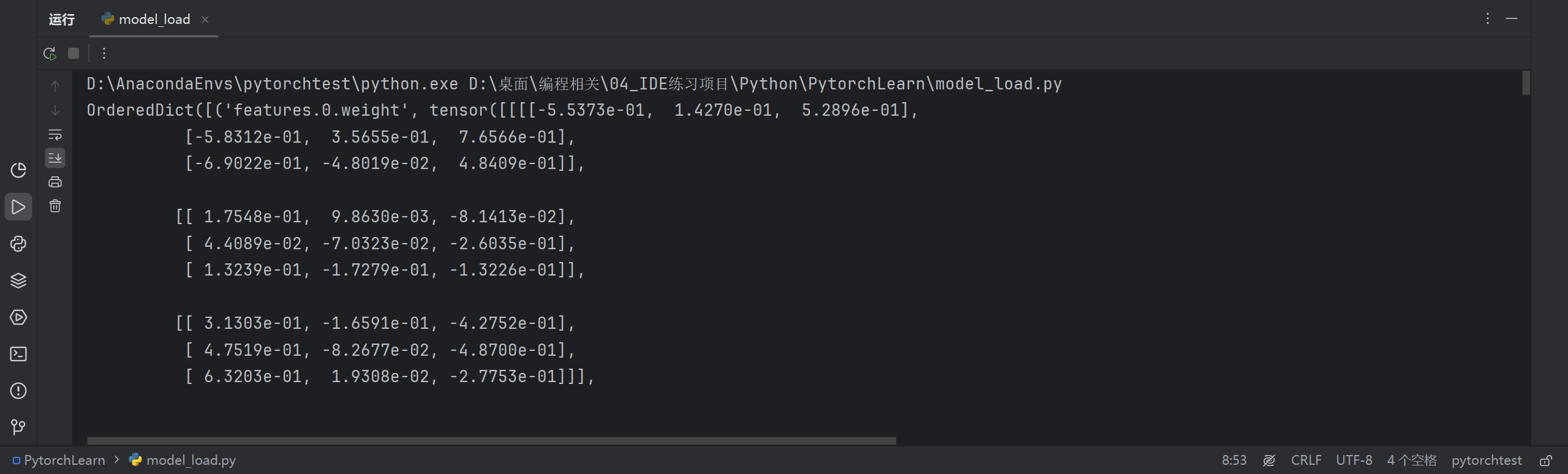

在训练模型时,训练完成后我们需要保存模型,使用模型预测时我们需要读取模型。为什么要保存和读取模型?

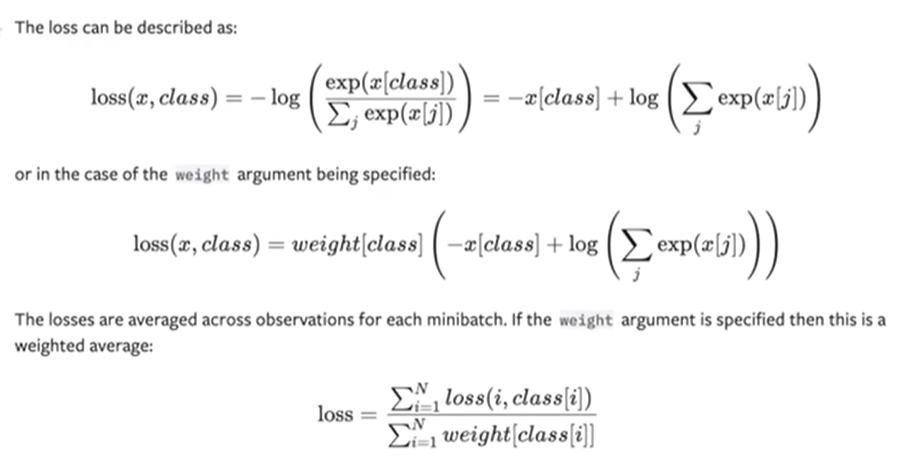

损失函数:在深度学习模型中,损失函数(Loss Function)是一种衡量模型预测与真实值之间差距的函数。换句话说,它是模型的性能指标。在训练过程中,我们的目标就是找到一组参数,它们可以最小化损失函数。常见的损失函数有均方误差(MSE, Mean Squared Error),交叉熵(Cross Entropy)等。我之前学的人工智能原理中的方差代价函数也属于这里的损失函数。

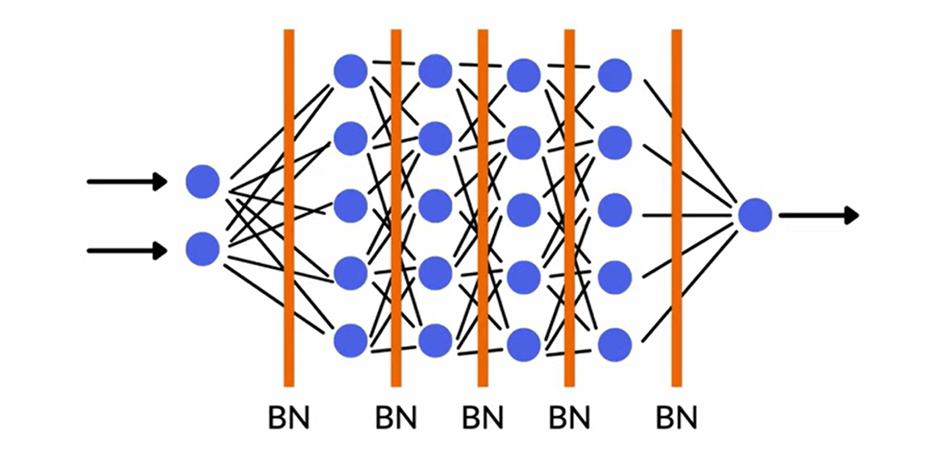

归一化指的是将数据缩放到一个固定范围内,通常是 [0, 1],而标准化是使得数据符合标准正态分布。归一化的作用是使不同特征具有相同的尺度,从而使模型训练更加稳定和快速,尤其是对于使用梯度下降法的算法。而标准化的作用加快模型收敛速度,提高模型的性能。批量归一化用于加速神经网络的训练并提高模型的稳定性。它在每个批次的数据上进行标准化,通过对每层的输入进行归一化处理,使得网络中间层的激活值保持在一个较小

在 PyTorch 中,nn.Module 是一个用于构建神经网络模型的基类。方法用于初始化模型,但这个方法目前为空,因为在这个简单的例子中,我们并没有添加具体的层或参数。在这个方法中,我们对输入进行加一操作,并将结果作为输出返回。,这里的输出结果将是2.0,因为我们将输入1.0加一了,得到了2.0。类,这是PyTorch中定义神经网络模型的基类。接着,我们创建了一个值为1.0的PyTorch张量

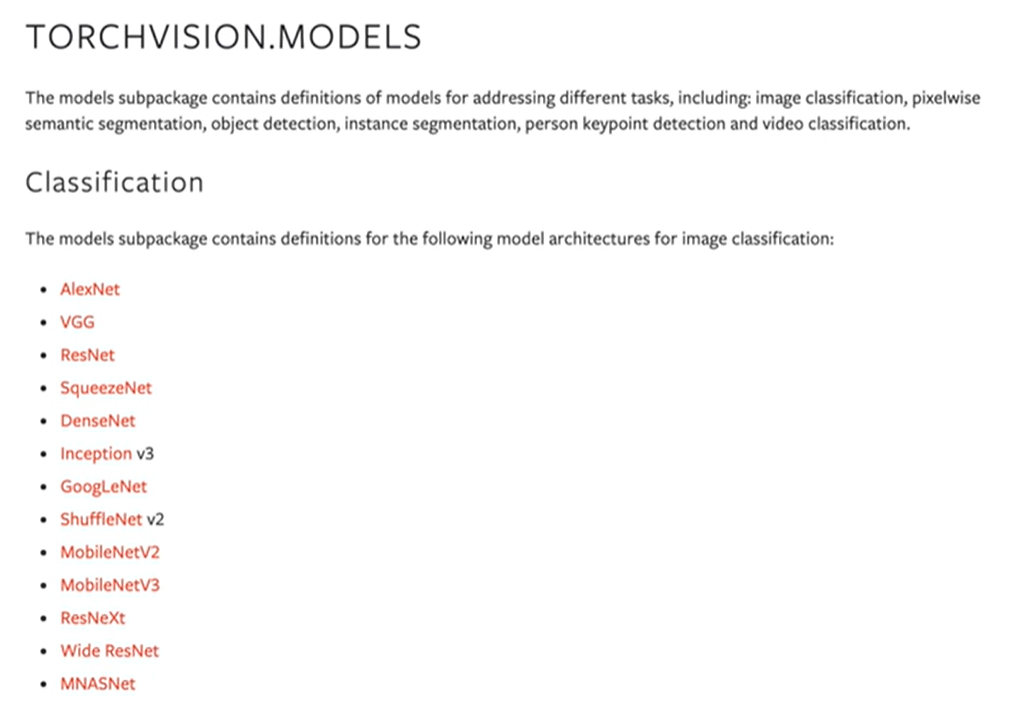

许多框架会把VGG16当作前置框架,使用VGG16提取特征,在VGG16后面加一些网络结构实现功能。

在“交互式建模(DSW)”中新建实例,阿里云自带的示例镜像是很少的,所以我们只需要筛选出适合你的项目的CUDA版本就好。DSW实例可以看作是一个Linux虚拟机,之后我们在实例中新建另一个Python环境使用即可。解压zip:unzip your_zip_file.zip -d output_directory。新建完实例后我们打开实例控制台,切换到Terminal终端板块,开始安装Python。