简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

文章介绍了基于大语言模型的QuantAgent自改进框架,用于量化交易信号挖掘。该框架采用双层循环架构:内循环通过Writer和Judge组件迭代优化交易信号,外循环将信号提交回测系统评估并更新知识库。技术特点包括角色分离、知识增强和程序化验证,实现了从因子挖掘到模型训练的全流程自动化。文中还提供了基于AgentScope框架的复现方案和多个高性能量化策略,年化收益可达398%-560%。

本文中,我们对从输入文本中创建知识图谱(KGC)的自动化方法感兴趣。大型语言模型(LLMs)的进展促使了一系列最近的研究将它们应用于KGC,例如,通过零/少次提示。尽管在小领域特定数据集上取得成功,但这些模型在扩展到许多现实世界应用中常见的文本上面临困难。一个主要问题是,在先前的方法中,KG模式必须包含在LLM提示中以生成有效的三元组;更大更复杂的模式很容易超过LLMs的上下文窗口长度。

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

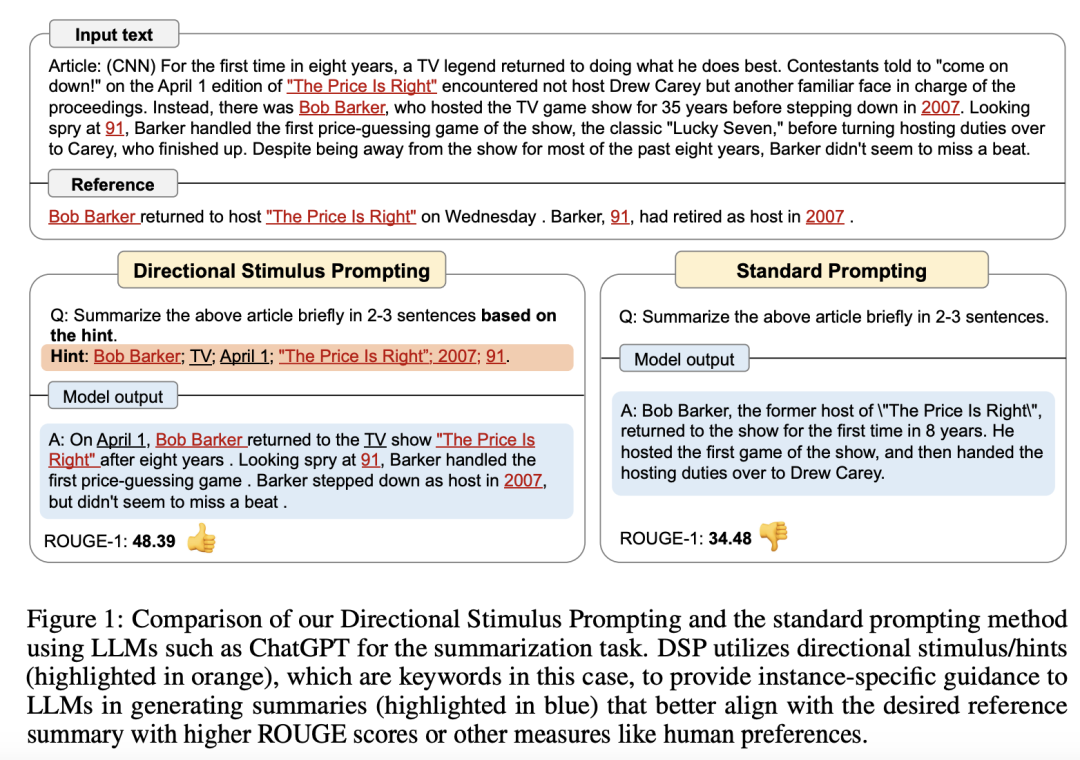

通过小型可调策略模型为输入实例生成辅助方向刺激提示,以引导黑盒大语言模型生成符合期望输出的新框架。下图中可以看出,对于同一篇新闻文章,除了原始输入外,还会提供诸如 “Bob Barker;TV;April 1;2007;91.” 这样的提示信息。

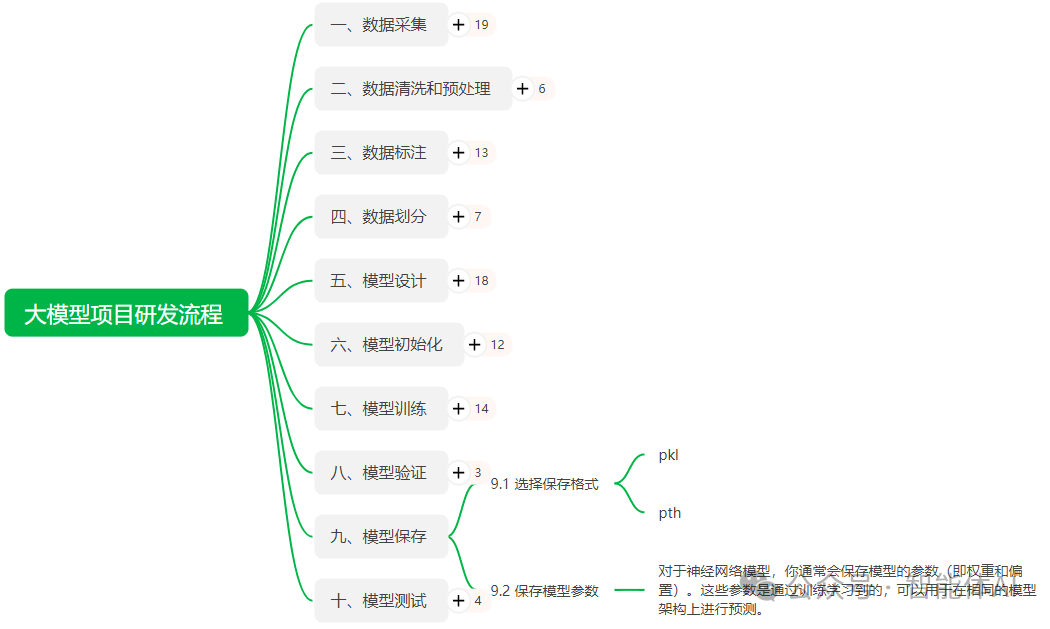

在神经网络中,模型参数通常指的是权重(weights)和偏置(biases)。权重决定了输入数据如何影响输出结果,而偏置则是为了进一步调整输出,确保模型的灵活性。这些参数通过训练数据反复优化和调整,最终得到了最佳的模型表现。

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

文章解析2025年大语言模型技术,对比主流模型特点与应用场景,探讨大模型在编程开发、科研辅助等领域的价值与挑战,展望技术趋势,为开发者提供全面参考。

Youtu-GraphRAG是腾讯优图实验室开源的全新图检索增强生成(Graph Retrieval-Augmented Generation)框架。该框架将大语言模型与图结构知识表示精巧集成,通过构建结构化知识图谱来增强大模型的检索与推理能力,显著提升了复杂问答任务的准确性与可解释性。Youtu-GraphRAG完美解决需要多步推理的复杂问题,如深度关联分析、因果推理等场景。例如在金融领域,可以

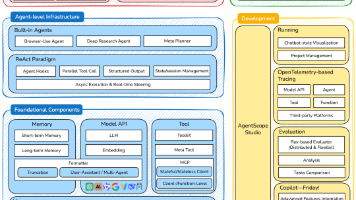

AgentScope 1.0是阿里巴巴开源的智能体应用构建框架,通过模块化设计与ReAct范式,解决了LLM智能体开发的四大痛点:API调用复杂、任务执行难以中断、多智能体协作混乱、行为难以调试。其四大基础模块(消息、模型、记忆、工具)高度解耦,内置多种智能体,并提供完整工具链,覆盖开发、调试、部署全流程,让开发者能像搭积木一样快速构建灵活、高效、可控的智能体应用。