简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

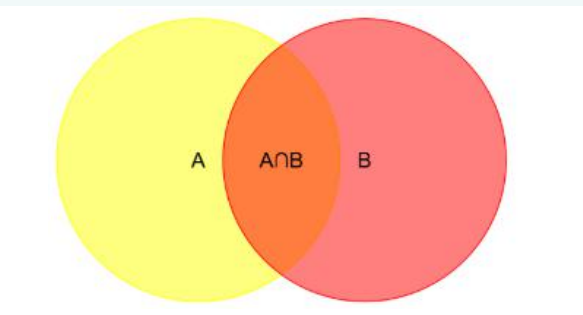

本次实验围绕使用贝叶斯公式进行垃圾邮件分类展开,贝叶斯公式的核心是“执果寻因”,是一种典型的后验概率,它基于原有的收集结果对先验概率进行修正并对待求解的事件进行估计。学习贝叶斯公式的同时也对先验概率、后验概率、条件概率和全概率公式进行了简单的回顾,条件概率和全概率公式是推导贝叶斯公式的基础所在。此外,在求解某个词在出某个类中出现的概率时需进行“拉普拉斯”修正,同时也需注意结果的下溢出(过多很小的数

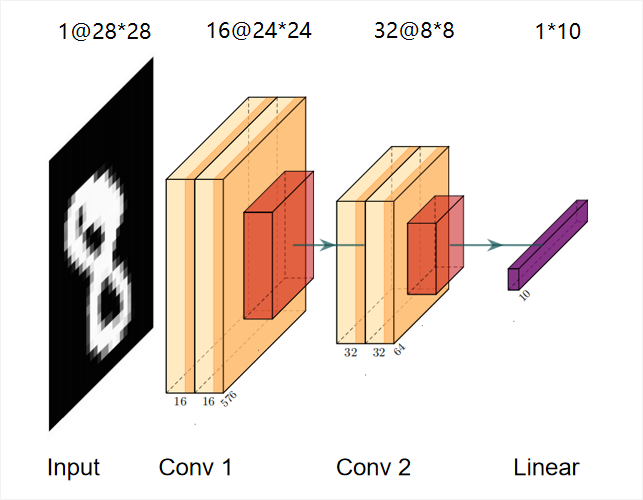

竞赛使用的是 MNIST (Modified National Institute of Standards and Technology, 美国国家标准与技术研究院修改版) 手写图像数据集,其中训练集42000条,测试集28000条,每条数据有784 个像素点,即原始图像的像素为 28 * 28。训练集中的Label列表示手写数字的类别(共10个类别,0-10)。

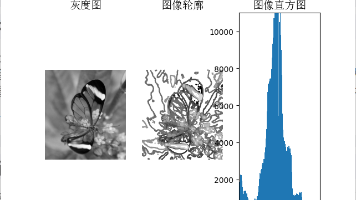

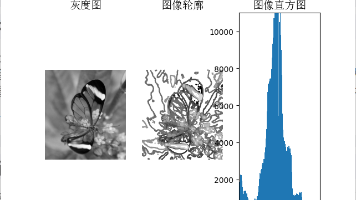

本文介绍了OpenCV的安装方法及常见问题处理,包括使用pip安装OpenCV、Pycharm中模块路径配置错误的解决方案。详细讲解了图像直方图原理及实现代码,展示了对灰度图和彩色图进行高斯滤波的效果对比,并探讨了不同标准差参数对滤波结果的影响。最后介绍了直方图均衡化的原理及Python代码实现,通过实际案例展示了均衡化前后图像及直方图的变化效果。文章包含完整代码示例和运行结果图示,适合图像处理初

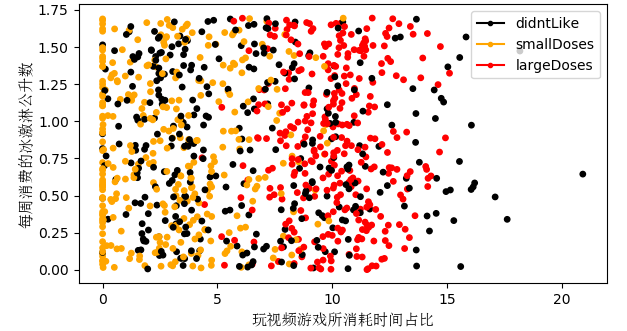

从以上实例中可以发现KNN算法的基本思路是将测试样本通过算法在训练样本中预测其类别,其预测精度受多方面因素的影响,例如训练数据的正确性和规模、算法的实现过程、参数值k的选取等等。KNN算法的识别过程相当于蛮力识别,因为每个测试向量都要对训练集里的每一个数据进行距离运算,实际运用时可以发现其执行效率并不高。但是KNN算法的实现思路较为清晰、易于理解,对刚接触图像识别的新手提供了一个清晰直观的思路,同

竞赛的数据集中,训练集有7613个样本,测试集有3263个样本。训练集中的`target`用于标识推文是否属于灾难推文(1表示灾难推文,0表示非灾难推文),最终任务是判断测试集中的推文样本是否为灾难推文,评估指标是F1值。竞赛使用的模型是DistilBert,DIstilBERT是 transformers 库中的模型。提交代码后最终评分(F1值)为0.82071。

本文介绍了OpenCV的安装方法及常见问题处理,包括使用pip安装OpenCV、Pycharm中模块路径配置错误的解决方案。详细讲解了图像直方图原理及实现代码,展示了对灰度图和彩色图进行高斯滤波的效果对比,并探讨了不同标准差参数对滤波结果的影响。最后介绍了直方图均衡化的原理及Python代码实现,通过实际案例展示了均衡化前后图像及直方图的变化效果。文章包含完整代码示例和运行结果图示,适合图像处理初

竞赛的任务是基于以往的时序数据来预测未来15天销售额,需要从给定的数据集中分析并提取有价值的特征。可视化分析发现每日油价与每日平均销售额的相关系数为 **-0.6269**,呈**负相关**,因此可将每日油价数据合并到训练集中。通过趋势分析发现平均销售额整体呈线性上升趋势,根据趋势特征选择**线性回归**模型来拟合趋势。节假日分析表明节假日和非节假日的销售额之间分层明显,**节假日的销售额整体大于

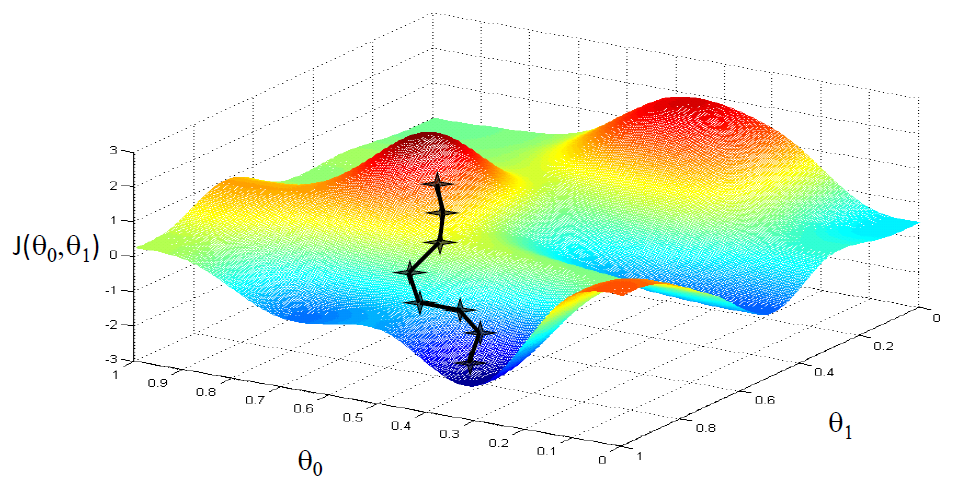

例如两个变量之间成正比(例如:x1 为房子的面积,单位是平方英尺;x2为房子的面积,单位是平方米;不可逆的情况很少发生,如果有这种情况,其解决问题的方法之一便是使用正则化以及岭回归等来求最小二乘法。的适用范围更广,可以用于描述非线性或者有两个及两个以上自变量的相关关系,它可以用来评价模型的效果。常用相关系数来衡量两个变量间的相关性,相关系数越大,相关性越高,使用直线拟合样本点时效果就越好。下图的样

竞赛的数据集中,训练集有7613个样本,测试集有3263个样本。训练集中的`target`用于标识推文是否属于灾难推文(1表示灾难推文,0表示非灾难推文),最终任务是判断测试集中的推文样本是否为灾难推文,评估指标是F1值。竞赛使用的模型是DistilBert,DIstilBERT是 transformers 库中的模型。提交代码后最终评分(F1值)为0.82071。

本次竞赛的数据集包含训练集和测试集,数据集的研究区域包含位于科罗拉多州北部罗斯福国家森林的四个荒野区域,这些区域受人为干扰影响最小,每个观测样本的区域大小为 30m x 30m。其中,训练集大小有15120个样本,测试集有565892个样本。共56个特征,7种类别(用数字1-7表示),第一列为样本`Id`列,最后一列`Cover_Type`为标签列。最终评分为0.78729。