简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

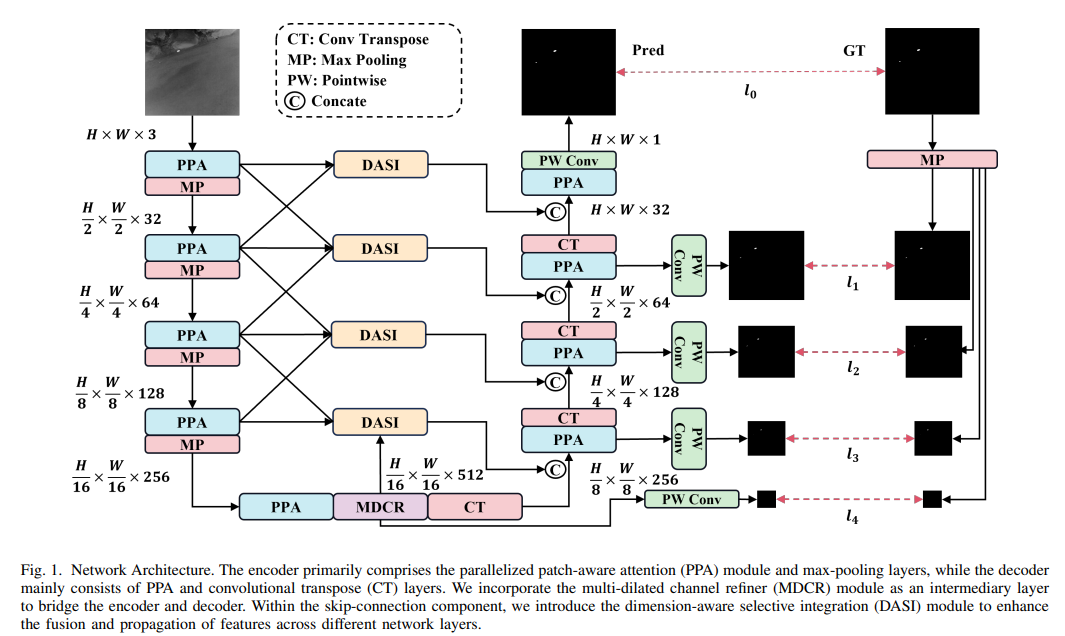

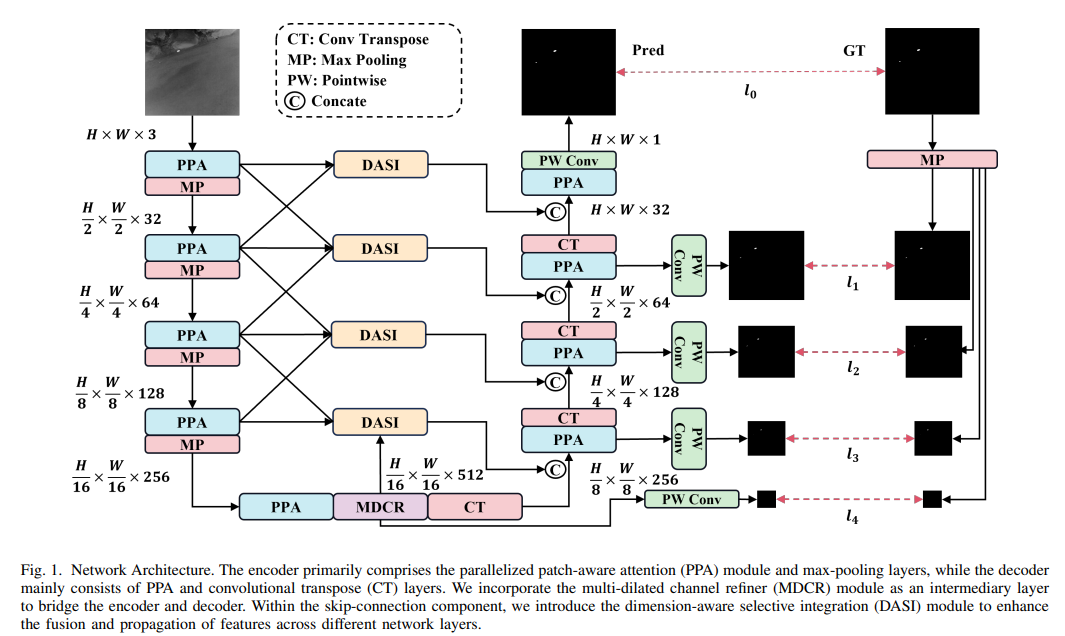

红外小目标检测是一项重要的计算机视觉任务,涉及在红外图像中识别和定位微小物体,这些物体通常仅包含几个像素。然而,由于物体尺寸极小以及红外图像中通常复杂的背景,这项任务面临困难。在本文中,我们提出了一种深度学习方法 HCF-Net,通过多个实用模块显著提高了红外小目标检测的性能。具体来说,它包括并行补丁感知注意力(PPA)模块、维度感知选择性集成(DASI)模块和多空洞通道细化器(MDCR)模块。P

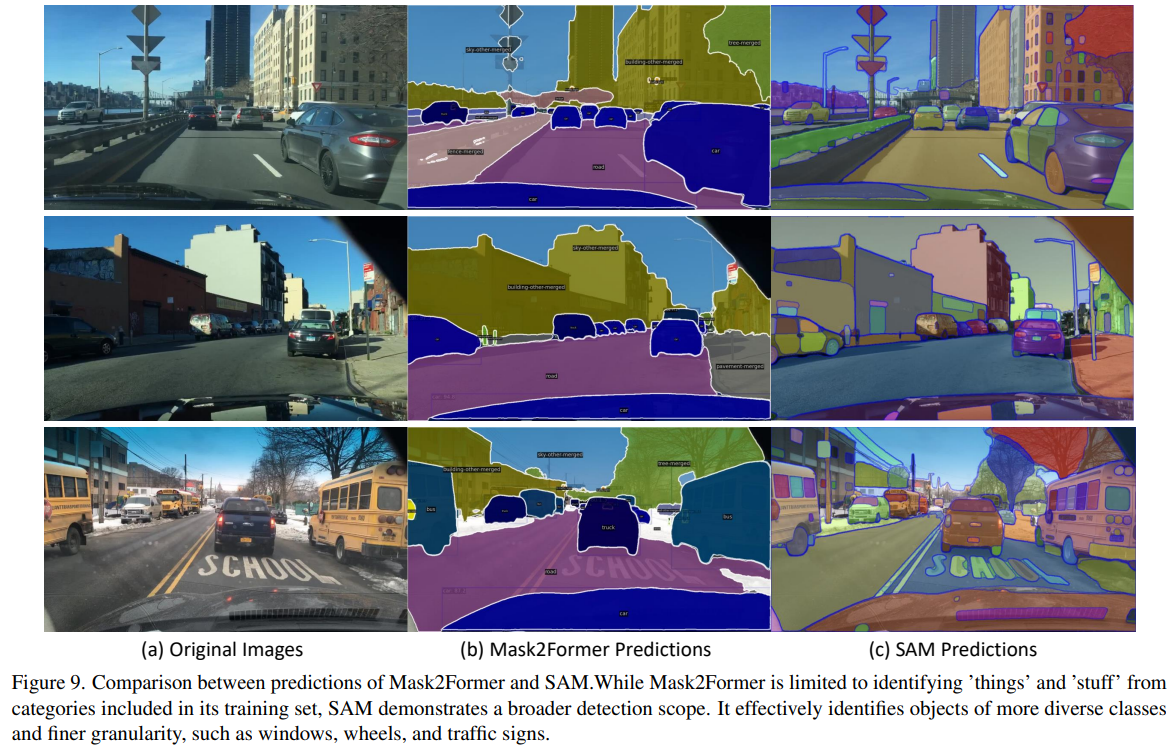

在复杂场景中跨视频帧稳健地关联相同对象是许多应用的关键,特别是多目标跟踪(MOT)。当前方法主要依赖于标注的特定领域视频数据集,这限制了学习到的相似度嵌入的跨域泛化能力。我们提出了MASA,一种新颖的方法用于稳健的实例关联学习,该方法能够在不同领域内的视频中匹配任何对象,而无需跟踪标签。MASA利用Segment Anything Model(SAM)丰富的对象分割结果,通过详尽的数据变换来学习实

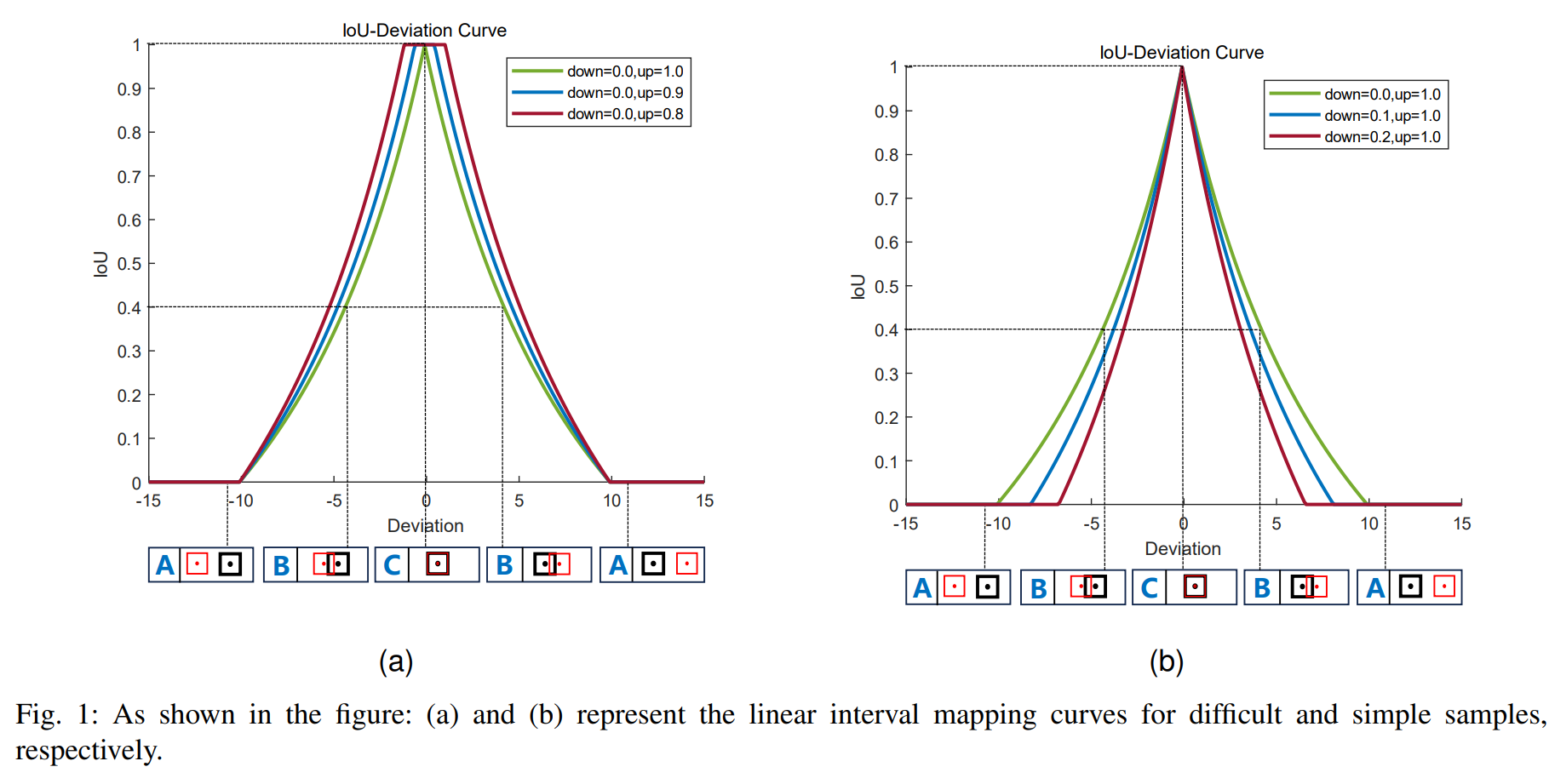

目标检测是计算机视觉的基本任务之一,其目的是在图像中定位和识别目标。根据是否生成锚点,可以将它们分为基于锚点和无锚点的方法。基于锚点的算法包括Faster R-CNN [1]、YOLO(You Only Look Once)系列 [2]、SSD(Single Shot MultiBox Detector) [3]和RetinaNet [4]。

红外小目标检测是一项重要的计算机视觉任务,涉及在红外图像中识别和定位微小物体,这些物体通常仅包含几个像素。然而,由于物体尺寸极小以及红外图像中通常复杂的背景,这项任务面临困难。在本文中,我们提出了一种深度学习方法 HCF-Net,通过多个实用模块显著提高了红外小目标检测的性能。具体来说,它包括并行补丁感知注意力(PPA)模块、维度感知选择性集成(DASI)模块和多空洞通道细化器(MDCR)模块。P

将文件从一台服务器上传到另一台服务器上用到了scp命令。scp(Secure Copy Protocol)命令用于在本地和远程主机之间或两个远程主机之间安全地复制文件或目录。它基于SSH协议,因此文件传输过程中会进行加密。以下是scp。

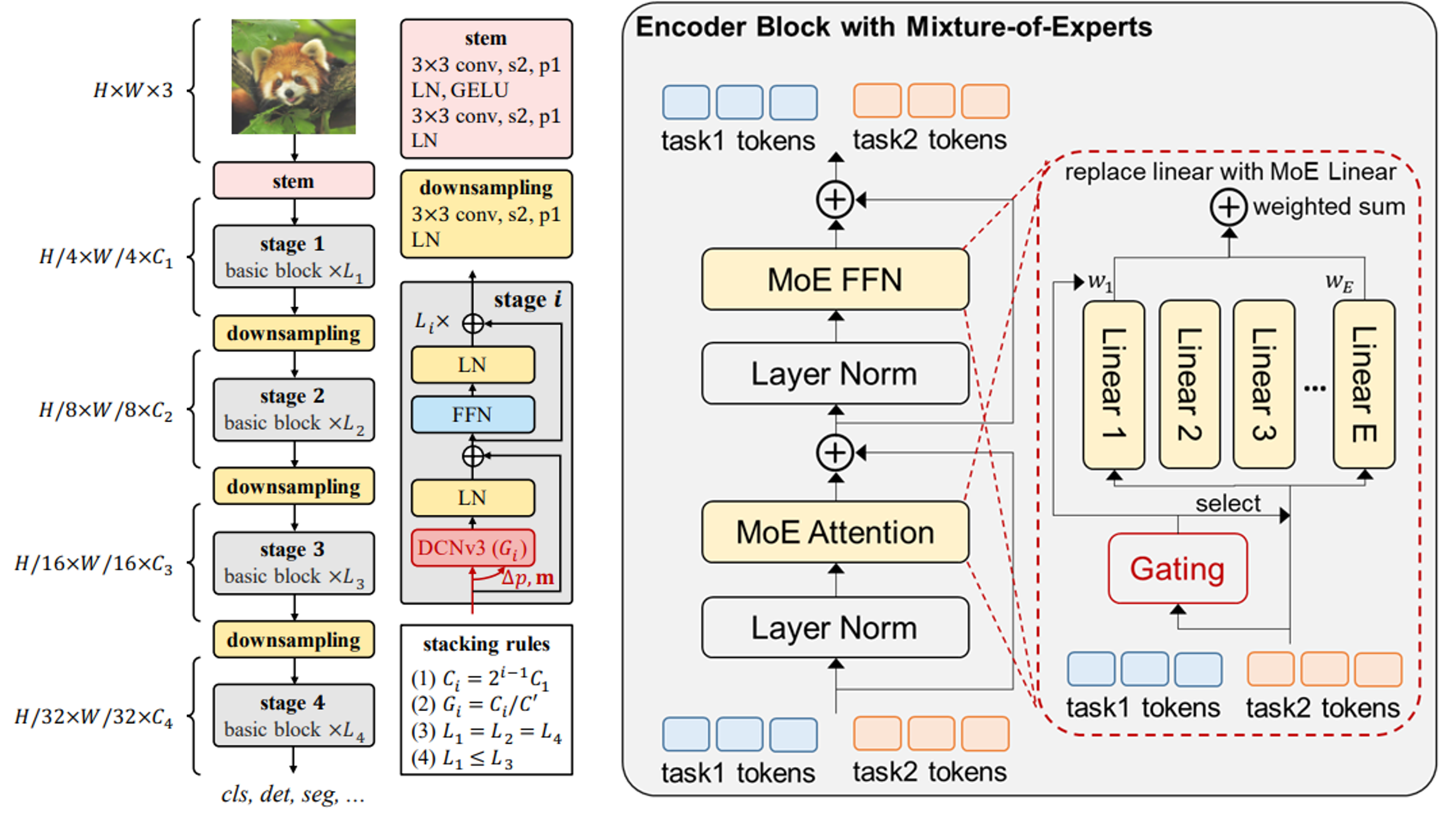

论文翻译:https://wanghao.blog.csdn.net/article/details/129379410官方源码: https://github.com/OpenGVLab/InternImage他来了!他来了!他带着氩弧焊的光芒过来了!作为CV的大模型,InternImage的光芒太强了。2023年3月14日: 🚀 “书生2.5”发布!2023年2月28日: 🚀 Intern

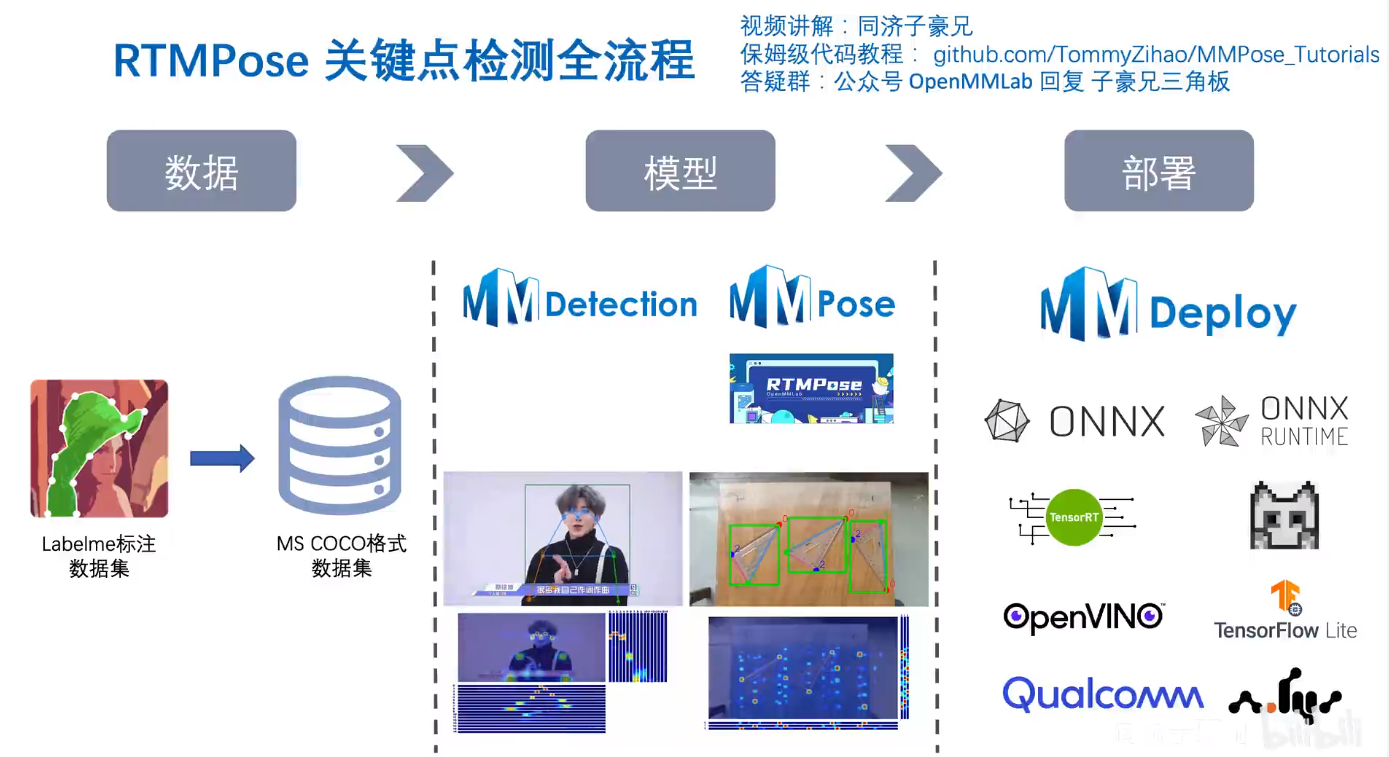

今天,学习RTMPose关键点检测实战。教大家如何安装安装MMDetection和MMPose。实战项目以三角板关键点检测场景为例,结合OpenMMLab开源目标检测算法库MMDetection、开源关键点检测算法库MMPose、开源模型部署算法库MMDeploy,全面讲解项目全流程:数据集:Labelme标注数据集、整理标注格式至MS COCO目标检测:分别训练Faster R CNN和RTMD

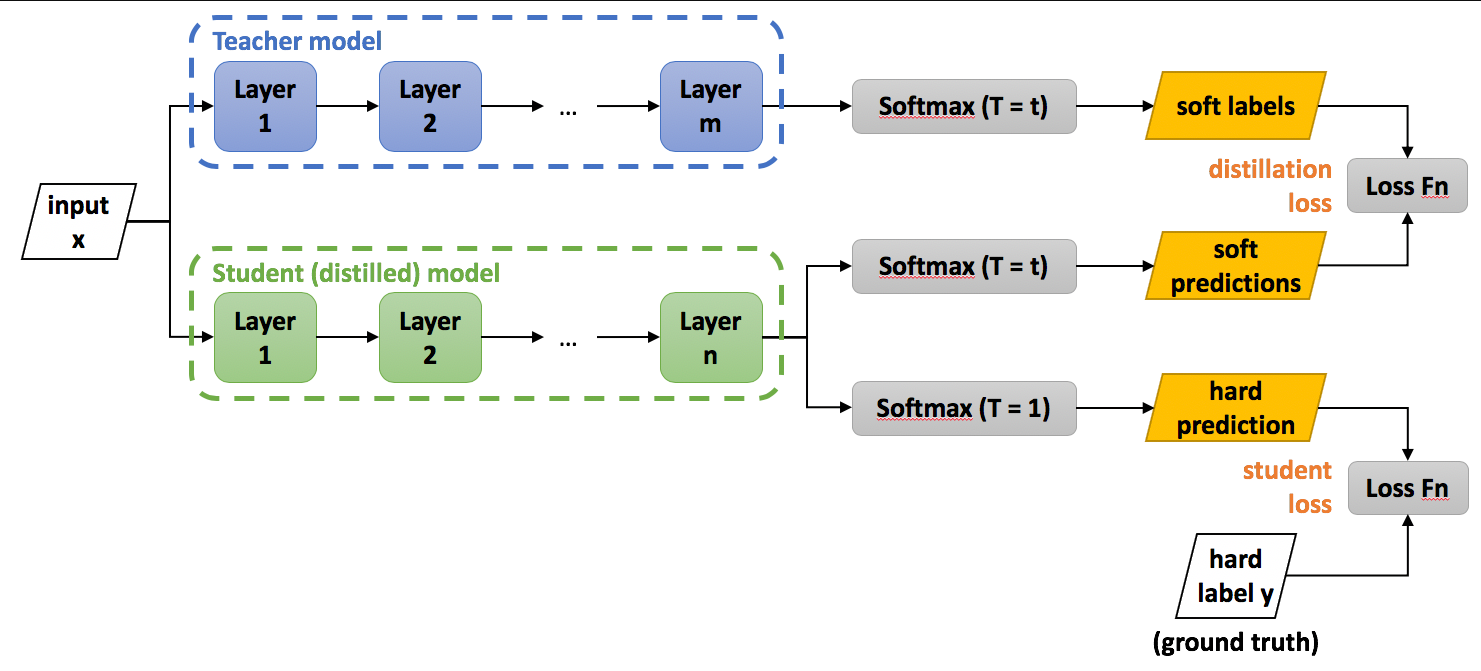

知识蒸馏(Knowledge Distillation),简称KD,将已经训练好的模型包含的知识(”Knowledge”),蒸馏(“Distill”)提取到另一个模型里面去。

DeepSeek-V3实现多token预测的方式主要通过引入**多token预测(Multi-Token Prediction, MTP)**目标来增强模型的性能。

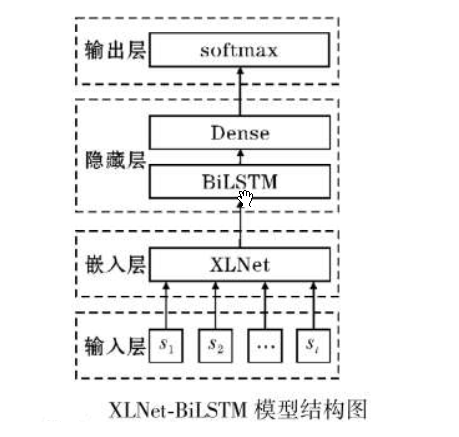

CMU和google brain联手推出了bert的改进版xlnet。在这之前也有很多公司对bert进行了优化,包括百度、清华的知识图谱融合,微软在预训练阶段的多任务学习等等,但是这些优化并没有把bert致命缺点进行改进。xlnet作为bert的升级模型,主要在以下三个方面进行了优化今天我们使用xlnet+BiLSTM实现一个二分类模型。