简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

NVIDIA近期发布的GR00T N1模型是其在具身智能领域的重要进展。该模型的核心目标是充分利用多种来源的数据,包括人类视频、仿真数据、不同构型机器人的真实操作数据以及通过视频生成技术获得的合成数据。通过这种方式,GR00T N1旨在解决具身智能所面临的数据稀缺和多样性不足的问题,从而提升机器人在复杂环境中的操作能力。图1:机器人基础模型训练的数据金字塔。GR00T N1的异构训练语料库可以表示

点击屏幕左下角的“启动台(Launchpad)”图标,查找框里输入“终端”找到并点击“终端”图标即可打开终端。下一期,我们将为您提供“0成本用DeepSeek(满血版)搭建AI编程助手”的上手教程,敬请期待!打开Cherry Studio ,点击左下角的齿轮配置图标,选择“模型服务”,点击“+添加”点选“默认模型” ,这里均选择刚才的 deepseek-ai/DeepSeek-R1 模型。添加模型

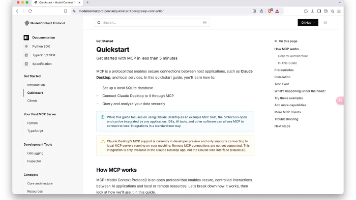

MCP(Model Context Protocol,模型上下文协议)是由Anthropic公司于2024年11月推出并开源的一种通信协议。它旨在建立大型语言模型(LLM)与外部数据源及工具之间的安全双向链接,让AI模型能够以标准化的方式与各种数据源和工具进行交互。MCP的核心理念是提供一种统一的集成方式,让AI模型能够安全、高效地访问和操作用户本地或远程的各种数据和服务,而无需将敏感数据上传至第

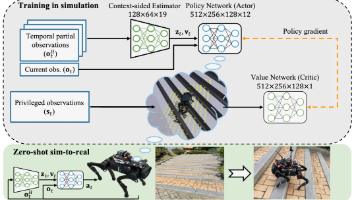

在复杂环境中进行导航和理解,并持续较长时间,是机器人面临的一项重大挑战。,这就要求机器人能够对其部署的长时间历史进行推理。为了解决这一问题,我们提出了一种用于具身机器人的检索增强记忆系统,称为ReMEmbR。》该系统旨在实现机器人导航的长时间视频问答。为了评估ReMEmbR,我们引入了。ReMEmbR采用了一种。我们的实验表明,ReMEmbR在性能上优于大型语言模型(LLM)和视觉语言模型(VLM

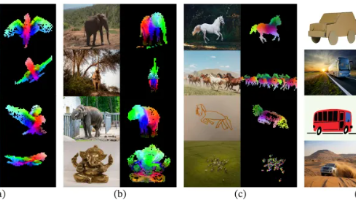

SAV (Segment Any Video) 是SAM (Segment Anything Model) 的视频扩展版本,它将SAM的强大分割能力从图像领域扩展到了视频领域。DINO-v2是Meta AI在2023年发布的DINO的升级版本,进一步提升了自监督视觉表示学习的性能,适用于更广泛的下游视觉任务。SAM是Meta AI发布的通用图像分割模型,能够实现零样本分割、交互式分割等功能,特别适

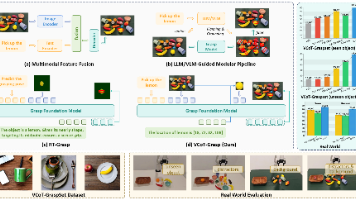

西安交通大学团队提出VCoT-Grasp模型,通过视觉思维链推理实现语言驱动的机器人抓取。该模型采用两阶段处理范式:首先识别目标物体并预测边界框,然后基于局部图像生成精确抓取姿态。相较于传统卷积网络和多模态融合方法,VCoT-Grasp能更精准理解自然语言指令,实现可解释推理。模型基于PaliGemma2-3B构建,包含图像编码器、视觉投影器、语言模型和动作头四部分,支持端到端训练。实验表明,该方

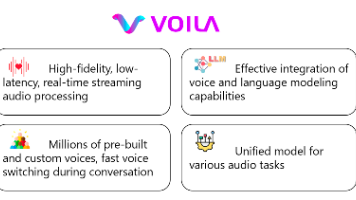

Voila是一个超越人类反应速度的开源语音大模型,专为实时情感对话而设计。作为由美国加州大学圣地亚哥分校、阿联酋穆罕默德·本·扎耶德人工智能大学以及Maitrix.org团队共同开发的革命性语音基础模型,Voila采用端到端架构,实现了195ms超快响应,支持百万音色和10秒声音克隆,是构建有温度AI语音交互系统的理想选择。Voila作为端到端语音处理系统,最大的创新在于直接实现音频到音频的处理,

本文是得克萨斯大学奥斯汀分校的凯尔·摩根斯坦(Kyle Morgenstein)为Humanoid团队主持的网络研讨会文字实录。我们将其发布在博客上,旨在传播知识,推动人形机器人行业发展。请注意,文中所表达的观点和信息均为凯尔个人观点。得克萨斯大学奥斯汀分校 凯尔·摩根斯坦(Kyle Morgenstein)

自动驾驶领域的传统方法多依赖于数据驱动模型,通过大量标注数据训练实现路径规划和控制。然而,现实世界中道路临时施工、突发障碍物等极端场景难以完全涵盖,导致系统在特殊情况下表现不佳。与此同时,大语言模型在自然语言处理领域展现出强大的理解和推理能力,能够处理复杂指令和丰富知识推理。将LLM引入自动驾驶,尤其是本地端部署,既能利用其认知智能,又能避免云端延迟、隐私和安全隐患。图1:所提出的增强型大型语言模

最近,Qwen发布了最新的32B推理模型QwQ-32B,其性能在许多基准测试中表现出色,甚至不逊色于671B参数的满血版DeepSeek R1。QwQ-32B基于Qwen2.5-32B,并通过强化学习(RL)进行进一步优化。