简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

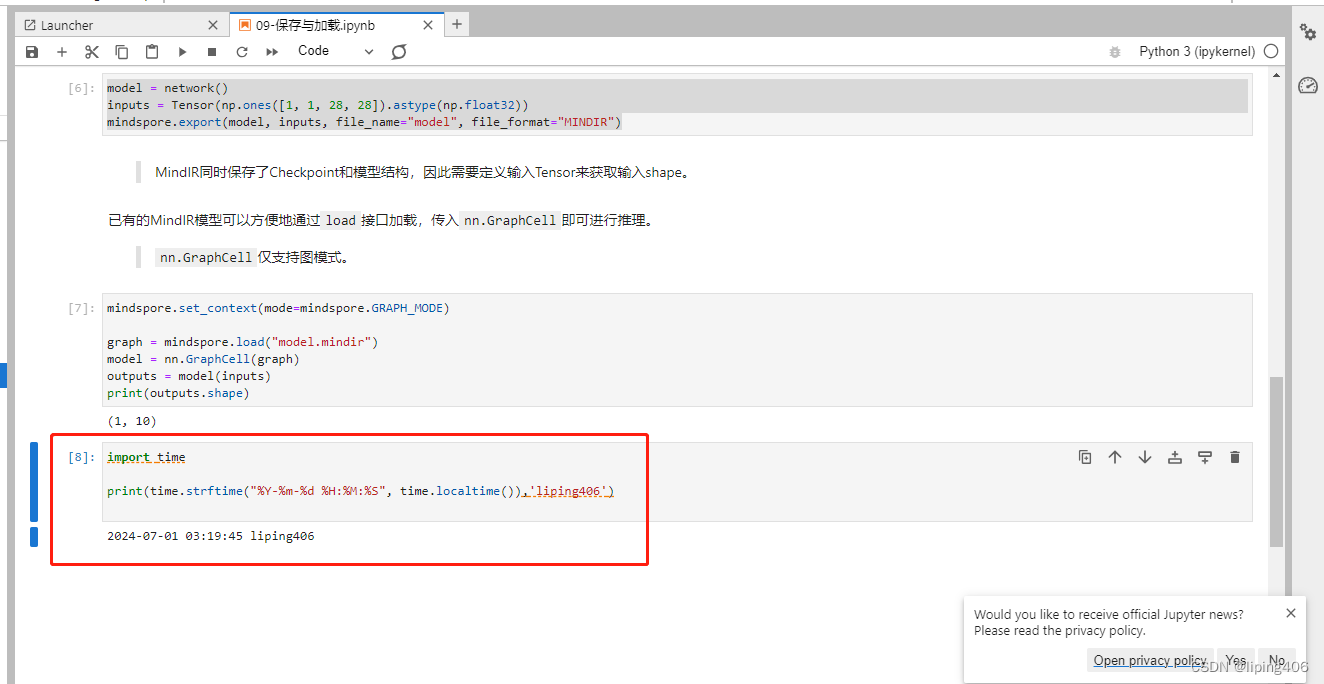

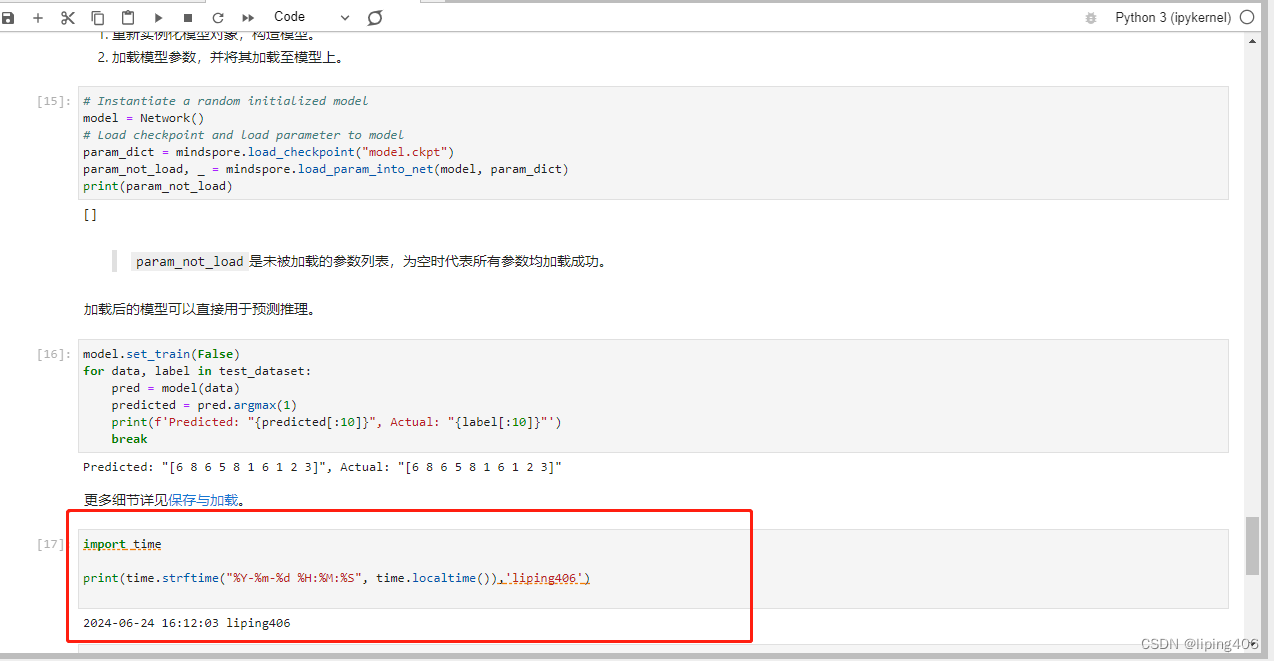

打卡营第八天,今天学习的内容是模型保存与加载。

报名参加了昇思25天学习营,记录一下第一天学习的内容。

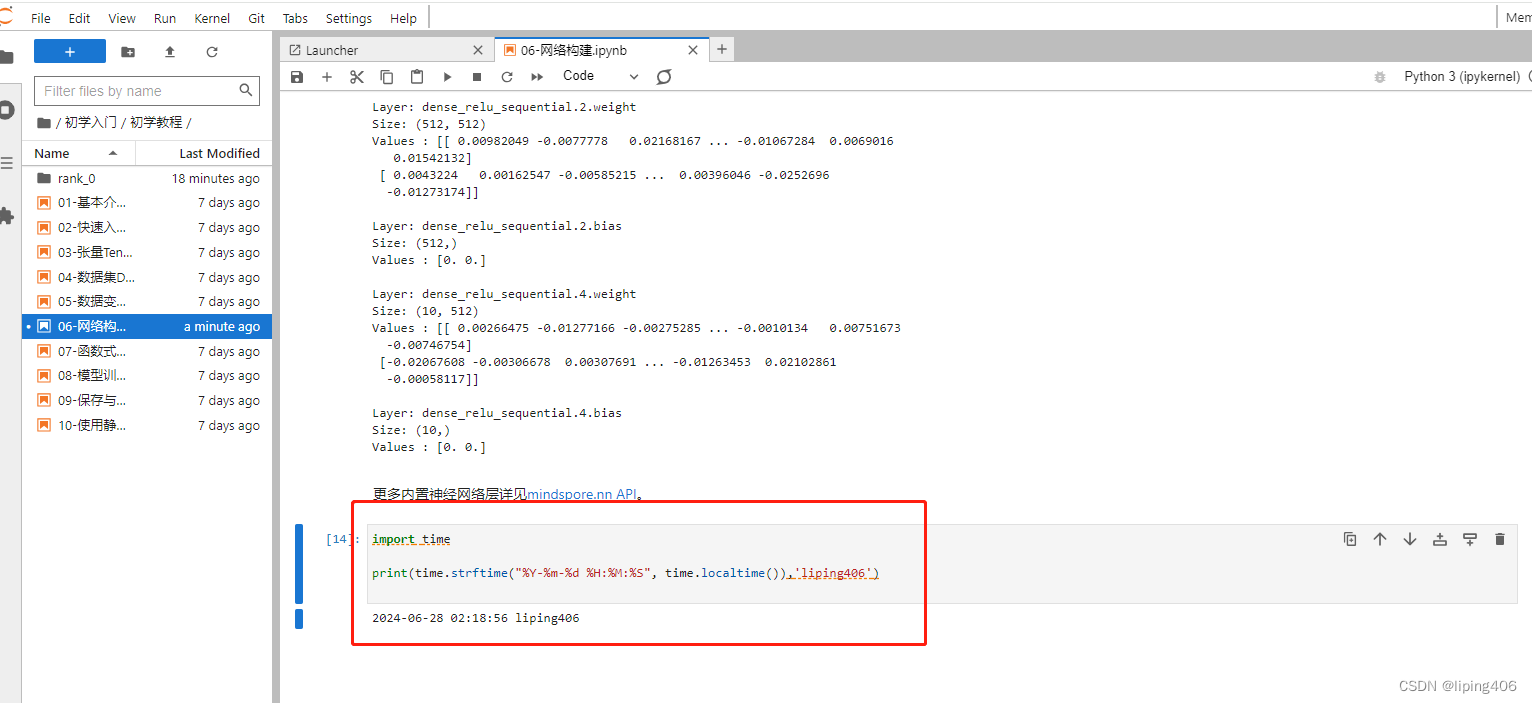

当我们定义神经网络时,可以继承nn.Cell类,在__init__方法中进行子Cell的实例化和状态管理,在construct方法中实现Tensor操作。construct意为神经网络(计算图)构建,相关内容详见使用静态图加速。网络构建概念比较多,学习比较难。做个记录,方便后免费复习。

普遍的做法是,在一个非常大的基础数据集上训练得到一个预训练模型,然后使用该模型来初始化网络的权重参数或作为固定特征提取器应用于特定的任务中。本章将使用迁移学习的方法对ImageNet数据集中的狼和狗图像进行分类。开始训练模型,与没有预训练模型相比,将节约一大半时间,因为此时可以不用计算部分梯度。,数据集中的图像来自于ImageNet,每个分类有大约120张训练图像与30张验证图像。对获取到的图像及

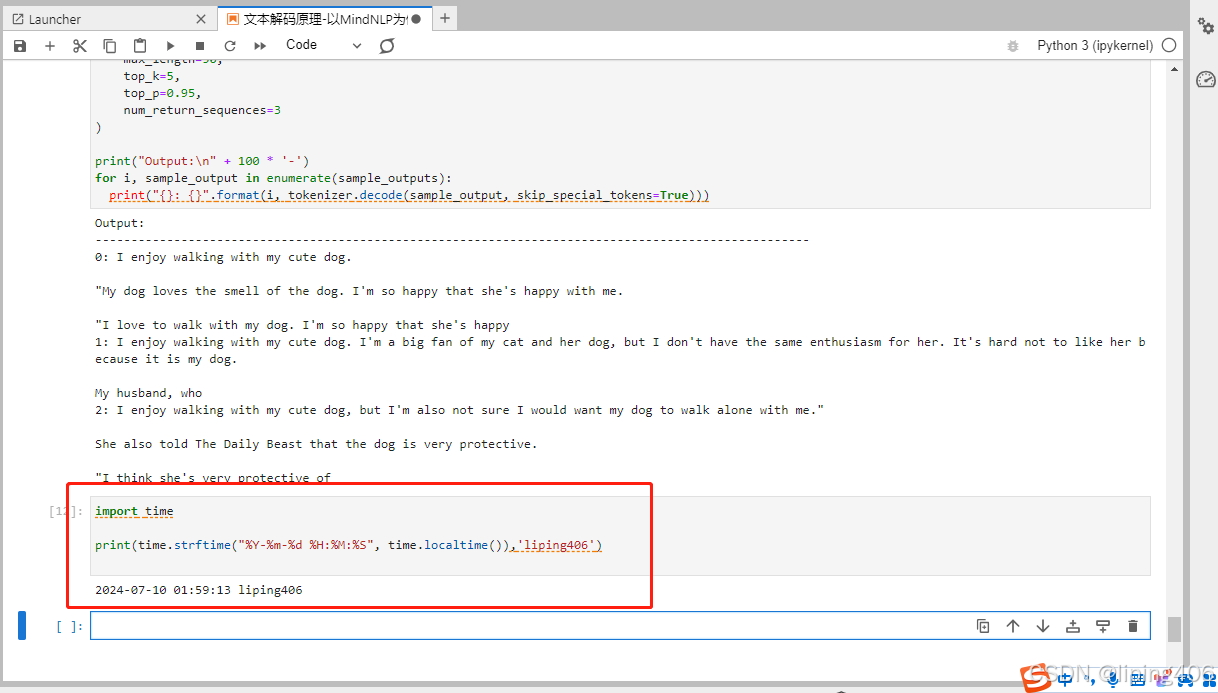

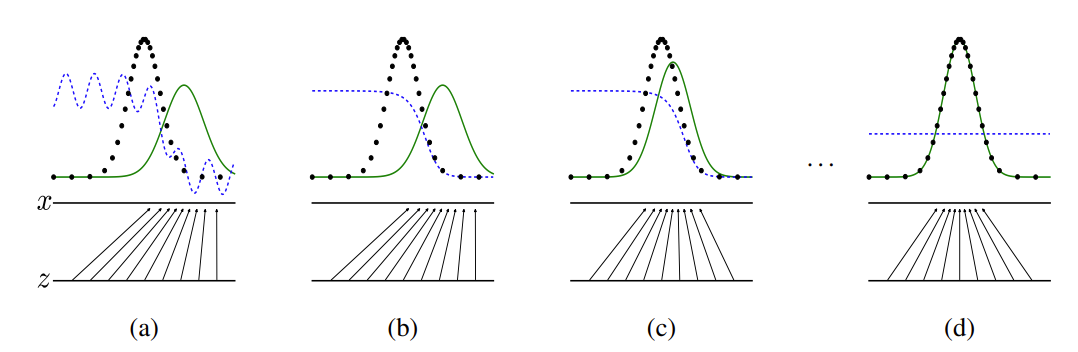

今天是第十七天,学习的内容是文本解码原理。记录一下学习内容。

生成式对抗网络(Generative Adversarial Networks,GAN)是一种生成式机器学习模型,是近年来复杂分布上无监督学习最具前景的方法之一。最初,GAN由Ian J. Goodfellow于2014年发明,并在论文生成器的任务是生成看起来像训练图像的“假”图像;判别器需要判断从生成器输出的图像是真实的训练图像还是虚假的图像。GAN通过设计生成模型和判别模型这两个模块,使其互相

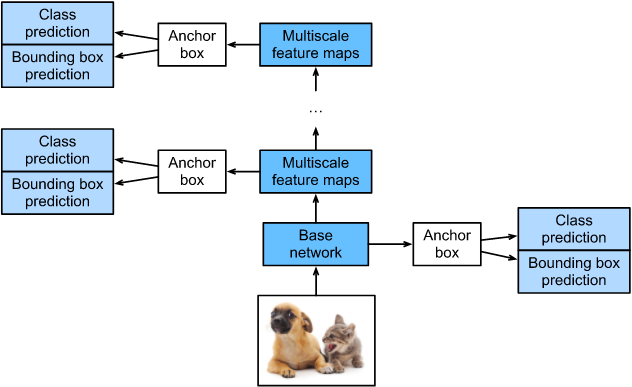

SSD,全称Single Shot MultiBox Detector,是Wei Liu在ECCV 2016上提出的一种目标检测算法。使用Nvidia Titan X在VOC 2007测试集上,SSD对于输入尺寸300x300的网络,达到74.3%mAP(mean Average Precision)以及59FPS;对于512x512的网络,达到了76.9%mAP ,超越当时最强的Faster R

ResNet50网络是2015年由微软实验室的何恺明提出,获得ILSVRC2015图像分类竞赛第一名。在ResNet网络提出之前,传统的卷积神经网络都是将一系列的卷积层和池化层堆叠得到的,但当网络堆叠到一定深度时,就会出现退化问题。下图是在CIFAR-10数据集上使用56层网络与20层网络训练误差和测试误差图,由图中数据可以看出,56层网络比20层网络训练误差和测试误差更大,随着网络的加深,其误差

很好的训练营,有算力配置,还有小伙伴同学互相激励,欢迎大家报名啊。

输入是3x64x64的图像,输出是该图像为真图像的概率。训练判别器的目的是最大程度地提高判别图像真伪的概率。按照Goodfellow的方法,是希望通过提高其随机梯度来更新判别器,所以我们要最大化。由于数据是图像,这一过程也会创建与真实图像大小相同的 RGB 图像。DCGAN论文提到,使用卷积而不是通过池化来进行下采样是一个好方法,因为它可以让网络学习自己的池化特征。在这两个部分中,分别获取训练过程