简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

明确抓住边缘部署+轻量化的时代转向,将“监控-诊断-微调-部署”做成闭环,框架完整且工程

此次GPT-4o的升级在多个层面实现了技术的突破与创新,特别是在架构统一、训练优化、性能提升、安全性增强以及用户体验的提升方面。这些变革性的改进将图像生成能力深度融入到GPT-4o的多模态框架中,使其不仅在文本生成方面保持强大的能力,同时在图像生成领域也表现出色。架构统一与多模态深度融合是此次升级的核心之一。通过将图像生成与文本理解和处理集成到同一个模型中,GPT-4o突破了传统模型将图像生成和语

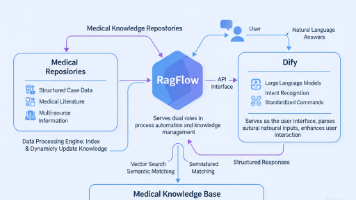

本文介绍了一套医疗知识智能服务系统的分层架构设计与环境部署方案。系统采用RagFlow作为知识管理中枢,Dify为交互入口,通过标准化API实现医疗知识库的自动化查询。架构包含环境支撑层、核心功能层与交互层,支持"输入-解析-查询-反馈"的闭环数据流转。环境部署部分详细说明了RagFlow的安装流程,包括Node.js版本管理、依赖安装、系统启动及Docker容器化方案,重点解

摘要 近五年(2020-2025)IPMC人工肌肉研究在工程化应用方面取得重要进展。针对致动端和传感端的性能缺陷,研究明确了量化指标:致动端聚焦输出力密度(阻塞力、自由位移)、动态一致性(增益/相位漂移)和循环寿命(≥10000次);传感端解决了高阻抗信号(输入阻抗≥10¹²Ω)、温湿度耦合干扰和致动/传感串扰问题。材料方面,液态金属复合电极(EGaIn)相比传统Pt电极提升驱动力41.2%,循环

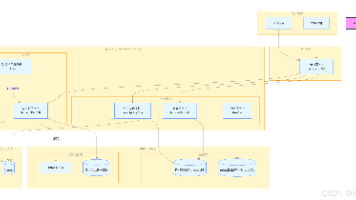

本文通过代码实现展示了AI与医疗微服务的融合方案。第一章构建了一个基于FastAPI的患者注册微服务,包含FHIR标准数据模型、API端点和Docker容器化配置;第二章介绍了服务治理方案,包括使用Consul实现服务发现、通过Kong网关配置路由和JWT认证。全文采用"代码即文档"的方式,提供了一个可落地的智慧医疗平台微服务架构参考实现,覆盖从基础服务开发到安全部署的关键环节

Python生态的蓬勃发展和技术的持续创新(如无GIL Python、Mojo、更高效的流处理引擎、小型化本地LLM)正在不断突破瓶颈。未来的Python ETL框架将更加AI原生、性能卓越、开发友好、云原生就绪,成为企业构建实时智能应用、驱动数据驱动决策的基石。

本文分享了在GitCode平台上使用昇腾NPU部署llava-1.5-7b-hf模型的全流程实践。作者基于前期CodeLlama-7B模型部署经验,详细介绍了环境搭建、模型适配和性能优化过程。文章重点展示了GitCode Notebook的NPU配置选择(昇腾910B)、模型下载、环境安装(使用阿里云镜像加速)以及测试代码实现。通过图文并茂的方式,为开发者提供了在国产算力平台上运行多模态大模型的实

本文分享了在GitCode平台上使用昇腾NPU部署llava-1.5-7b-hf模型的全流程实践。作者基于前期CodeLlama-7B模型部署经验,详细介绍了环境搭建、模型适配和性能优化过程。文章重点展示了GitCode Notebook的NPU配置选择(昇腾910B)、模型下载、环境安装(使用阿里云镜像加速)以及测试代码实现。通过图文并茂的方式,为开发者提供了在国产算力平台上运行多模态大模型的实

本文介绍了基于PostgreSQL和Python的医学AI数据库操作实现,以及MinIO对象存储管理。主要内容包括:1)使用psycopg2库连接PostgreSQL数据库并初始化5个核心表(患者、训练模型、合成任务、合成影像和评估指标);2)封装数据库增删改查操作类MedicalAIDB,提供模型记录插入、任务创建、状态更新等功能;3)示例演示了DDPM模型参数记录和合成任务创建流程。系统采用哈

本文分享了在GitCode平台上使用昇腾NPU部署llava-1.5-7b-hf模型的全流程实践。作者基于前期CodeLlama-7B模型部署经验,详细介绍了环境搭建、模型适配和性能优化过程。文章重点展示了GitCode Notebook的NPU配置选择(昇腾910B)、模型下载、环境安装(使用阿里云镜像加速)以及测试代码实现。通过图文并茂的方式,为开发者提供了在国产算力平台上运行多模态大模型的实