简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

把transformers版本改一下。(报错时我使用的是transformers== 4.57.2)改成transformers==4.57.1即可。

这里有一些细节需要注意,第一个参数与第二个参数都要进行softmax(dim=-1),目的是使两个概率分布的所有值之和都为1,若不进行此操作,如果x或y概率分布所有值的和大于1,则可能会使计算的KL为负数。(至于为什么,大概是为了方便pytorch的代码组织,pytorch定义的损失函数都调用handle_torch_function函数,方便权重控制等),才能得到正确结果。其中kl_div接收三

这里有一些细节需要注意,第一个参数与第二个参数都要进行softmax(dim=-1),目的是使两个概率分布的所有值之和都为1,若不进行此操作,如果x或y概率分布所有值的和大于1,则可能会使计算的KL为负数。(至于为什么,大概是为了方便pytorch的代码组织,pytorch定义的损失函数都调用handle_torch_function函数,方便权重控制等),才能得到正确结果。其中kl_div接收三

因为文本不能够直接被模型计算,所以需要将其转化为向量。

其实思路就是利用argparse模块,给parse增加一个dir参数,这个参数用来存放超参数json文件夹所在路径。这样,我们训练模型时,只需要给好超参数文件所在位置即可,而具体的超参数可以直接在json文件中修改即可。

这里有一些细节需要注意,第一个参数与第二个参数都要进行softmax(dim=-1),目的是使两个概率分布的所有值之和都为1,若不进行此操作,如果x或y概率分布所有值的和大于1,则可能会使计算的KL为负数。(至于为什么,大概是为了方便pytorch的代码组织,pytorch定义的损失函数都调用handle_torch_function函数,方便权重控制等),才能得到正确结果。其中kl_div接收三

链接到某一篇笔记中的某个段落(块):[[ # ^ ]]为链接创建定义(关键词):[[ | 关键词]]链接到某一篇笔记中的某个标题:[[ # ]]链接到外部文件如印象笔记:[关键词](链接)链接到某一篇笔记:[[ ]]

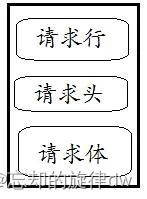

在熟悉项目的时候,遇到一个问题:用户登录后会获得一个唯一的uuid。在进行登陆后的其他操作时,都会先获取这个唯一id来证明用户是登陆状态。我在阅读代码时,发现这个标识(下面用loginCode来代表)都是通过@RequestHeader String loginCode来获取的。然而,我并不理解RequestHeader(我承认我大学是混子)。经过一番百度(其实是Bing),我大致了解到:@Req

这里有一些细节需要注意,第一个参数与第二个参数都要进行softmax(dim=-1),目的是使两个概率分布的所有值之和都为1,若不进行此操作,如果x或y概率分布所有值的和大于1,则可能会使计算的KL为负数。(至于为什么,大概是为了方便pytorch的代码组织,pytorch定义的损失函数都调用handle_torch_function函数,方便权重控制等),才能得到正确结果。其中kl_div接收三

批量归一化固定小批量中的均值和方差,后学习出适合的偏移和缩放可以加速收敛速度,但一般不改变模型精度。所以,你可以通过加入BN来调高你的学习率。也许你之前的学习率是0.01,加入BN后你可以调整到0.1。原因:之前梯度太大,上层梯度爆炸;梯度太小,下层更新慢。加入之后,每层放在相似的分布,可以用一个较大的学习率。