简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

GAN网络经常会见到或用到,但感觉对其理解不够深入,写此博客记录一下,方便今后查阅。

感觉这个游戏以后可以做可视化的图形用户界面,所以改进一下,先记下来。CRAPS又称花旗骰,是美国拉斯维加斯非常受欢迎的一种的桌上赌博游戏。该游戏使用两粒骰子,玩家通过摇两粒骰子获得点数进行游戏。简单的规则是:玩家第一次摇骰子如果摇出了7点或11点,玩家胜;玩家第一次如果摇出2点、3点或12点,庄家胜;其他点数玩家继续摇骰子,如果玩家摇出了7点,庄家胜;如果玩家摇出了第一次摇的点数,玩家胜;其他点数

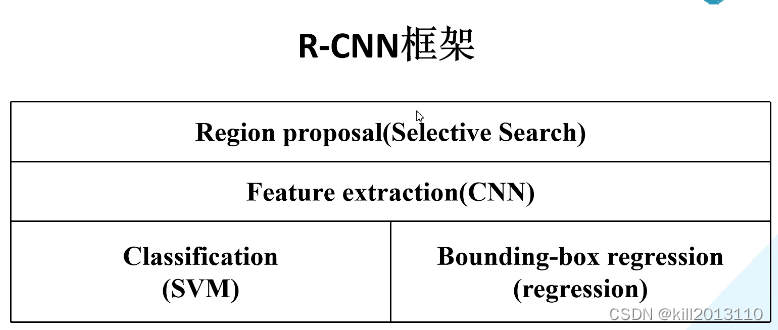

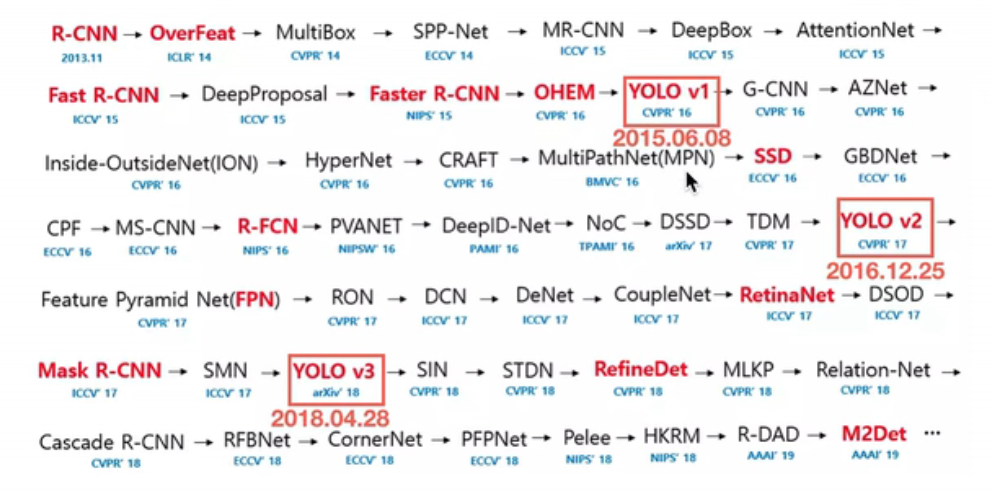

R-CNN:Region with CNN feature内容总结于 b站霹雳吧啦Wz博主,讲的很好,这里做简要总结。

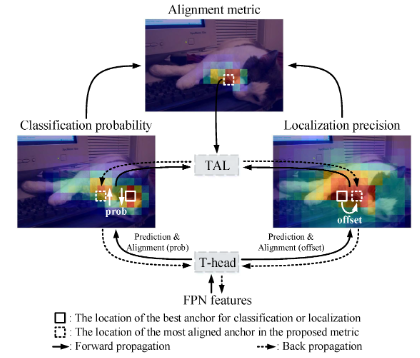

文章的动机与GFL类似,都是基于目标检测中分类与定位的相关性低,低分类得分数但高定位精度的预测框可能会被nms掉这一问题。本文试图统一分类得分与回归质量,并设计了更强的bbox表达方式和优化方法。......

coco数据集的评价指标的计算还是比较复杂的,代码写的也比较凝炼,最近要计算目标检测的混淆矩阵,我看mmdet的计算方式比较奇怪,本着P和R等计算方法要与coco官方对齐的目的,特地写此笔记对coco官方的计算方式进行深入理解。coco计算不同map有很多变量:iou阈值,目标的面积范围,最大检测框数量等。coco首先使用cocoEval.evaluate() 函数进行匹配计算,然后使用cocoE

mindspore实现单阶段目标检测模型TOOD

目标检测算法最难理解的,设计最复杂的就是正负样本分配和损失函数这块了,这两者将很大程度决定网络的训练效果,因此开帖对yolo系列做一总结,重点也在这两者,吸收他人优秀博客内容,进行整理。.........

在目标检测领域,单阶段算法精度第一次超过双阶段,就是RetinaNet。

目标检测的两个任务,分类和位置回归,本帖将经典的位置回归损失函数总结如下,按发表时间顺序。L1最低点是不可导的,所以势必不会收敛到最低点,可能会在最优解附近震荡。而L2损失容易在离群点产生梯度爆炸的问题。smooth L1则集两者的优点于一身。提出IoU loss的论文:不论是L2还是smooth L1 loss都没有考虑到四个点的关联性和尺度不变性,这个是比较致命的缺点,当两对预测框与GT框的I

在v2中,作者基于v1中回归任务的离散概率分布估计,对回归任务进行质量评估,以帮助NMS时保留到回归质量最好的边界框。其直观的原理是这样的:估计的离散概率分布越平滑,那不确定性越高,网络对得到的框的质量是表示怀疑的,概率分布越尖锐,表示确定性很高,网络很笃定回归得到的边界框。