简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

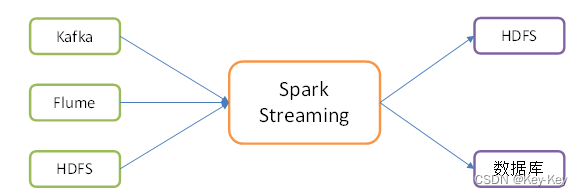

需要继承receiver,并实现onstart、onstop方法来自定义数据源采集。

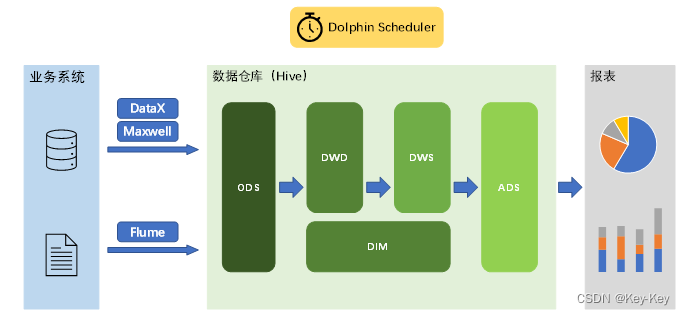

1、数据需求:用户分析日志log、业务数据db2、采集需求:日志采集系统(flume)、业务数据同步系统(Maxwell,datax)3、数据仓库建模:维度建模4、数据分析:对设备、会员、商品、地区、活动等电商核心主题进行统计,统计的报表指标接近100个。5、即席查询:用户在使用系统时,根据自己当时的需求定义的查询,通常使用即席查询工具。6、集群监控:对集群性能进行监控,发生异常及时报警。7、元数

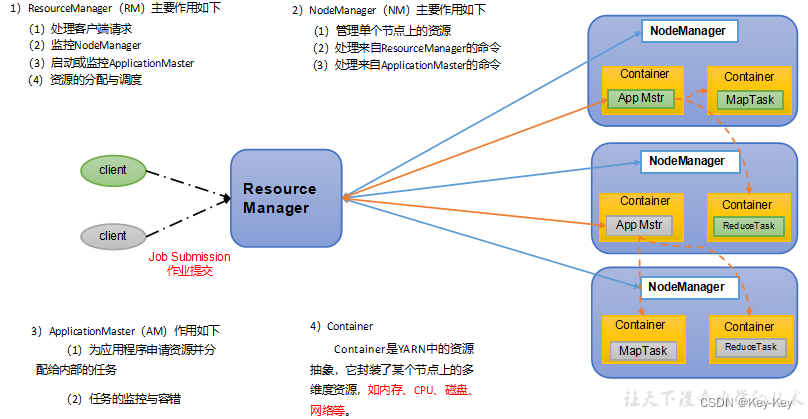

思考:1、如何管理集群资源?2、如何给任务合理分配资源?Yarn是一个资源调度平台,负责为运算程序提供服务器运算资源,相当于一个分布式的操作系统平台,而MapReduce等运算程序则相当于运行于操作系统之上的应用程序。

1、hashpartitioner源码解读case _ =>false2、自定义分区器要实现自定义分区器,需要继承org.apache.spark.partitioner类,并实现下面三个方法。1)numpartitions:int:返回创建出来的分区数2)getpartition(key:any):int:返回给定键的分区编号(0到numpartitions-1)3)equals():java判

Spark客户端将应用程序提交给集群的Spark主节点(Master)。Spark主节点接收到应用程序后,会将应用程序的信息存储在调度器中,并将应用程序的任务分配给可用的工作节点(Worker)。工作节点根据分配的任务,在本地启动Spark执行器(Executor)进程。每个Executor进程会启动一个或多个执行线程,用于执行应用程序的任务。Executor进程会从Spark主节点获取应用程序的

数据库索引在数据库管理系统中起着至关重要的作用,它可以大大提高数据检索操作的性能。面试中,对于数据库索引的深入理解是一个重要的考察点。本文摘要涵盖了关于数据库索引的一系列面试题,涵盖了索引的基本概念、类型、优化和应用等方面的内容。

事实表作为数据仓库维度建模的核心,紧紧围绕着业务过程来设计。其包含与该业务过程有关的维度引用(维度表外键)以及该业务过程的度量(通常是可累加的数据类型字段)事务事实表用来记录各业务过程,它保存的是各业务过程的原子操作事件,即最细粒度的操作事件。粒度是指事实表中一行数据所表达的业务细节程度。周期快照事实表以其规律性的、可预见性的时间间隔来记录事实,主要用于分析一些存量型(例如商品库存,账户余额)或者

Java中的String是不可变的,这是因为String类被设计成了不可变的对象。这意味着一旦一个String对象被创建,它的值就不能被修改。线程安全:不可变的特性使得String对象在多线程环境中是安全的。因为它的值不可变,不会被其它线程修改,所以不需要同步控制。缓存哈希值:String类将哈希值缓存在对象中,因为它是不可变的,所以哈希值只需要计算一次,而不需要每次使用时重新计算。这样可以提高性

Hive的三种自定义函数包括UDF(User-Defined Function(用户定义函数))、UDAF(User-Defined Aggregate Function(用户定义聚合函数))和UDTF(User-Defined Table-Generating Function(用户定义表生成函数))。UDF是最常见的自定义函数类型,用于对单个输入值进行处理并返回一个输出值。

数据库索引在数据库管理系统中起着至关重要的作用,它可以大大提高数据检索操作的性能。面试中,对于数据库索引的深入理解是一个重要的考察点。本文摘要涵盖了关于数据库索引的一系列面试题,涵盖了索引的基本概念、类型、优化和应用等方面的内容。