简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

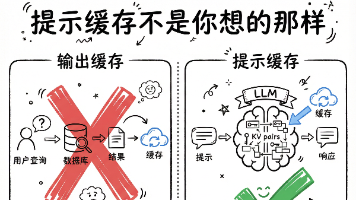

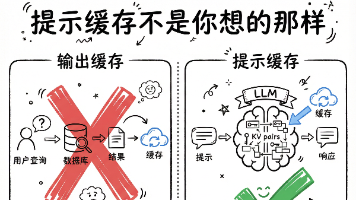

AI 技术发展得太快了,每隔几个月就有新概念冒出来。但很多时候,真正能帮你省钱提效的,不是那些最新最炫的技术,而是这些藏在底层的优化技巧。提示缓存就是这样一个技巧。它不性感,不酷炫,但实实在在能帮你省一半的成本。如果你也在做 AI 应用,不管是聊天机器人、文档总结、还是代码生成,都可以试试提示缓存。记住三个要点就行了。第一,提示缓存缓存的是输入的中间计算结果,不是输出。第二,把静态内容放在提示词前

AI 技术发展得太快了,每隔几个月就有新概念冒出来。但很多时候,真正能帮你省钱提效的,不是那些最新最炫的技术,而是这些藏在底层的优化技巧。提示缓存就是这样一个技巧。它不性感,不酷炫,但实实在在能帮你省一半的成本。如果你也在做 AI 应用,不管是聊天机器人、文档总结、还是代码生成,都可以试试提示缓存。记住三个要点就行了。第一,提示缓存缓存的是输入的中间计算结果,不是输出。第二,把静态内容放在提示词前

【AI时代的编程学习困境】文章揭示了当前开发者面临的两极分化现象:一部分人过度依赖AI工具,丧失独立思考和编码能力;另一部分人则善用AI提升效率。作者指出,依赖AI复制粘贴代码的"伪学习"方式,导致开发者无法通过技术面试,缺乏解决实际问题的能力。建议将AI作为学习工具而非拐杖,通过断网测试、解释驱动等方法验证真实掌握程度,同时强调基础知识的重要性。在AI时代,保持批判性思维和独

Kimi K2.5模型实测显示其在创意性任务上表现出色,但在精确性任务上仍有不足。该模型在多模态识别、Agent集群协作、办公文档制作和编码等方面展现惊人能力,能够处理复杂图片、自动拆解任务并生成高质量设计作品。然而在数据准确性、时效性判断和复杂决策等需要精确信息的场景中频繁出错。测试者建议根据具体需求选择使用场景:创意工作可优先考虑K2.5,而精确任务则需谨慎验证。总体而言,K2.5作为开源模型

本文探讨了Transformer模型自2017年问世以来的重大进化,聚焦其架构和记忆能力的突破性发展。在架构方面,MOE(稀疏门控专家混合)技术通过"按需出动"的专家分工机制,使万亿级参数模型得以高效运行。在记忆方面,KV Cache优化和状态空间模型大幅扩展了上下文长度,而泰坦架构和RAG技术则解决了长期记忆问题。这些创新使当代大模型突破了原始Transformer的算力限制

ClawdBot测试3天后发现的残酷真相:它并非适合所有人。这个AI代理与传统助手不同,具有长期记忆、主动行动和本地运行三大特性,能自动整理资料、筛选信息、安装工具等。但它的核心价值是节省时间和提高决策质量,对月收入不足1万美元的用户帮助有限。真正的赢家不是最早使用的人,而是找到合适场景的人。建议从小场景开始试用,让AI逐步学习你的需求。AI时代,冷静评估工具的实际价值比盲目跟风更重要。

KV Cache是AI快速生成文本的关键技术,它通过缓存计算过的K(键)和V(值)矩阵来避免重复计算。在生成式AI中,每个新词的预测都需要之前所有词的K和V矩阵,如果没有缓存,计算量会呈平方级增长。KV Cache将这些矩阵存储起来,使计算次数从O(n²)降至O(n),速度提升数百倍。虽然会占用更多内存(导致对话长度受限),但这种"空间换时间"的策略让AI实现了近乎实时的响应能

SLM、LLM、FM如何选择?一文读懂AI模型选型指南 AI模型并非越大越好,合适才是关键。本文解析三种主流模型的特点与应用场景: SLM(小型模型):参数量小(<100亿),专注特定任务,速度快、成本低,适合文档分类等简单任务,可本地部署保障数据安全。 LLM(大型模型):参数量大(数百亿),知识面广,擅长客服对话等需要泛化能力的复杂任务,但成本较高。 FM(前沿模型):参数量极大(数千亿

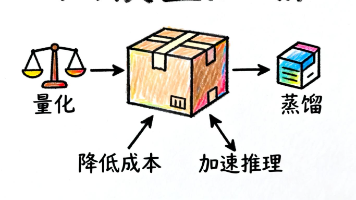

本文探讨了大语言模型压缩的两大主流技术——量化和蒸馏。量化通过降低参数精度(如Float32转INT8)来减少存储空间和计算资源,保持性能的同时显著降低成本。蒸馏则通过让小模型模仿大模型的行为,在缩小规模的同时保留相似能力。文章比较了两者的优缺点:量化简单高效适合快速优化,蒸馏灵活适合大幅压缩或训练新模型。此外还提到剪枝等其他技术,但强调量化和蒸馏是目前最实用的方法。这些技术使大模型更易部署,推动

摘要:大模型如何理解人类文字 本文系统阐述了大模型理解人类文字的演进历程。早期采用独热编码存在维度灾难和语义缺失问题,随后词嵌入技术(如Word2Vec)将单词映射到低维向量空间,通过上下文预测学习语义关系。GloVe引入全局共现统计,FastText创新性采用子词单元,增强了生僻词处理能力。随着BERT等模型出现,实现了基于上下文的动态语义表示,通过掩码语言模型和注意力机制,大模型不仅能处理一词