简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

GenieBlue为移动端多模态应用(如智能助手、图像问答)提供了高效解决方案,推动AI在边缘设备的落地。:大语言模型、多模态、边缘计算、移动端部署。

首次证明RL训练可有效提升MLLMs的复杂推理能力,为多模态模型在教育、科研等领域的应用奠定基础。:多模态大模型、推理能力、冷启动、强化学习。

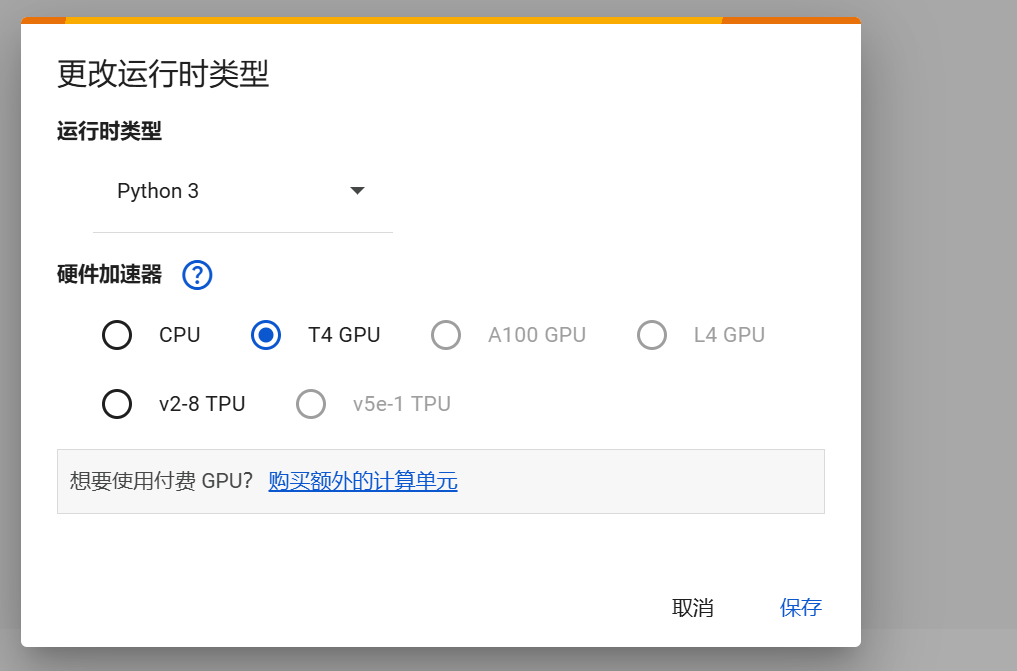

最近把我的论文总结ai agent ()往cloab迁移,目的是解决抓取国外文献网络限制问题,正好突发奇想,是否可以在colab上运行deepseek,结果还真可以。本文将分享如何在 Google Colab 上运行 Ollamadeepseek的详细步骤。

阿里云开发者大会大佬讲一个老师不懂开发,在钉钉代码平台创造了18个应用打造了智慧校园。那么低代码平台是鬼?低代码意味着什么?它为什么重要?受众是谁?以及常见的用例!什么是低码?这里,"低代码"是指技术内部的运动。让我们从低代码的简单定义开始。简而言之:一种可视化工具,可以代替一定程度的编写代码就像这个定义一样简单,关于低代码和这个术语的含义存在很多混淆。为什么"低代码"一词令人困惑?因为"低代码"

之前开源了,但是对非计算机专业来说,门槛有点高,再加上docker hub镜像被屏蔽,更是不容易上手啊。也有考虑用dify或者扣子去复刻一个,但是从专业用户的角度出发通过界面来拖拽配置实在是不高效,没有自己写代码来的直接,但是对非计算机专业的用户确实不友好。为了降低一下门槛,稍微进行了改进。下面开始正文:这个开源项目其中有个环节是利用firecrawl抓取论文,然后转成对大模型友好的LLM格式。

There are two possible causes:An attempt was made to issue an ALTER SESSION statement with an invalid NLS parameter or value.The NLS_LANG environment variable contains an invalid language, territory..

Portia可视化数据采集爬虫配置高端玩法(3)百度portia就可以获取爬虫配置高端玩法,该工具给您更多的自由度!

目录数据传输和采集Sqoop数据传输工具Flume日志收集工具Kafka分布式消息队列数据存储Hbase分布式Nosql数据库Hdfs分布式文件系统大数据处理HadoopSpark数据查询分析工具Apache HivePig、Impala和Spark SQL机器学习MahoutSpark mllib其他工具大...

python自动化运维-系统信息监控最近负责的几个省的项目,问题频出,经常接到运维同事这样的反馈jvm cpu%ogg 断了oracle 归档日志满了以上原因可能导致数据不能正常接收并传输,因此还要想办法补救,运维同学焦头烂额,因此半夜开发接到电话是很正常的。那么问题来了有没有解决办法,能及时提醒?答案是肯定的!系统信息监控运维离不开对系统信息的监控,如CPU的使用率、内存的占用情况、网络、进程等

In my cefpython application I specify a remote debug port:switches = {"remote-debugging-port": "22222"}cefpython.Initialize(settings, switches)Run chromedriver:chromedriver --port=33333I’m u...