简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

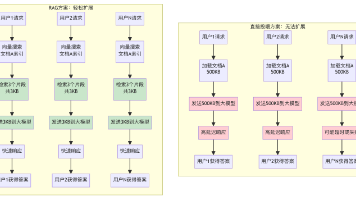

本文分析了直接向大模型投喂完整文档的"反模式"及其性能瓶颈,提出了RAG(检索增强生成)架构的优化方案。通过对比实验显示,RAG架构可将大模型应用的API成本降低99.76%(从单次$3.75降至$0.009),响应时间缩短70-90%(30秒→3秒),并发能力提升10-100倍。RAG的核心优势在于预处理文档切片并建立向量索引,使每次查询仅需检索相关片段而非完整文档,大幅减少

Ollama是一个开源的大语言模型运行框架,支持在本地计算机上部署和管理各种LLM。本文介绍了在Mac上通过Docker安装Ollama的详细步骤,包括:1)使用Docker运行Ollama容器;2)进入容器并下载轻量级模型(推荐phi3:mini或llama3.2:1b);3)通过命令行或API与模型交互;4)可选安装Open-WebUI图形界面。文章还提供了常见问题解决方案(如内存不足错误)和

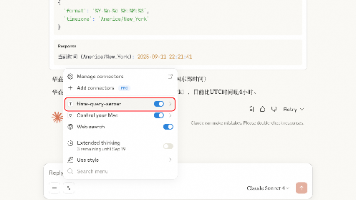

本文介绍了一个基于MCP协议和Ollama本地大模型的智能时间查询系统。该系统由两部分组成:时间服务器(time_server.py)提供获取当前时间和列出时区的工具函数;客户端(time_client_test3.py)利用Ollama模型分析用户查询并智能调用时间服务。时间服务器实现了完整的时区处理和错误提示功能,通过MCP协议暴露工具接口。客户端采用异步连接管理和多重策略解析模型响应,能够智

本文展示了一个基于MCP协议的时间查询服务器示例。该Python脚本提供了四个主要功能:1)获取指定时区的当前时间并可自定义格式;2)查询特定时区的详细信息;3)列出常用时区可按地区过滤;4)计算两个时区之间的时间差。服务器通过标准输入/输出(stdio)方式运行,使用pytz库处理时区转换,并提供了清晰的错误处理机制。每个功能都定义了输入参数模式,支持默认值设置,确保接口的易用性。

Ollama是一个开源的大语言模型运行框架,支持在本地计算机上部署和管理各种LLM。本文介绍了在Mac上通过Docker安装Ollama的详细步骤,包括:1)使用Docker运行Ollama容器;2)进入容器并下载轻量级模型(推荐phi3:mini或llama3.2:1b);3)通过命令行或API与模型交互;4)可选安装Open-WebUI图形界面。文章还提供了常见问题解决方案(如内存不足错误)和

Wireshark与对应的OSI七层模型TCP三次握手TCP三次握手的理论知识wireshark三次握手对应的报文情况图中可以看到wireshark截获到了三次握手的三个数据包。第四个包才是HTTP的, 这说明HTTP的确是使用TCP建立连接的。第一次握手数据包:客户端发送一个TCP,标志位为SYN,序列号为0, 代表客户端请求建立连接。 如下图:点评:报文中有2个序列号,上面截图中写着是Seq=

动态库*.so在linux下用c和c++编程时经常会碰到,最近在网站找了几篇文章介绍动态库的编译和链接,总算搞懂了这个之前一直不太了解得东东,这里做个笔记,也为其它正为动态库链接库而苦恼的兄弟们提供一点帮助。谈点实际价值:如果个人是使用的是Mac,而别人提供的链接库文件*.so是linux的,那么这个时候就不能直接使用了,这个链接表源文件在的话可以按照如下教程自行进行生成Mac版的...

如果你对某个开源项目非常感兴趣,其中的issue你发现你会解决,或者发现了遗留下来的问题,而且你也想参与进来去改进它,那么接下来的内容就是告诉你如何成为一个contributor。1. 注册一个github帐号进入github.com官网,点击右上角 Sign up按钮一顿猛操作就可以了,不多说了,相信你能搞定。2. 将项目fork到自己帐号这里以 arthas项目为例,进入项目页https://

一、设置垃圾收集器参数我们设置JVM垃圾收集器参数时,一个参数就同时指定新生代老年代各自的垃圾收集器了。-XX:+UseSerialGC,虚拟机运行在Client模式下的默认值,Serial+Serial Old。-XX:+UseParNewGC,ParNew+Serial Old,在JDK1.8被废弃,在JDK1.7还可以使用。-XX:+UseConcMarkSweepGC,...

相信很多人都看过《深入理解Java虚拟机》这本书(周志明著 ),很多人也都想参照着书中所述“自己编译jdk”的步骤来体验一下过程,但是实际操作过程中可能会遇到这样或者那样的问题,造成最终放弃掉。比如原因可能有: