简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

逻辑斯蒂增长模型的核心是增长受承载力的约束,初期因资源充足快速增长,后期因资源有限增速放缓,最终趋于饱和,我对其简单修正,加入一个令人悲伤的离场衰减项,这恰好契合互联网当下的跟风现象,无论是打卡景点还是入局 AI,参与者都会随信息裂变快速增加,但优质资源总有上限,最终拥挤不堪(内卷)。用本文的模型可以拟合西湖景区,哈尔滨冰雪游,淄博烧烤,智能手机,共享单车,新能源汽车,AI 大模型等,仍在持续增长

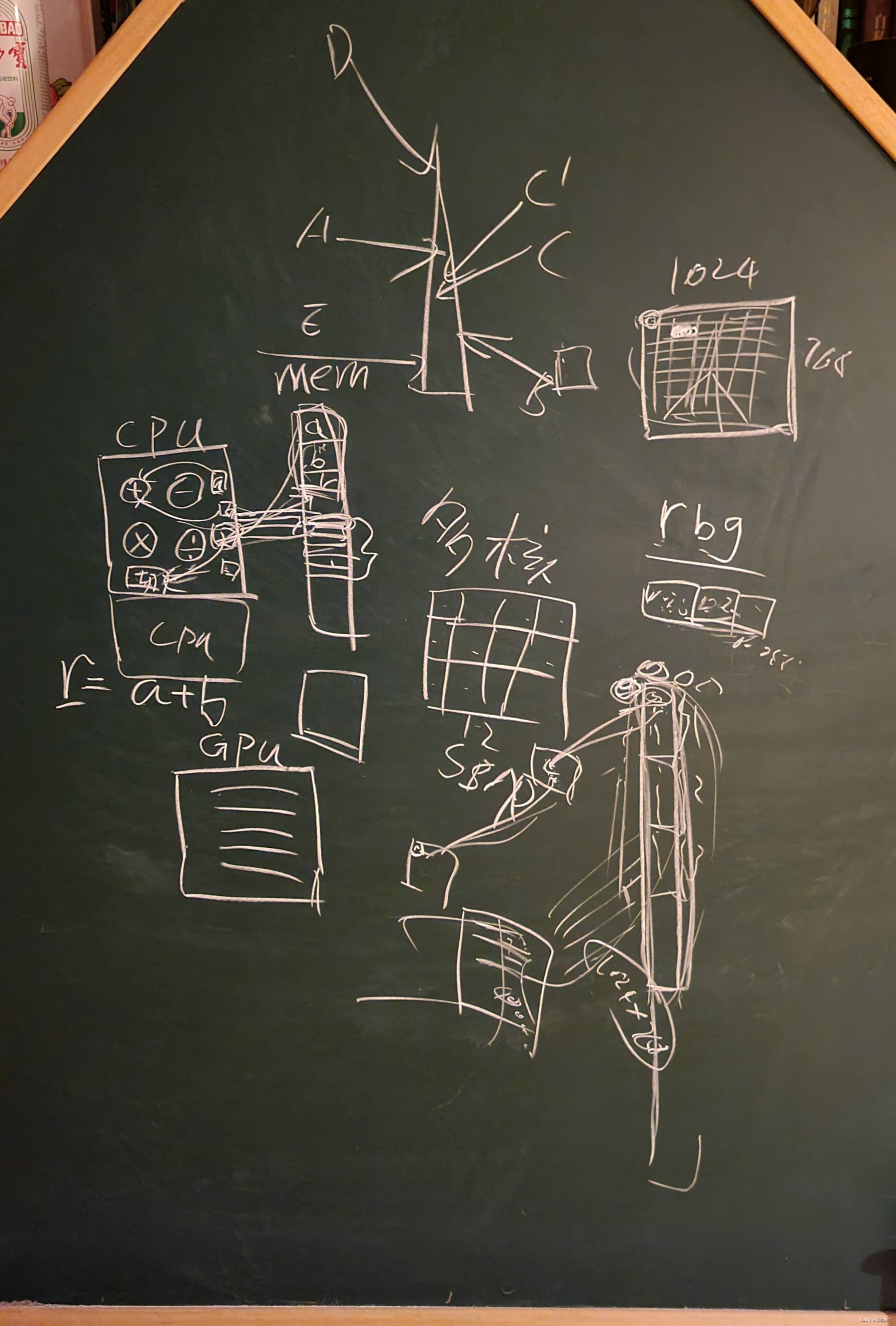

如果数据是严格保序的,通用机器需无条件满足该约束,典型例子是通用处理器,即 CPU,它的处理资源必须在时间维度分割成流水线,作为数据的串行指令在其中接力通过。还有一个问题,如果必须要搬运,数据搬运过程中为什么需要 buffer,为什么不能一镜到底,推而广之,为什么要接力,转介。既然处理器是通用机器,就没有专属数据,所以数据都要从别处调来,这就涉及到了数据搬运,就有了外设的概念。总之都是数据能不动就

我在十年前曾排查过多起由于多核网关并发处理 TCP 流导致其吞吐下降一到两个数量级的案例,彼时各类转发技术刚刚开始还没完全开始卷,大多数人觉得并行处理可优化一切(现在依然这样认为),却忽略了流式传输的内在约束,这些案例正反面证明我上面的论述,换句话说,把 MPTCP 调度策略去掉,按 roundrobin or 时间戳 hash 的方式选择 Subflow,将会获得类似结局。此外,MPTCP 路径

不会类比,不懂共情(这两点一向是被计算机背景的理工群体鄙视的),没有泛化能力,无法举一反三,不会归纳演绎,这才是 AI 的瓶颈,而不是铺天盖地的算力,以及那些以为 scale 就够了的能力,但在本质上,只要 AI 仍然是个概率预测机器,那些 scale up 也好,scale out 也好,都仍然在做概率预测,正如它们名字一样,规模扩大了而已。这个过程最精妙的结果是,在交叉熵损失和 Softmax

cpu 互联网只是数据的仓库,无论是你浏览网页,看视频,玩游戏,所有的内容几乎都来自于 “录入”,你上传一张图片,图片就保存在某个地方,当人们想看它时,它就从这个地方传输到人们眼前的屏幕上,互联网核心只看管数据,却无力触动数据,因为算力不行。我解释到,手工操作类似 cpu,机器批量操作类似 gpu,jpu。我只能这样讲,因为小孩子喜欢很酷的东西,他们喜欢无人机根据人的遥控去送货胜于人根据算法的指令

最近看大模型相关的论文和书籍,发现了宝藏,这里面全都是我感兴趣的单点,概率统计学,非线性,GPU 并行的切割方向,负反馈,矩阵,函数图像…当模型对某个类别的预测概率高于真实概率时,梯度为正,提示应该降低相应的 logit,当预测不足时,梯度为负,提示应该增加 logit。影响更大,两者偏离越大,损失越大,直观上看,交叉熵更重视出类拔萃者,而忽略了卑微者,这就是一种有意义的 “拔优”,涌现正基于这种

在做法上,我可能会用实际流量样本训练 DCN 本身,在它能为拥塞控制给出建议之前,实际的流量或人为注入的流量(例如 incast)最为输入,人工的,传统算法的或 SDN 的决策作为目标,都是该 AI DCN 的学习样本,该 AI DCN 就像一个神经网络本身一样收敛,涌现出应对任何流量模式的即时应对措施,在我看来这就算一种即时的 “在线推理”。不管怎样,信息守恒,只是难以暴露,依赖大模型的涌现能力

写这篇文章有四个理由。周一下午一个僵死一年的传输优化群突然有人问 BBR 的问题,没什么人接话;我每周五晚上到周日早晨都会写网络方面的随笔记录并分享在 pyq,经常有人评论 AI 如何,我颇为不屑;周四早上看,已经很少有我精通的了;我并不好奇当今几乎所有的招聘以及各个技术群的话题都与大模型相关,我担心的是如果不去擦点边,将来会很艰难,甚至群里瞎扯淡都插不上话,所以我花了点时间浏览了。

本质上 capacity-seeking 也由此导致,你不能干巴巴眼睁睁看着并行资源长期空闲,就必须让串行流尽可能粗壮,这里有两个相互决定,早期终端单线程处理结构决定了流式传输协议行为,后期流式传输结构反过来制约终端的并行处理能力,决定了终端串行处理以及奇技淫巧的行为,悲观讲,二者错配,用发展的眼光,这是螺旋上升的必然。有知识不一定有文化,会做并不意味着懂,作为工程的网络,做过的都会做,但就像流水