简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

阿里云开源了其视频生成大模型Wan2.1(万相),采用了较为宽松的Apache2.0协议。而这次对外了1.3B(极速版)和14B(专业版)两个参数规格的权重,及推理的全部代码。这两种模型均支持文生视频(T2V)和图生视频(I2V)任务。14B版本在权威评测集VBench中以86.22%总分超越SoraLuma等国内外模型;1.3B版本可在消费级显卡运行(仅需8.2GB显存生成480P视频),适合二

这些算法尝试保留尽可能多的结构(例如,尝试保持输入空间中的单独簇在可视化中不重叠),以便您可以了解数据的组织方式,并可能识别出意想不到的模式。它可能会注意到,40% 的访问者是喜欢漫画书并通常在放学后阅读您的博客的青少年,而 20% 是喜欢科幻小说并在周末访问的成年人。的一个分支,训练代理(例如机器人)来选择随着时间的推移最大化其奖励的操作(例如,机器人可能会获得奖励) 每当玩家在给定环境(例如游

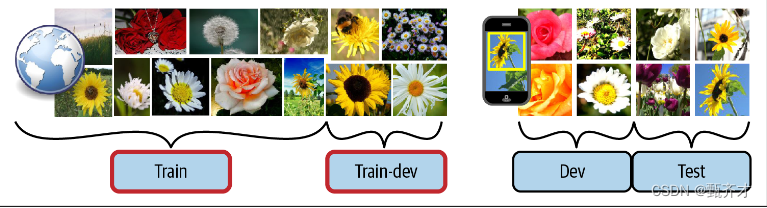

在此保留验证过程之后,您可以在完整的训练集(包括验证集)上训练最佳模型,这将为您提供最终模型。在这种情况下,需要记住的最重要的规则是,验证集和测试集都必须尽可能具有生产中预期使用的数据的代表性,因此它们应该完全由有代表性的图片组成:您可以对它们进行洗牌,将一半放在验证集中,另一半放在测试集中(确保在这两个集合中都没有重复或接近重复的数据)。在网络图片上对模型进行培训之后,如果您观察到模型在验证集上

阿里千问团队开源了到端全模态大模型,一时之间,炸燃了AI界。而这次千问团队开源的,可谓是将看、听、读及写集于一身的全能型的大模型。

Qwen2.5-VL是阿里云推出的开源多模态大模型,支持等功能。较上一个版本Qwen2-VL有质的飞越,Qwen2.5-VL通过动态分辨率适配和窗口注意力机制,显著降低显存占用并提升推理速度,72B模型在单卡A100上推理速度提升30%。身在AI这股浪潮中,只要本地电脑硬件条件允许的话,我都会尝试着去部署优秀的开源大模型。说到开源大模型,相对而言的就是闭源大模型,我们在脑海中很自然地浮现出国外的O

在人工智能时代,语音合成()技术已成为人机交互的核心组件之一。然而,传统系统长期受限于多阶段架构复杂、语音控制能力弱、跨语言表现差等问题。

Whisper是由OpenAI开发的开源语音识别模型,以其著称。它通过68万小时的多语言、多任务数据训练,覆盖100+语言,支持语音转录、翻译和语言检测,成为目前最通用的语音识别工具之一。

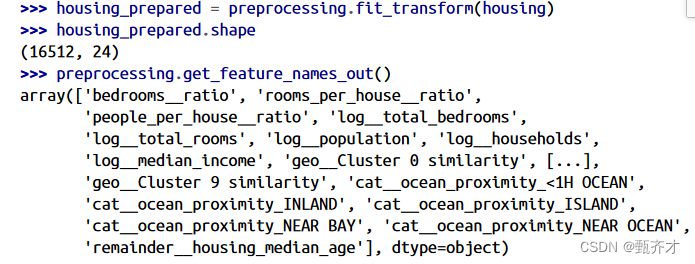

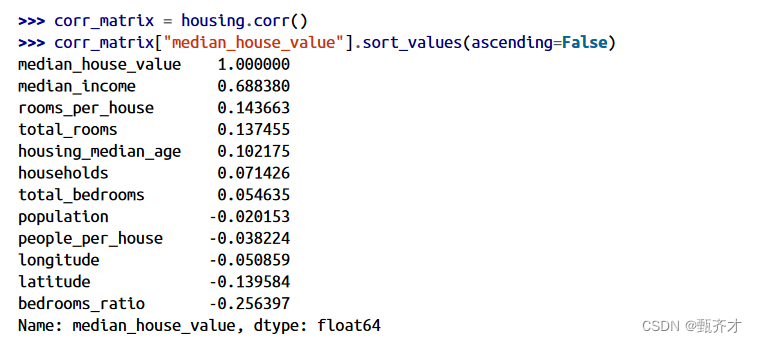

在为机器学习算法准备数据之前,您可能需要做的最后一件事是尝试各种属性组合。例如,如果你不知道一个地区有多少住户,那么这个地区的房间总数就不是很有用。你真正想要的是每个家庭的房间数量。同样,卧室总数本身也不是很有用:你可能想对比一下房间的数量。

在本地电脑硬件条件有限情况下,只能部署些参数小点的模型,虽然很多平台也提供了免登录,可以在线把玩满血版的DeepSeek。可我们总是寄望于国内外的这些大厂,能够训练出一个参数小点,且又能比肩。这不,阿里推出了一款可以媲美(671B)的小参数模型——QwQ-32B。QwQ-32BQwQ-32B小钢炮撼动了的“江湖地位”。甭管是QwQ团队的测评结果,还是来自“民间”的吹捧。最终,我们总得自己亲身部署了

由于列出所有的列名不是很方便,Scikit-Learn提供了一个make_column_selector()函数,该函数返回一个选择器函数,您可以使用它来自动选择给定类型的所有特性,例如数值型或类别型。最后,我们构造了一个列变换器。它的构造函数需要一个三元组(3-tuple)列表,每个三元组包含一个名称(必须是唯一的且不包含双下划线)、一个转换器和一个应该应用转换器的列的名称(或索引)列表。例如,