简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

通义千问是阿里云开发的大语言模型(Large language Model )LLM,旨在提供广泛的知识和普适性,可以理解和回答各领域中的问题,其包含网页版和手机版本的通义前文APP,网页使用的模型为不公开的最新版本。在其官方文档中主要开源了五种可以使用的模型其开源模型的简介和参数如下:非限时免费开发模型,有使用Token数量的限制。

本文记录了,复现联邦学习论文中开展MNIST的 IID 训练的全过程,从预处理流程在一个电脑上模拟多个客户端,到下载数据处理数据,到训练代码的详细解释,到最后的结果对比,耗心耗力,终于是完成了。

先介绍一下DRIVE数据集DRIVE数据集主要用于血管分割任务,其中的图像由用于血管定位的手动标记进行了标注。这个数据集的目的是促进与视网膜图像分析、血管分割和疾病诊断相关的计算机视觉算法的发展。数据集下载之后,打开文件目录如下,这里我把trainning文件夹的名字换成了train这里的文件夹分为三种一种是images保存的原来的图像mask保存的是掩码标签1st_manual 2nd_manu

本文逐句精度了,常用的传统经典TPE超参数算法论文,并对其中的核心公式进行了详细推导(网上没找到其他人的),适用于想了解TPE算法原理的同学们。

本文记录了,使用Utralytics平台中的YOLO V11 训练COCO数据集的全流程,包括环境配置,模型下载,数据集下属在,文件目录搭建,标签生成,以及最后的运行结果。

通义千问是阿里云开发的大语言模型(Large language Model )LLM,旨在提供广泛的知识和普适性,可以理解和回答各领域中的问题,其包含网页版和手机版本的通义前文APP,网页使用的模型为不公开的最新版本。在其官方文档中主要开源了五种可以使用的模型其开源模型的简介和参数如下:非限时免费开发模型,有使用Token数量的限制。

最近看了一篇大佬的注意力机制的文章然后自己花了一上午的时间把按照大佬的图把大佬提到的注意力机制都复现了一遍,大佬有一些写的复杂的网络我按照自己的理解写了几个简单的版本接下来就放出我写的代码。顺便从大佬手里盗走一些图片,等我有时间一起进行替换,在此特别鸣谢这位大佬。

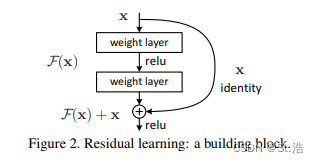

由于深度学习的会面临退化的问题,也就是当深度学习的网络加深到某一程度之后再加深会导致准确率降低,为了保证加深的网络的性能不低于浅层次的网络,为此2015年何凯明大佬发表了著名了ResNet残差网络,既再GoogLeNet在横向维度的创新之后,在网络结构上进行了新的创新。链接: ResNet原文地址结构的原理并不复杂,看一下从原文截取出来的这个残差结构,很好理解就是把输入最后加入到的输出上,构造一个

首先安装torch_geometric需要安装pytorch然后查看一下自己电脑Pytorch的版本然后进入官网文档网站链接:安装自己的版本选择安装命令,我python用的稳定的3.8版本。如果安装失败可以考虑降低python的版本因为我之前安装过所以显示如下。

本文记录了安装 Ollama 下载 DeepSeek模型,使用 Python 代码对 Ollama 下载的模型进行调用和推理的全过程,简单易懂,全程无痛。