简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

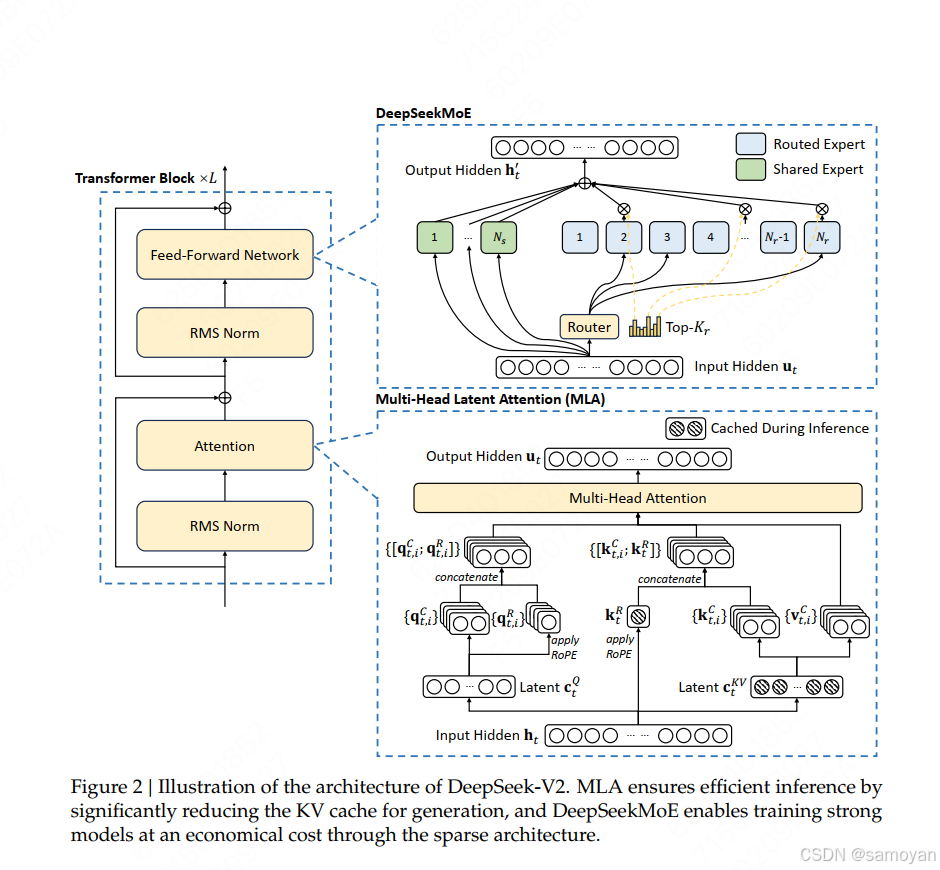

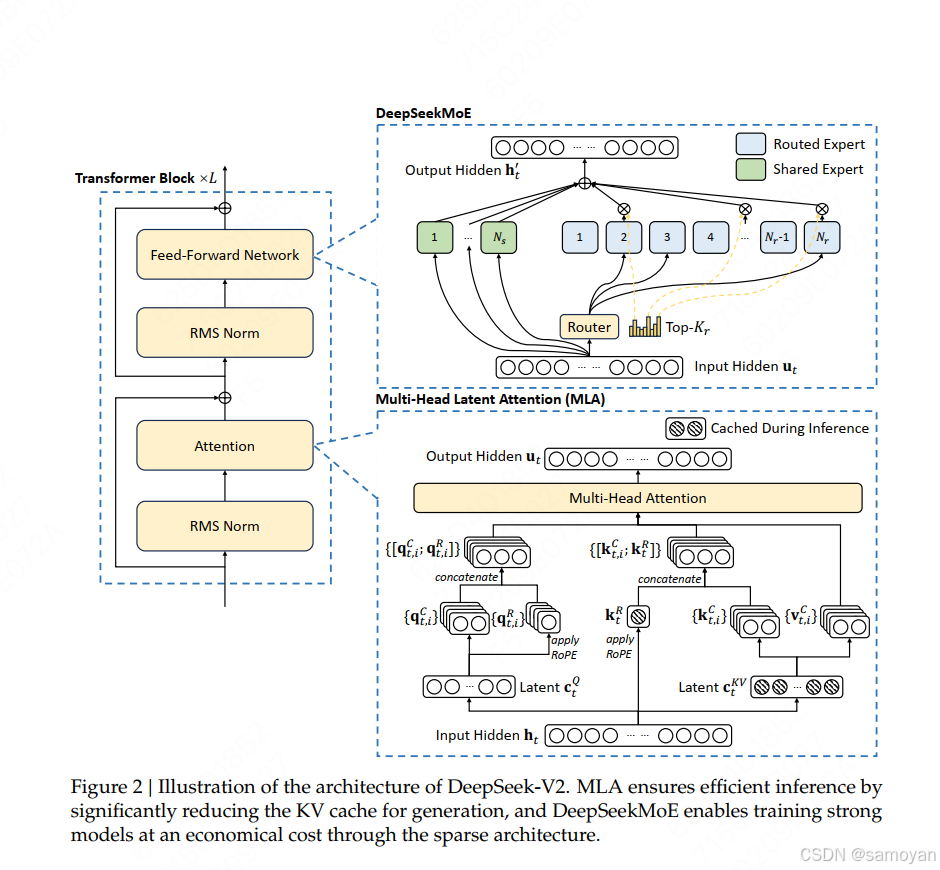

多头潜在注意力(Multi-head Latent Attention, MLA)是一种改进的注意力机制,旨在解决传统多头注意力(Multi-head Attention)在计算效率和内存占用上的瓶颈。,具体的需要看技术报告了。为了降低训练过程中的激活内存activation memory,还对queries进行低秩压缩(虽然这并不能降低KV Cache),其对Q的压缩方式和K、V一致,依然是先降

使用fuser命令可以查看哪些进程正在使用指定的文件或目录。在Linux系统中,GPU设备通常被映射到/dev/nvidia*文件中,因此可以使用fuser命令来查看哪些进程正在使用GPU设备。在上述示例中,可以看到/dev/nvidia0设备正在被PID为1234的python进程使用,/dev/nvidia1设备正在被PID为5678的tensorflow进程使用。执行上述命令后,会列出所有正

sudo nvidia-docker run -p 8888:8888 --name tf1.11_py3 -it -v /home/wang/:/home/wang 0641cda31e80解决了下面问题:>>> import tensorflowTraceback (most recent call last):File "<stdin>", line 1, in

方法直接产生文本时,通常返回的是文本的 token ID 序列。为了获得每个 token 的生成概率,你需要使用模型的。是模型在softmax层之前的输出,表示模型对每个可能的下一个 token 的置信度。应用softmax函数,我们可以得到每个 token 的生成概率。当使用大型语言模型(如 GPT-2、GPT-3、BERT 等)的。应用softmax函数,可以得到概率分布。使得模型返回生成每个

多头潜在注意力(Multi-head Latent Attention, MLA)是一种改进的注意力机制,旨在解决传统多头注意力(Multi-head Attention)在计算效率和内存占用上的瓶颈。,具体的需要看技术报告了。为了降低训练过程中的激活内存activation memory,还对queries进行低秩压缩(虽然这并不能降低KV Cache),其对Q的压缩方式和K、V一致,依然是先降

return m这个函数计算了每个头部的斜率。首先,它计算了n,这是最接近n_heads的2的幂。然后,它计算了一个基础斜率m_0,并使用这个基础斜率生成了一个斜率数组m。如果n小于n_heads,则生成另一个斜率数组m_hat并将其添加到m中。结果是一个长度为n_heads的斜率数组。return m这个函数计算了ALiBi的偏置。首先,它获取了斜率数组m,然后计算了一个距离矩阵distance

from sklearn import datasets, svmfrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import confusion_matrixiris = datasets.load_iris()X = iris.data[:, :2]y = iris.target

它提出了一种新颖的多模态大语言模型 (MLLM) 架构,称为 “Ovis”。该架构吸收了大语言模型 (LLMs) 的洞见,从而建立视觉输入的结构化嵌入。如图1所示,Ovis 引入了一个额外的可学习视觉嵌入查找表,用以转换连续的视觉tokens,从而与文本嵌入的结构完整性相呼应。图2展示了在各种基准测试中,Ovis 在相同参数范围内优于开源 MLLMs,而 Ovis-14B 在整体表现上也超越了高资

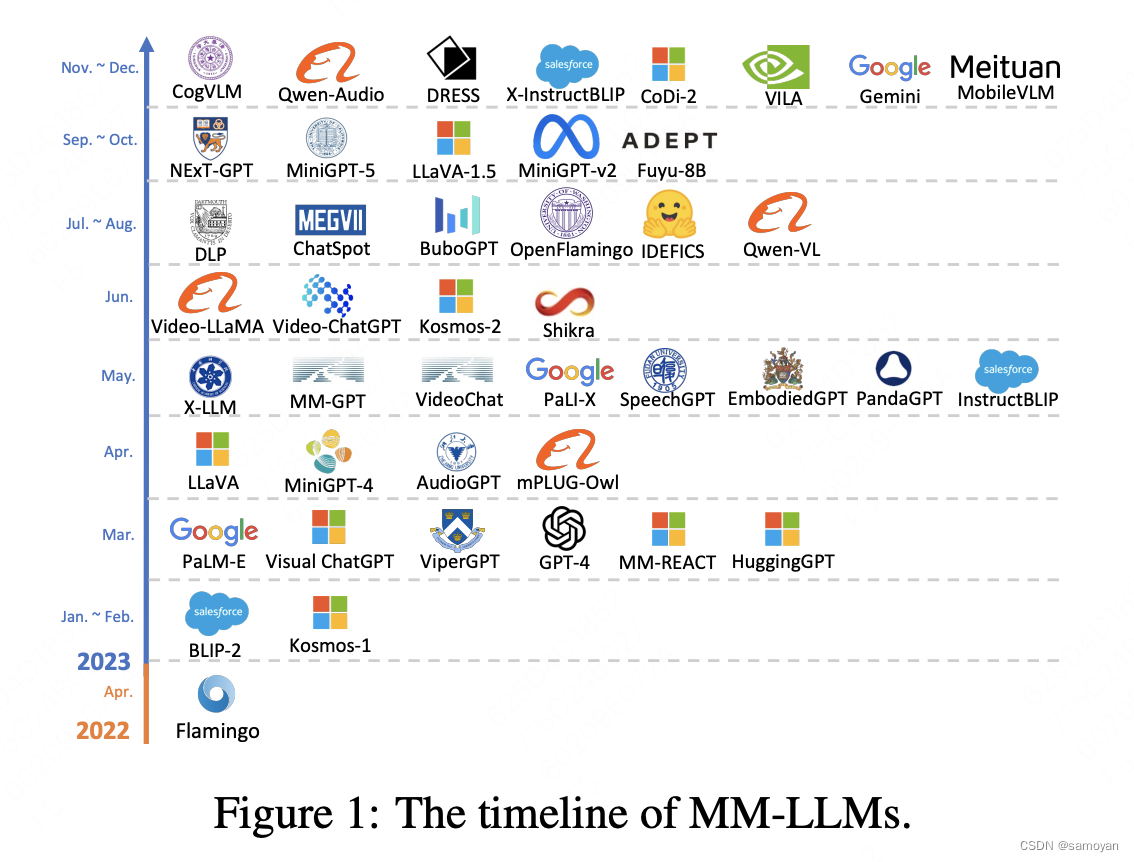

论文:MM-LLMs: Recent Advances in MultiModal Large Language Models。

多模态ner 论文和代码 资源整理