简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

现代机器人训练是一个仿真与真实交织、算法与工程并重的领域。在高度随机化的虚拟世界中,通过强化学习等算法进行大规模“数字练兵”,再利用各种技术将习得的技能“迁移”到物理实体上,最终通过少量真实数据微调并安全部署。

现代机器人训练是一个仿真与真实交织、算法与工程并重的领域。在高度随机化的虚拟世界中,通过强化学习等算法进行大规模“数字练兵”,再利用各种技术将习得的技能“迁移”到物理实体上,最终通过少量真实数据微调并安全部署。

1. 强化学习的基本概念强化学习问题通常被建模为马尔可夫决策过程(Markov Decision Process, MDP)智能体(Agent):学习的主体,比如机器人、自动驾驶汽车、游戏 AI 等。环境(Environment):智能体所处的世界,它可以是物理环境(现实世界)或虚拟环境(游戏、金融市场等)。状态(State, S):描述环境当前的情况。例如,在自动驾驶中,状态可能包括道路状况、速

微调(Fine-tuning)是指在预训练模型的基础上,通过进一步训练模型的全部或部分参数,使其适应特定的下游任务或数据集的过程。微调通常用于自然语言处理(NLP)、计算机视觉(CV)等领域的深度学习模型。

Reinforcement Learning: An Introduction》(第二版)由Richard S. Sutton和Andrew G. Barto合著,是强化学习领域的经典教材,系统性地介绍了强化学习的基础理论、算法及应用。该书是强化学习领域的“圣经”,为后续研究(如PPO、SAC等算法)奠定了理论基础。第二版新增了深度强化学习等内容,更贴合现代发展。

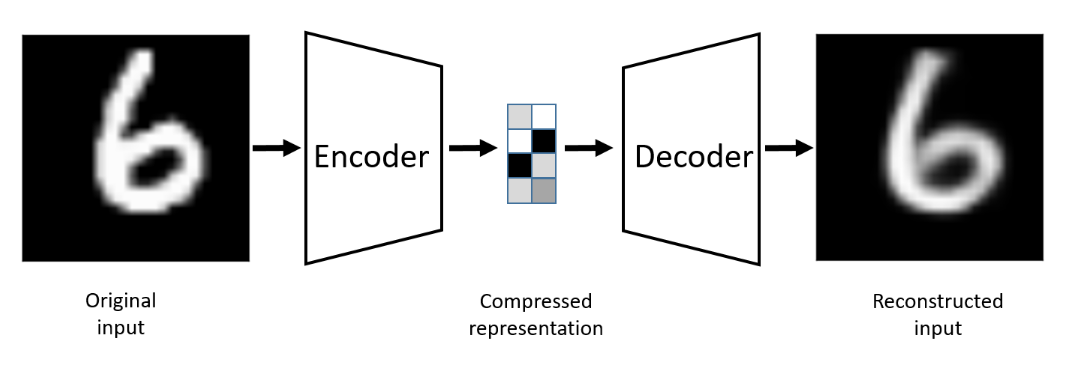

自编码器(Autoencoder)是一种无监督学习算法,主要用于数据的降维、特征提取和数据重建。自编码器由两个主要部分组成:编码器(Encoder)和解码器(Decoder)。其基本思想是将输入数据映射到一个低维的潜在空间,然后再从该潜在空间重建出原始数据。

卷积层不仅仅是在做数学运算,它通过这种独特的操作实现了几个至关重要的目的,这些是CNN成功的关键。作用描述带来的好处特征提取使用卷积核作为探测器,从输入数据中提取有意义的局部模式(从边缘到物体部件)。让网络能够“看到”图像中的内容,而不仅仅是像素值。参数共享同一个卷积核在输入的不同区域共享权重。大大减少参数量,降低过拟合风险,提高计算效率。平移不变性由于参数共享,网络能够识别出现在图像任何位置的相

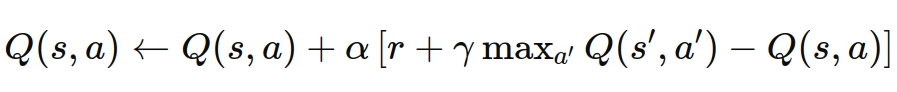

Q学习(Q-Learning)是一种基于值的强化学习算法,用于在给定状态下选择动作,以最大化累积奖励。它通过不断更新一个称为Q表(Q-table)的表来学习动作的价值。

虽然不是机器学习的“基本类型”,但这些方法在现代 AI 发展中起到了重要作用,属于。,如迁移学习、自监督学习、在线学习、联邦学习等,它们通常被视为机器学习的。随着深度学习的发展,出现了一些新的。机器学习的方法主要可以分为。

GPT是一种基于Transformer架构的生成式预训练语言模型,依靠大规模的数据训练,能够生成高质量的自然语言文本。随着版本的迭代,GPT在任务泛化能力、少样本学习、文本生成质量等方面取得了显著进展。尽管其在推理能力和偏见问题上仍有改进空间,但其广泛的应用场景已经使其成为自然语言处理领域的核心技术之一。