简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

网络安全常见的“黑话”来咯~

Wireshark是一个网络封包分析软件。网络封包分析软件的功能是撷取网络封包,并尽可能显示出最为详细的网络封包资料。Wireshark使用WinPCAP作为接口,直接与网卡进行数据报文交换。

很多小伙伴,他们在完成学习以后都会有一个困惑,求职时如何去准备才能在最短的时间内,找到一份好工作。

本文介绍由微软官方制作的面向初学者的 AI Agents 入门课程:microsoft/ai-agents-for-beginners。

书不仅配备了可直接运行的代码、清晰的技术发展时间轴,还附有核心论文索引,是理解大语言模型构建核心技术的宝贵指南。

前段时间,Meta 开源了 Llama 3.2 轻量化模型,为移动端跑大模型提供了新选择!同时,Llama 3.2 视觉模型(Llama 3.2 Vision)也正式开源,号称媲美 GPT-4o。前两天,Llama 3.2 Vision 已在 Ollama 上线!

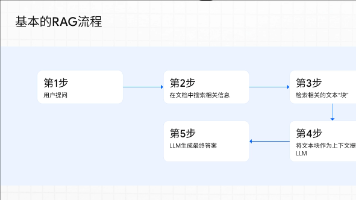

今天我们将深入探讨企业内部构建RAG的核心策略,循序渐进的实施路径,并分享在n8n平台上搭建RAG Q&A Agent应用案例和企业内部应用场景。

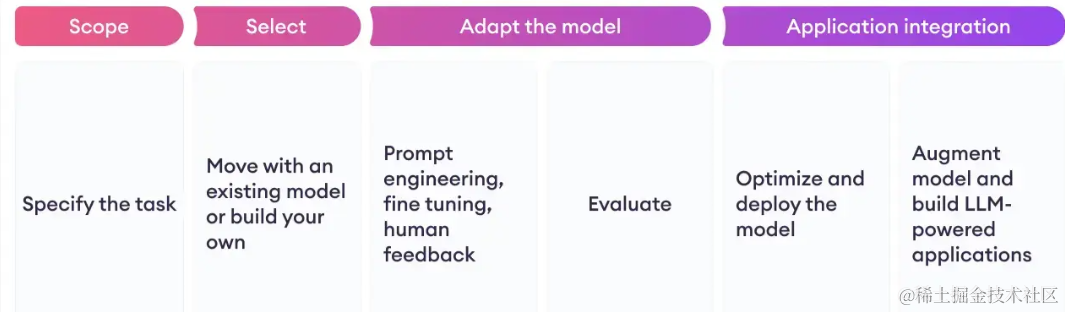

2024带你深入了解 大语言模型(LLM)微调方法(总结)

本书将系统性地介绍如何从零开始,基于RAG(Retrieval‑Augmented Generation,检索增强生成)技术,构建一个能够理解和利用个人知识库的智能聊天机器人,并将其无缝集成到你自己的网站或应用中。

在之前的,已经介绍了ollama在Windows环境下和Linux环境下的安装,在本篇中将重点介绍Ollama的常用配置