简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

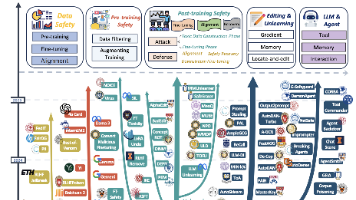

大型语言模型(LLMs)的卓越成功,为学术界和工业界开辟了一条迈向通用人工智能的光明路径,这得益于它们在各类应用中前所未有的性能表现。随着LLMs在研究和商业领域的影响力持续扩大,其安全与保障问题已成为研究人员、企业乃至各国政府日益关注的焦点。目前,现有的LLM安全综述主要聚焦于LLM生命周期的特定阶段(如部署阶段或微调阶段),缺乏对整个"生命链"的系统性理解。为填补这一空白,本文首次提出"全栈"

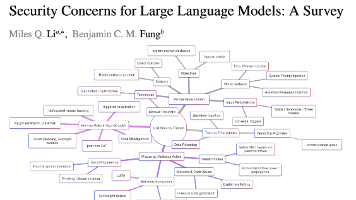

ChatGPT及其竞争产品等大语言模型(LLM)引发了自然语言处理领域的革命,但其强大能力也带来了新的安全漏洞。本综述对这些新兴问题进行了全面概述,将威胁分为以下几个关键领域:通过提示词操控实施的推理时攻击、训练时攻击、恶意行为者的滥用,以及自主LLM智能体的内在风险。近年来,学界对最后一类问题的关注度持续显著上升。本文梳理了2022年至2025年间具有代表性的学术与产业研究成果,分析了现有防御机

要点训练好了一个模型, 我们当然想要保存它, 留到下次要用的时候直接提取直接用, 这就是这节的内容啦. 我们用回归的神经网络举例实现保存提取.对整个网络保存我们快速地建造数据, 搭建网络:import torchfrom torch.autograd import Variableimport matplotlib.pyplot as plt#假数据# unsqueeze对数据维...

https://github.com/kennymckormick/mmaction2/commit/d7a61f7ed6fdd9326affe8d8bca04cd15610a931#diff-8d787d2a5a0df93e10821f9c88e263fcf970ffc69a5648d9ba7c4bbc4b92731b

arxiv:RoBERTa: A Robustly Optimized BERT Pretraining Approachpytorch官方实现:https://pytorch.org/hub/pytorch_fairseq_roberta/hugging face hfl chinese-roberta-wwm-ext:https://huggingface.co/hfl/chinese-rob

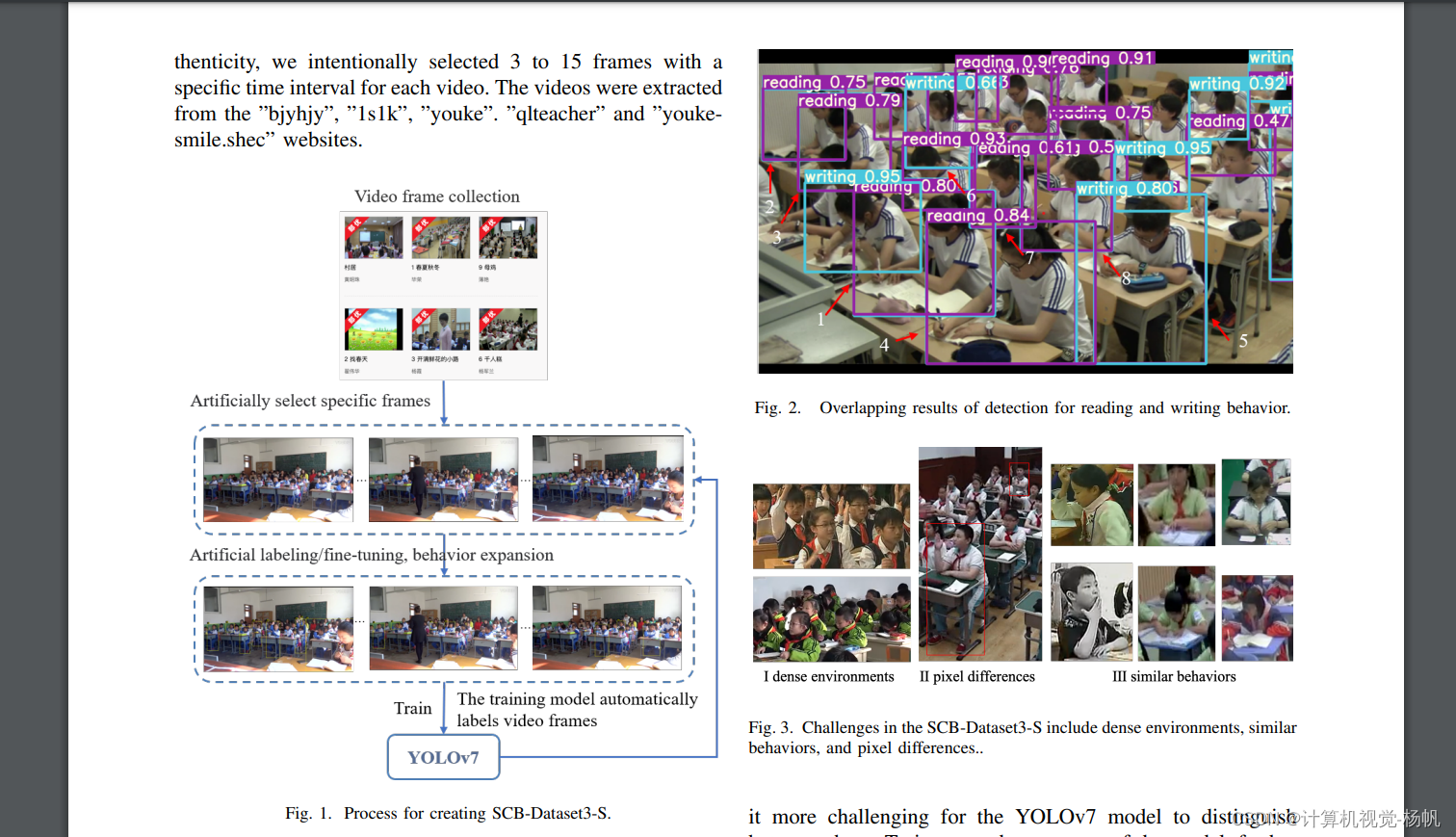

前言马上开题报告啦,前段时间还在做机械臂的领域的抓取,但是由于项目被其它学校抢走了,我被迫转移到教育行业的行为检测。我已经进入行为检测这个领域一周了吧,发现网上的博客还是有很多不完善的,今天我就来对行为检测的数据集进行剖析。官网http://activity-net.org/index.html可以看出这个数据量是非常庞大的,600多个小时,估计我这个普通的500G电脑是难以装下的。在官网进入下载

公开 学生课堂行为数据集 SCB-Dataset3: A Benchmark for Detecting Student Classroom Behavior

pytorch 池化层——最大值池化nn.MaxPool 2dnn.MaxPool1d nn.MaxPool1d函数参数例子计算过程nn.MaxPool2d函数参数例子计算过程nn.MaxPool1d函数class torch.nn.MaxPool1d(kernel_size, stride=None, padding=0, dilation=1, return_indices=False,...

公开 学生课堂行为数据集SCB-Dataset Student Classroom Behavior dataset

ava数据集可视化B站视频:https://www.bilibili.com/video/BV1yL411c7pR?spm_id_from=333.999.0.0前言这个训练的跟踪过程使用的数据集是缩小版的,我只去了ava数据集中的2个视频,2个视频加起来也有30分钟,这个也不小了。1 mmaction2 安装1.1 安装在AI平台中选择如下版本镜像:安装命令如下:cd homegit clone