简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

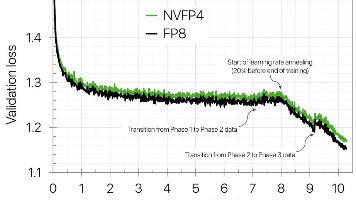

NVIDIA提出了一种基于NVFP4格式的大语言模型预训练新方法,该方法通过整合随机哈达玛变换、二维量化方案、随机舍入和选择性高精度层等技术,实现了4位精度的稳定训练。研究团队在10万亿tokens上成功训练了一个120亿参数的混合Mamba-Transformer模型,其训练损失和下游任务准确率与FP8基线模型相当(MMLU-pro准确率62.58% vs 62.62%)。相比MXFP4格式,N

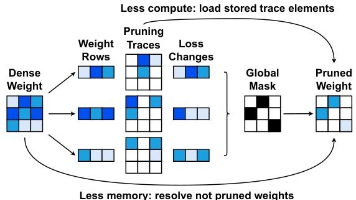

本文提出了一种名为"最优脑压缩"(OBC)的新型训练后神经网络压缩框架,能够高效统一地处理权重剪枝和量化问题。该框架基于经典最优脑外科医生(OBS)方法,通过创新算法将其计算复杂度从O(d⁴)降低到O(d·d_col²),使其适用于现代大规模神经网络。实验表明,OBC在图像分类、目标检测和语言建模任务中显著优于现有训练后方法,并能实现剪枝与量化的复合压缩。例如,在GPU上实现1

本文提出BiLLM,一种针对预训练大语言模型(LLMs)的高效1位训练后量化方法。通过分析LLM权重的钟形分布和海森矩阵特性,BiLLM采用双路径策略:对显著权重进行结构化筛选与残差逼近二值化,最小化量化误差;对非显著权重通过最优分割搜索分组二值化,适应其分布特征。实验表明,BiLLM在OPT、LLaMA等模型家族上仅需1.08位平均权重比特宽度(如LLaMA2-70B困惑度8.41),显著优于现

男性因素不育占不育病例的比例高达 40%¹,其中无精子症和隐匿精子症(以射精液中无精子或精子极为罕见为特征的疾病)约占这些病例的 10%-15%²。对于受影响的夫妇而言,诊断和治疗往往涉及多年反复失败的干预措施、侵入性操作以及情感困扰。常规治疗方案通常包括睾丸精子提取术 ³,或由专业胚胎学家进行长时间的人工精子搜寻,随后进行卵胞浆内单精子注射⁴。

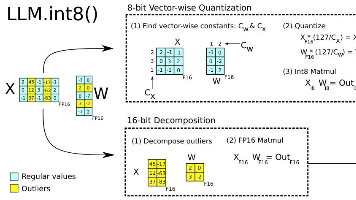

本文提出了一种名为LLM.int8()的8位整数量化方法,可在不损失性能的前提下,将大型语言模型的内存占用减少一半。该方法通过向量级量化和混合精度分解技术,有效处理了Transformer模型中系统性涌现的大振幅异常值特征(仅占0.1%但主导模型性能)。实验表明,该方法适用于高达1750亿参数的模型,使OPT-175B/BLOOM等超大模型能在消费级GPU上运行。研究揭示了模型规模与异常值特征涌现

继续微调数据集问题代码中使用的数据集是示例idimagesvideo link600047611331100254611311200050522231本地数据集解析与对应关系在本地文件中:这里的test-xxx.parquet里面封装的就是数据集的prompt还有一些文本信息,不过是以二进制形式存储的,所以直接打开看不懂。对应着frames_real_test里面的80个文件夹。

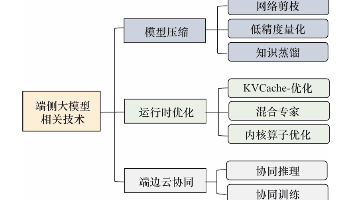

近年来,大语言模型技术在多个领域取得了突破性进展,为实现泛在智能提供了坚实的基础。然而,泛在智能要求在各种场景中实现无缝的智能体验,这对大语言模型的部署和应用提出了新的挑战。云上部署大模型时,面临实时性、安全性和个性化需求难以兼顾的问题,限制了其在不同环境中的适用性。这些挑战促使研究者探索端侧部署大语言模型的前景,以期在更接近数据源的位置实现更高效的智能服务。然而,端侧的资源限制为大语言模型的部署

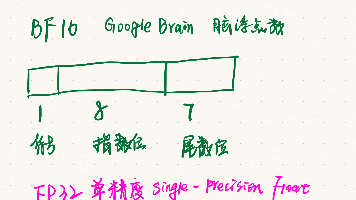

FP16和BF16是两种16位浮点数格式,用于深度学习以节省计算资源。FP16(5位指数+10位尾数)节省显存但易数值溢出,适合推理;BF16(8位指数+7位尾数)动态范围接近FP32,更适合训练,尤其在大模型中。微调大模型时,优先选择BF16(硬件支持前提下),因其稳定性更高;若硬件不支持,可用FP16配合混合精度技术(FP16计算+FP32主权重更新)。混合精度通过损失缩放和梯度裁剪避免FP1

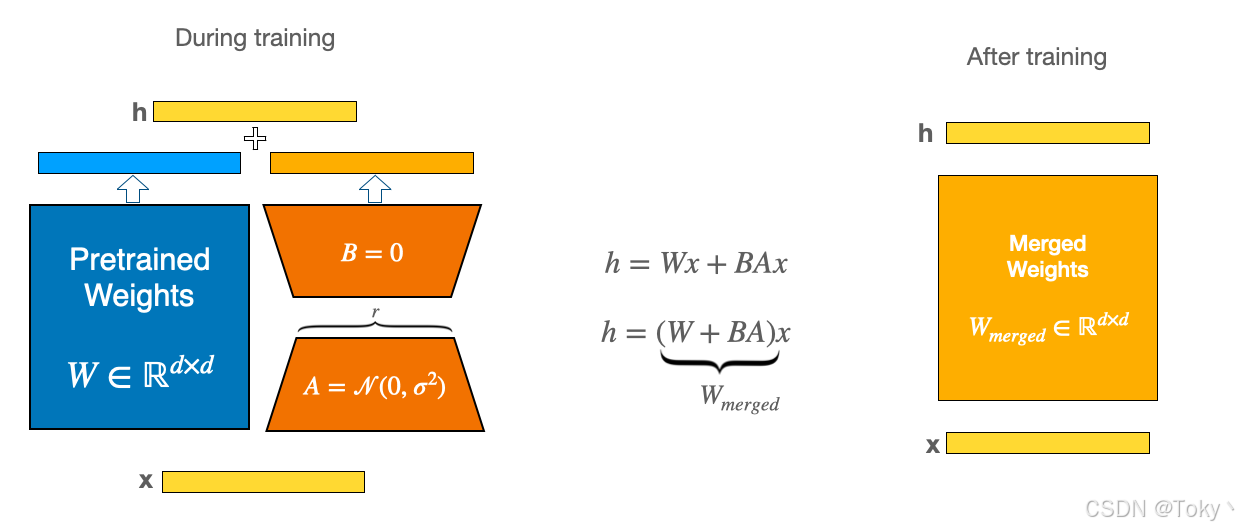

在大语言模型(LLMs)的训练领域,Low Rank Adaptation(LoRA)技术堪称一项重大突破。它就像给模型训练开启了一条 “高速通道”,让我们能更高效地为特定任务训练大语言模型。如今,LoRA在众多应用场景中广泛使用,并且引发了一系列改进研究,催生出了许多变体,这些变体从不同角度优化LoRA,提升训练速度、性能,或者两者兼得。今天,咱们就来深入了解一下LoRA及其家族成员的奥秘。

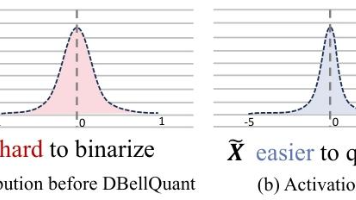

摘要:本文提出DBellQuant框架,通过创新的双钟形可学习变换(LTDB)算法实现大语言模型(LLM)的高效训练后量化。该方法将单钟形权重分布转换为更适配二值化的双钟形分布,同时通过逆变换平滑激活值异常值。实验表明,DBellQuant在保持模型性能的同时,首次实现近1位权重压缩与6位激活量化。在LLaMA2-13B等模型上,其困惑度(14.39)显著优于现有方法(21.35),为LLM的高效