简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文详细介绍了LangChain中的Vector Stores(向量存储)组件,这是RAG(检索增强生成)架构的核心部分。文章首先解释了为什么RAG需要Vector Stores来解决大模型的三大痛点:上下文窗口有限、知识无法实时更新和语义理解落地问题。然后阐述了LangChain Vector Stores的核心特性,包括统一接口、多嵌入模型支持、相似性度量和元数据过滤等功能。接着详细说明了Ve

本文全面解析LangChain文档加载器的类型及使用方法。文档加载是LangChain开发的基础环节,主要分为5大类:本地文件格式(如PDF、Word、Excel)、网页/网络资源、云服务/远程存储、数据库以及特殊类型文件(音频、代码等)。文章提供了详细的实操教程,包括安装核心依赖和具体加载示例,如TXT、PDF、Word和CSV/Excel文件的加载方法,帮助开发者快速掌握不同数据源的文档加载技

摘要:LangChain的History模块为对话式AI提供会话记忆管理功能,支持临时和长期两种存储方式。临时会话通过RunnableWithMessageHistory和InMemoryChatMessageHistory实现内存级存储,适用于单次对话;长期会话使用FileChatMessageHistory进行文件持久化,并可继承BaseChatMessageHistory自定义数据库等存储方

LangChain核心组件数据流解析 本文系统梳理了LangChain三大核心组件的输入输出格式,帮助开发者理解数据流逻辑: Prompt模板:将动态参数转化为模型可识别格式 PromptTemplate:基础文本模板,输出纯字符串 FewShotTemplate:带示例模板,输出含示例的完整提示词 ChatPromptTemplate:对话模板,输出BaseMessage列表 Model模型:执

在大语言模型(LLM)应用落地过程中,“幻觉输出”和“知识滞后”是两大核心痛点。检索增强生成(Retrieval-Augmented Generation, RAG)通过将LLM与外部知识库联动,让模型基于真实、最新的数据生成回答,成为解决这两个问题的主流方案。而LangChain作为LLM应用开发的“瑞士军刀”,凭借其灵活的组件化设计,能快速实现从原型到生产级RAG系统的落地。本文将从核心原理出

📚 Academic Pages 学术网站模板 核心功能 基于 Jekyll + GitHub Pages 的学术网站解决方案 提供论文展示、项目介绍、教学经历等模块 支持响应式设计和多终端适配 部署方式 GitHub Pages 自动部署(推荐) 使用模板创建仓库 自动构建发布 本地Jekyll环境 需安装Ruby、Node.js等依赖 Docker容器 跨平台一键部署 VS Code Dev

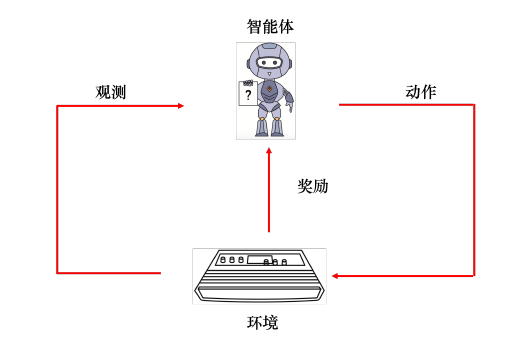

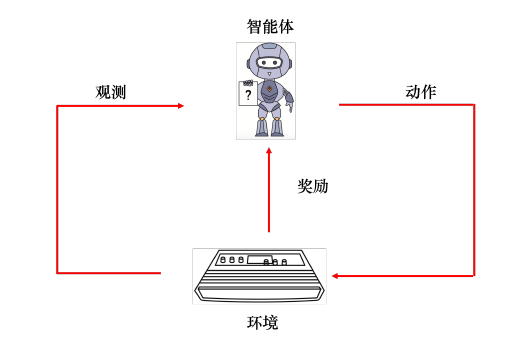

Q-learning 是一种无模型的强化学习算法,用于寻找最优策略以最大化累积奖励。它通过学习一个状态-动作值函数Qsa,该函数表示在状态 ( s ) 下执行动作 ( a ) 的预期收益。

《ClaudeCode常用指令指南》摘要: 本文系统介绍了ClaudeCode交互式会话中的核心命令与使用技巧。通过20余种斜杠命令可完成对话管理、配置修改、代码审查等操作,包括/clear清空历史、/review请求代码审查、/model切换AI模型等。特别提供了"深度思考"触发词、Bash命令行模式、记忆模式等进阶技巧,并支持文件引用、图片读取等功能。用户可通过/help获

Q-learning 是一种无模型的强化学习算法,用于寻找最优策略以最大化累积奖励。它通过学习一个状态-动作值函数Qsa,该函数表示在状态 ( s ) 下执行动作 ( a ) 的预期收益。