简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

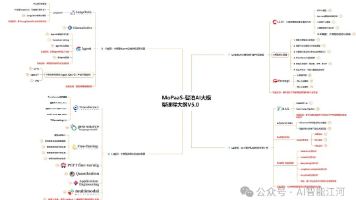

本文基于2025年最新行业实践,构建了一条从基础概念到实战开发,再到模型训练与商业应用的完整学习路线,帮助学习者循序渐进地掌握大模型技术的核心与前沿。

LangChain:是现在最流行围绕大语言模型构建的框架,可用于聊天机器人、生成式问答 (GQA)、摘要等。

LangChain:是现在最流行围绕大语言模型构建的框架,可用于聊天机器人、生成式问答 (GQA)、摘要等。

LLaMA 3-Chinese 是 LLaMA 3 系列中一个专门针对中文进行优化的版本。这个版本的模型在大量中文文本上进行训练,因此在中文文本生成、理解和对话等任务上表现优异。

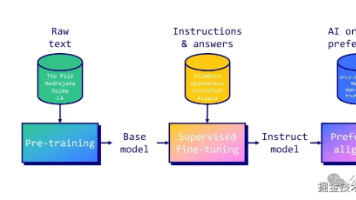

大模型的训练目前主要分为Pre-training和Post-training,受限于资源算力等原因,实际工作中更多用到的是SFT。

最近发现了一份巨牛逼的资源,这个资料是哥伦比亚大学的机器学习博士,把分散在全网各个角落的高质量资源聚拢在一起,梳理出的超清晰的 GenAl学习路径!!

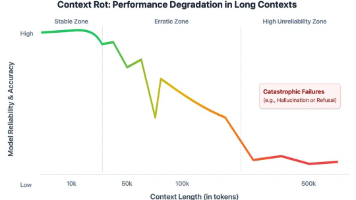

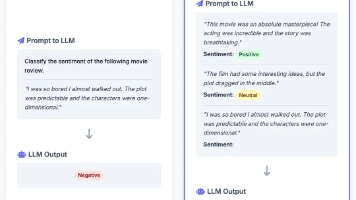

本文将带你回顾这一转变的历程:从简单提示词到丰富且动态的上下文结构。我们将探讨提示词工程中曾经奏效的核心技巧,分析它所面临的局限性,并介绍一门新的关键技术——上下文工程(Context Engineering)。

别急!耗时一周为大家整理了一份AI学习保姆级规划,帮你避开那些常见的新手陷阱~

打开招聘软件看看,30K 以上的高薪岗位,有多少还只是纯粹的后端开发?AI Copilot 已经能帮你写大部分基础代码了,你的核心竞争力还剩多少?

在上一篇文章中,我们聊了从提示词工程到上下文工程的发展过程,看到了大语言模型交互方式的逐步演化。