简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

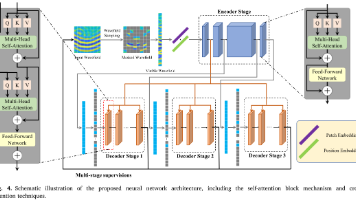

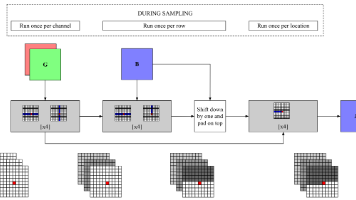

轴向变压器(Axial Transformer),一种高效处理高维数据的自回归模型。针对标准自注意力在图像等数据上计算复杂度高的问题,该方法通过沿单个轴进行注意力计算,将复杂度从O(N²)降至O(N^(3/2))。模型采用三阶段架构:通道编码器、外部解码器和内部解码器,支持半并行采样以加速生成过程。实验表明,该方法在ImageNet图像生成和BAIR视频基准上均达到SOTA性能,同时保持实现简单和

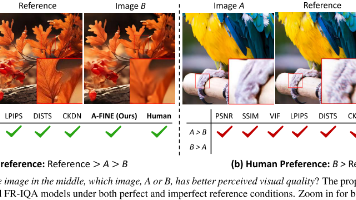

一种广义全参考图像质量评估模型A-FINE,突破了传统方法依赖完美参考图像的局限。通过构建包含18万张图像的DiffIQA数据集,并设计自适应权重机制平衡保真度和自然度,A-FINE在标准测试集和新构建的SRIQA-Bench上均显著优于传统方法。实验表明,当测试图像质量优于参考图像时,A-FINE准确率达82.3%,而传统方法仅约20%。该研究为生成式AI时代的图像质量评估提供了新范式,具有重要

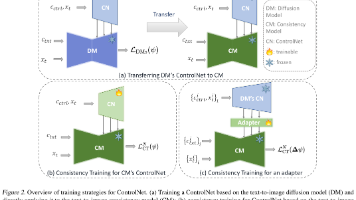

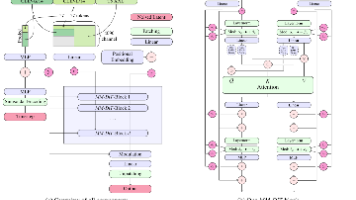

CCM框架,首次实现了基于一致性模型(CMs)的实时可控图像生成。研究探索了三种控制策略:直接迁移扩散模型ControlNet、一致性训练定制ControlNet和统一适配器方法。实验表明,定制训练的CM ControlNet在4步生成时达到0.9秒/图(加速26倍),FID仅7.61,接近扩散模型质量。关键发现包括:1)CMs可作为独立生成模型;2)模型间存在语义层一致但细节层差异;3)适配器能

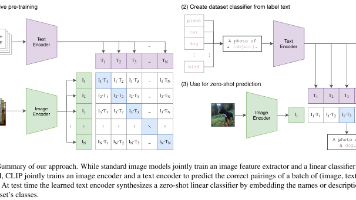

本文介绍了OpenAI提出的CLIP(Contrastive Language-Image Pre-training)模型,这是一种通过自然语言监督学习可迁移视觉模型的新方法。CLIP利用互联网上的4亿图文对进行训练,采用对比学习框架连接图像和文本表示,实现了强大的零样本迁移能力。实验表明,CLIP在30多个计算机视觉任务上表现出色,在ImageNet零样本任务中达到了与全监督ResNet-50相

RectifiedFlow生成模型及创新的MM-DiT架构,用于高分辨率图像合成。通过优化时间步采样策略和引入双向信息流的多模态Transformer,该方法在文本到图像生成任务中展现出卓越性能。大规模实验表明,8B参数模型在多项指标上超越DALL-E3等现有技术,并验证了模型扩展的规律性。该工作不仅提供了统一的扩散模型理论框架,其开源承诺也将推动生成式AI的发展。

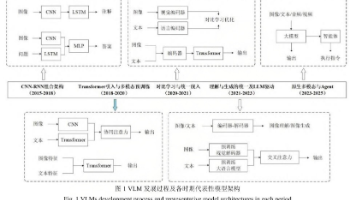

系统综述了视觉语言模型(VLM)的技术发展历程与核心架构。研究将VLM演进划分为四个阶段:2015-2018年的CNN-RNN组合架构、2018-2021年的Transformer统一架构、2020-2021年的对比学习爆发期,以及2021年至今的LLM驱动时代。文章深入剖析了VLM三大核心组件(视觉编码器、语言编码器和跨模态融合机制)及关键预训练技术(掩码建模、对比学习),并分析了主流数据集对模

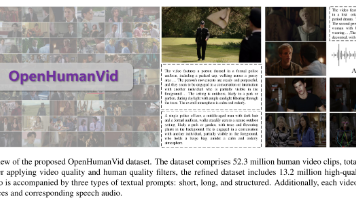

OpenHumanVid是一个大规模、高质量的以人为中心的视频数据集,旨在解决现有视频生成模型在人物表现上的不足。该数据集包含13.2百万高质量视频片段,配备多模态标注,如详细文本描述、骨骼序列和语音音频,并强调文本与人物外观、动作及表情的精准对齐。通过实验验证,基于此数据集训练的模型显著提升了生成视频的人物一致性和动作自然度,同时保持通用视频生成性能。研究证明,数据规模、质量和多模态对齐对提升人

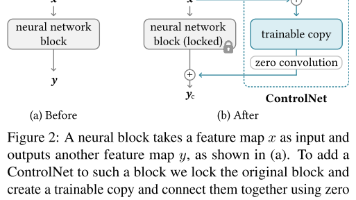

ControlNet:为文本到图像扩散模型添加精确空间控制 本文提出ControlNet神经网络架构,通过在预训练文本到图像扩散模型(如Stable Diffusion)中添加空间条件控制来解决生成图像空间布局难以精确控制的问题。该方法通过锁定原模型参数并复制编码器,采用零初始化卷积层连接可训练副本,实现了安全稳定的微调过程。ControlNet支持多种条件输入(边缘图、深度图、人体姿势等),既能

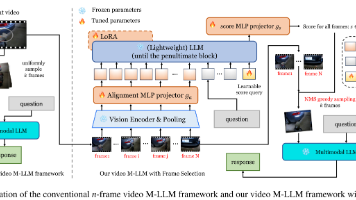

本文提出了一种基于多模态大语言模型(M-LLM)的自适应视频帧选择方法,以提高视频理解效率。针对现有均匀采样方法可能导致关键帧丢失的问题,该方法通过轻量级帧选择器,结合空间和时间双重监督信号,智能选取与问题相关的视频帧。实验表明,该方法在中长视频问答任务上显著提升性能(最高+3.7%),并能用更少帧数达到更好效果(4帧接近32帧的均匀采样效果)。核心创新在于问题导向的帧选择策略,仅需1.5B参数即

一种基于深度学习的空间梯度重建方法,用于高效识别高稀疏Lamb波场复合材料损伤。针对碳纤维增强塑料(CFRP)中肉眼难以察觉的分层损伤,以及扫描激光多普勒测振仪(SLDV)测量耗时的问题,该方法通过新型空间梯度损伤指标和神经网络技术实现了显著改进。采用交叉注意技术将浅层特征直接注入解码器,增强异常检测能力,并集成多重建层指导波场重建过程。实验表明,该方法重建精度较现有技术大幅提升,单损伤情况下从7