简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

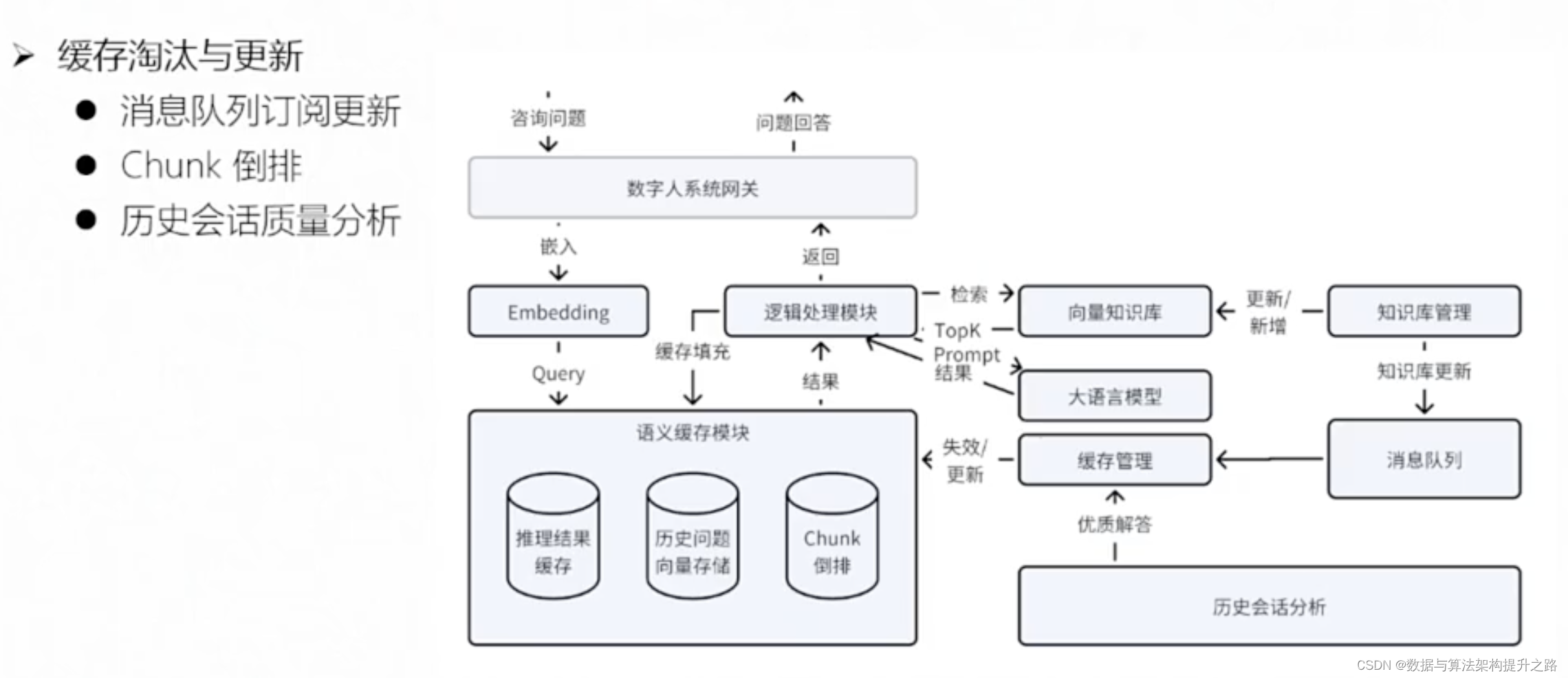

GPTCache项目通过语义缓存LLM响应,有效降低高流量下API调用成本和提高响应速度。项目提供从初始化到集成的详细步骤,支持自定义嵌入函数、数据管理器和相似度评估,优化了长序列处理和多轮对话的效率。此外,介绍了KV Cache在GPT2中的应用,展示了其在Transformer模型中的关键作用,通过缓存Key和Value状态减少计算量,加速模型推理。

Ray框架介绍Ray框架介绍Ray 是一个开源分布式计算框架,在 机器学习基础设施中发挥着至关重要的作用。Ray 促进分布式机器学习训练,使机器学习从业者能够有效利用多个 GPU 的能力。Ray可以在集群上分布式地运行任务,并且可以指定任务运行时需要使用的GPU数量。

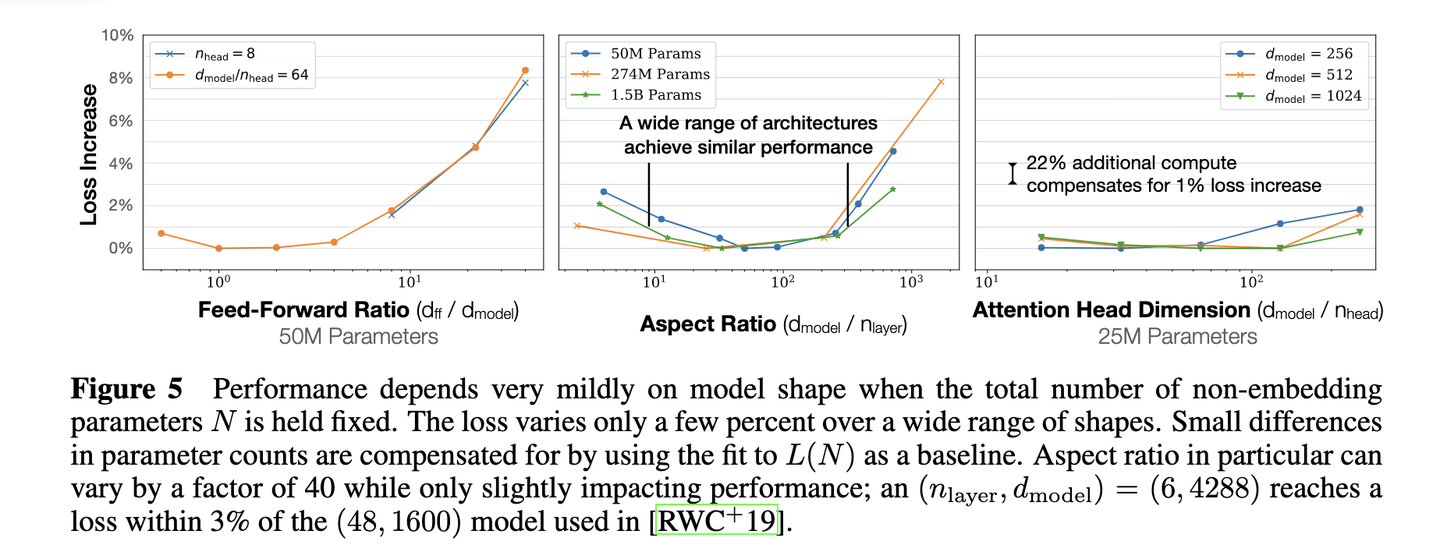

Scaling Law为大模型训练提供了计算量、参数量和数据量之间的量化关系。LLaMA模型的出现,可能颠覆了这一定律,展现出在较低资源消耗下的高性能,为大模型的效率和性能平衡开辟了新路径

DeepSeek-V3 是一款性能卓越的开源语言模型,具有 671 亿参数和 37 亿激活参数,采用混合专家 (MoE) 架构,训练数据量达 14.8 万亿 token。其在数学、代码生成、长文本处理等多个领域表现出色,与顶级闭源模型如 GPT-4o 相当。DeepSeek-V3 的训练成本低,仅需 558 万美元,且生成速度从 20 TPS 提升至 60 TPS。

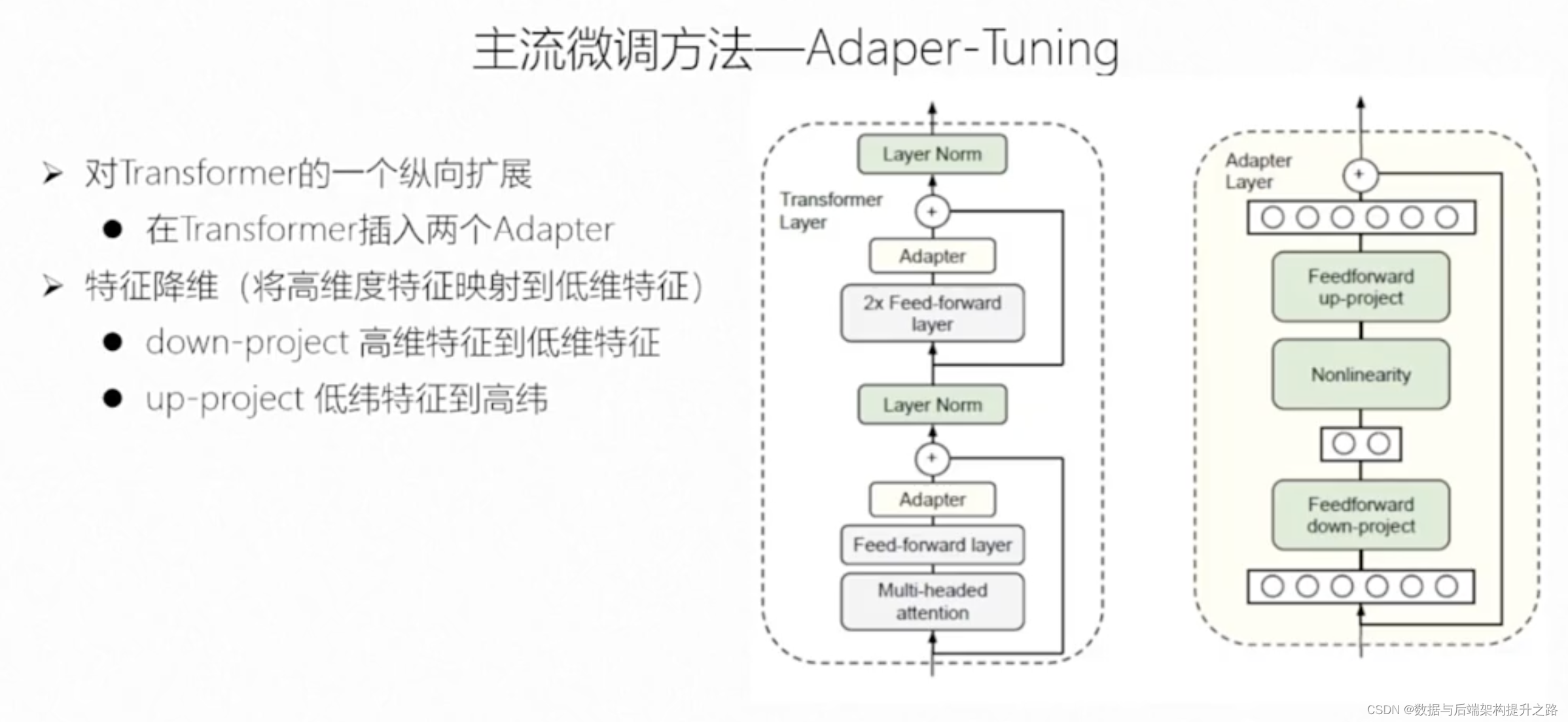

本文介绍了自然语言处理中的微调技术,包括全量微调和部分参数微调。全量微调基于大规模预训练模型,通过调整学习率、损失函数等设置,对特定任务进行训练。部分参数微调如Adapter-Tuning和Prefix-Tuning,通过引入少量可训练参数,减少训练成本,快速适应新任务。同时提及了LoRA和P-Tuning技术,以及如何使用Hugging Face的transformers库进行BERT模型的微调

本文深入探讨了大型语言模型(LLM)产生「幻觉」现象的原因,包括数据偏差、过度泛化和上下文理解不足,并提出了针对性的解决策略,如改进训练数据、模型微调和上下文增强等,以期提升模型的准确性和可靠性。

通过CLIPSpy规则引擎与机器学习的深度结合,算法驱动的场景识别系统将继续在智能交通、自动驾驶和交通安全等领域发挥关键作用,推动智能交通系统的快速发展。

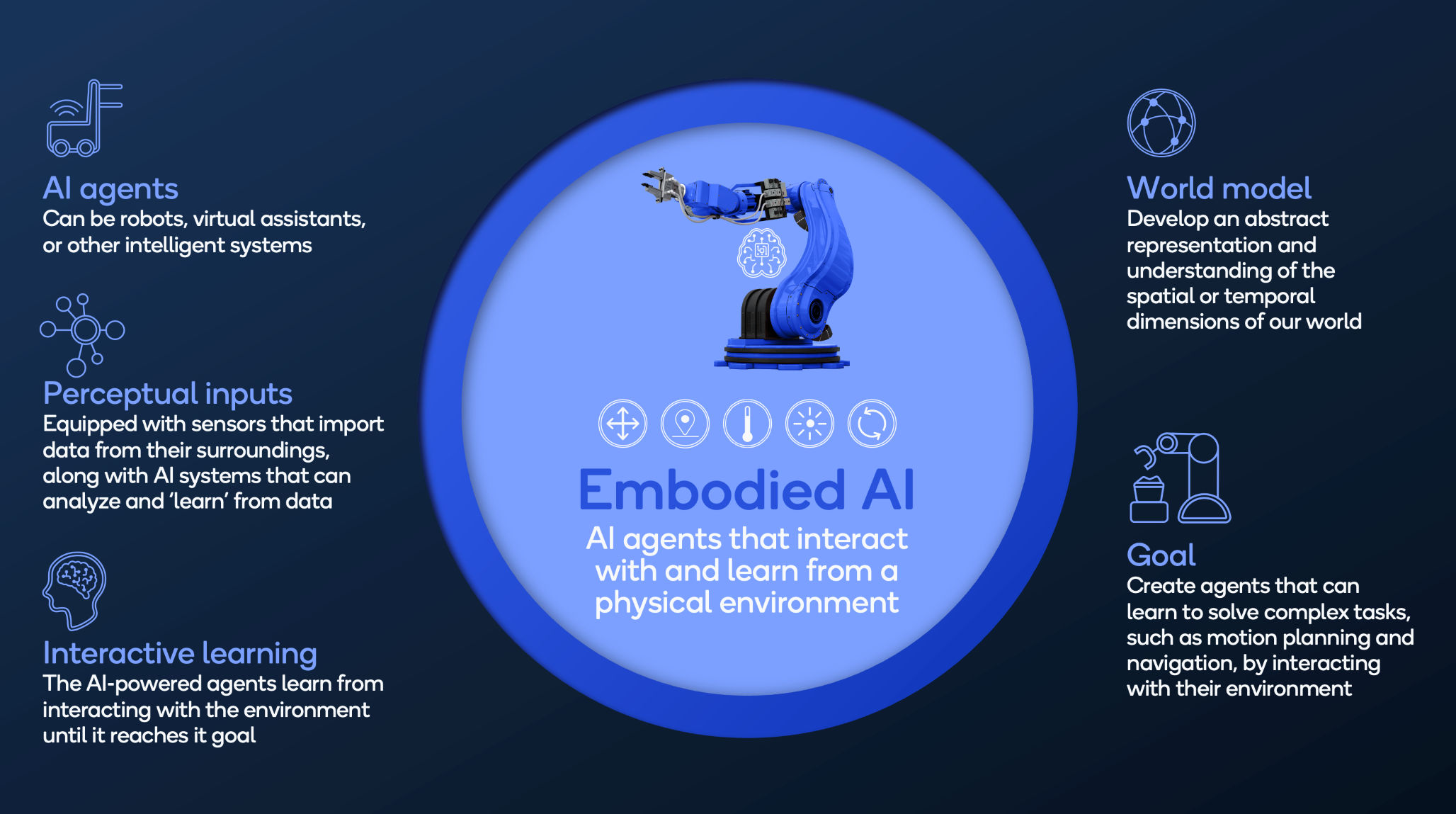

高通人工智能研究院开发了一种名为“几何代数变换器”(GATr)的数据高效架构模型,用于改善机器人对环境的感知,具有几何代数表示、等变层和Transformer架构,即使在少量数据下也能实现高性能,有望推动具身人工智能在制造业、医疗保健等领域的应用。

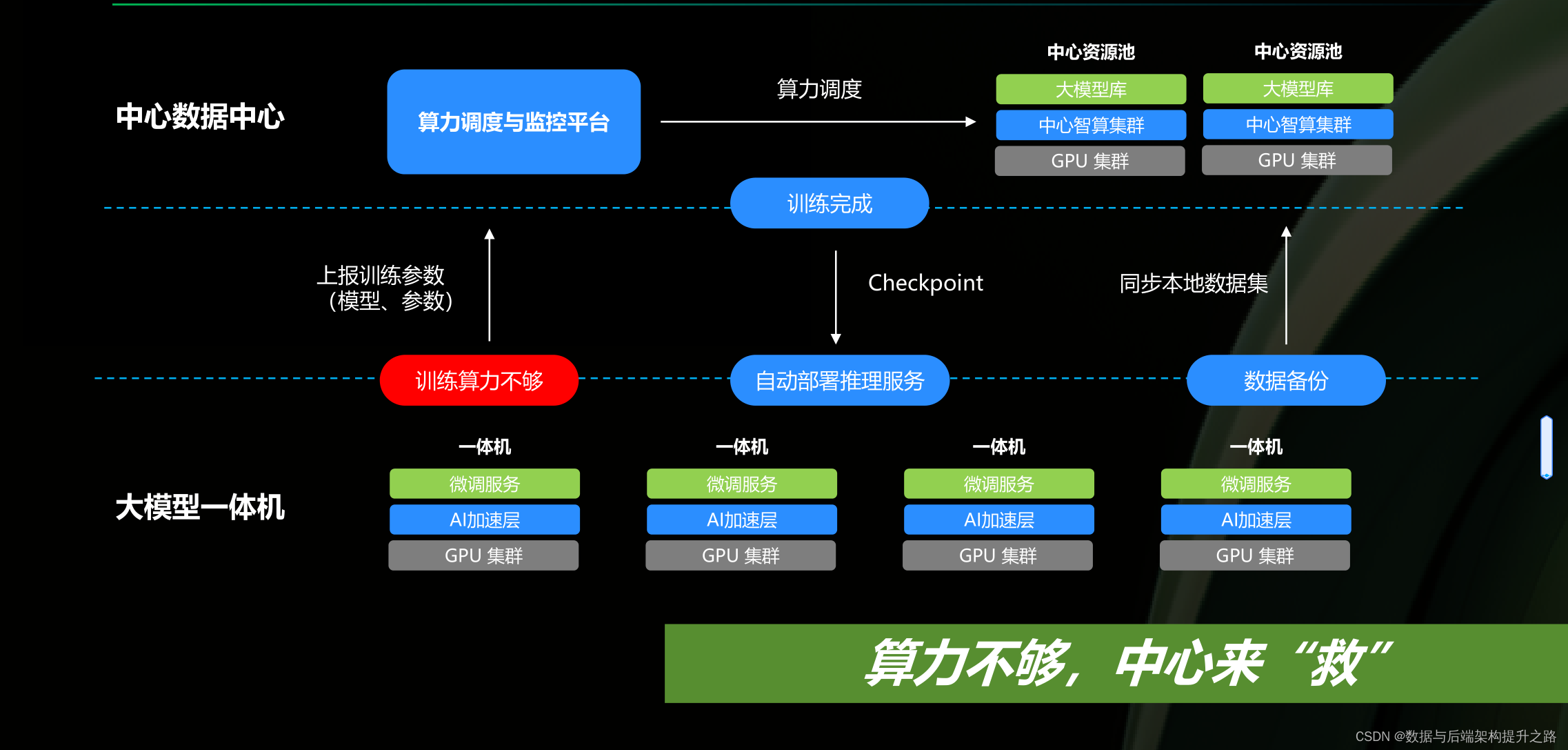

本文指导如何为AI模型选择硬件,涵盖GPU资源平台、硬件配置策略,分析显卡选择,考虑国际政治影响,展望国产AI芯片未来。

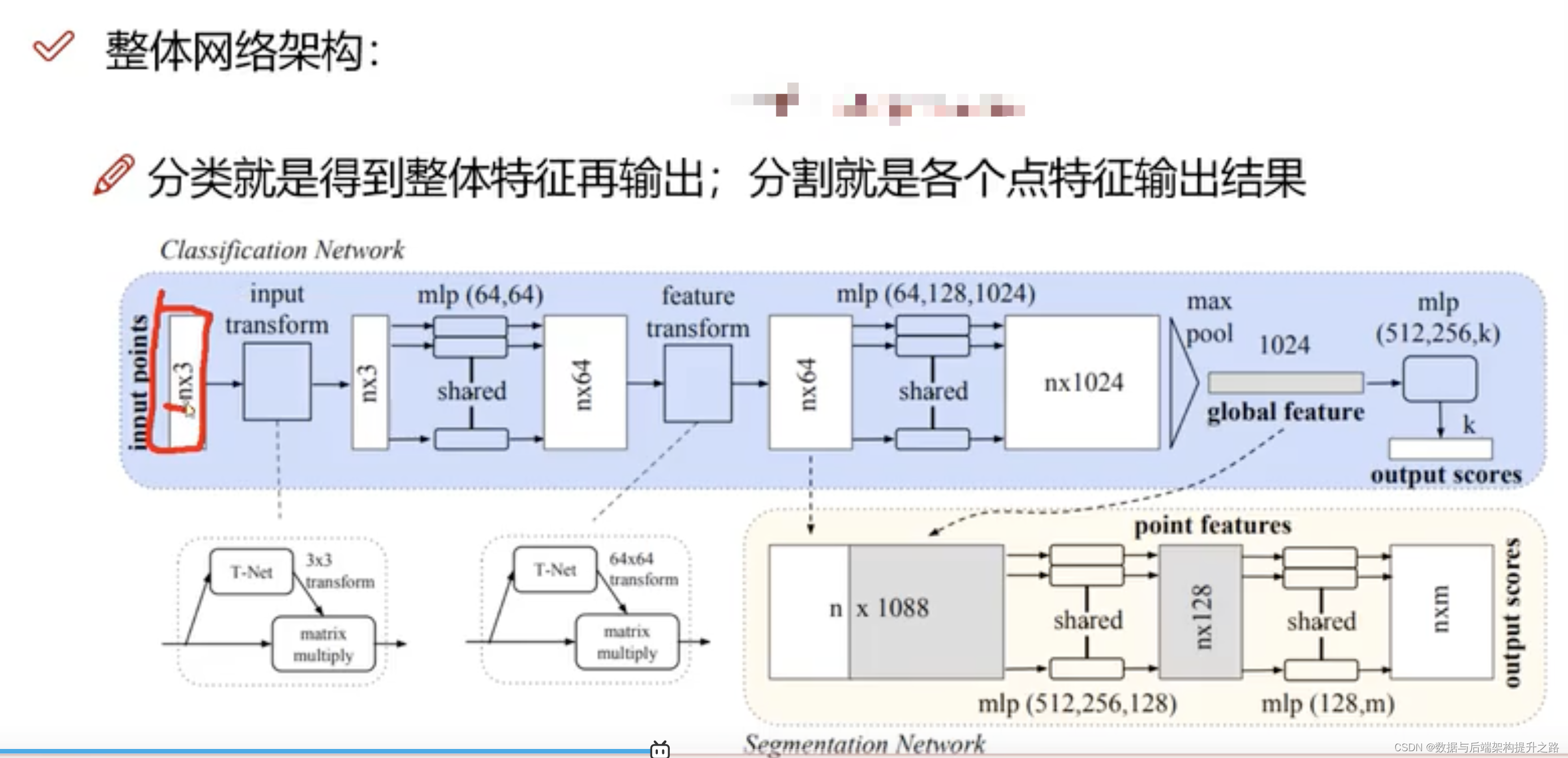

本文深入探讨了点云数据处理的关键技术,包括数据清洗、降噪、简化、配准等预处理步骤,为后续的SLAM和语义分割任务奠定基础。特别地,文章详细介绍了PointNet和PointNet++这两个先进的深度学习算法,它们能够有效处理无序点云数据并提取特征。此外,还探讨了三维重建中的NeuralRecon系统,它采用多尺度方法和GRU网络来优化三维结构的生成。文章强调了这些技术的优点和面临的挑战,展望了在三