简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

提取视频图像是一个常见需求,ffmpeg 是一个强大的工具,但可能并不是使用最简单的工具,并且需要编译安装,对于非技术人员来说比较繁琐。

您有一个 SQLite3 数据库表,其中包含各种页面的代码,包括标题、右菜单、内容等。编写一个中间件,在发生 404 错误时,检查数据库中是否有与请求的 URL 匹配的页面。您可以创建自己的模型来存储页面内容,并使用视图函数来处理 URL 请求。当网站包含大量页面时,这种方法需要大量的手动编码,不利于网站的维护和扩展。文件中,使用正则表达式来匹配 URL,并将匹配结果传递给视图函数。在视图函数中,

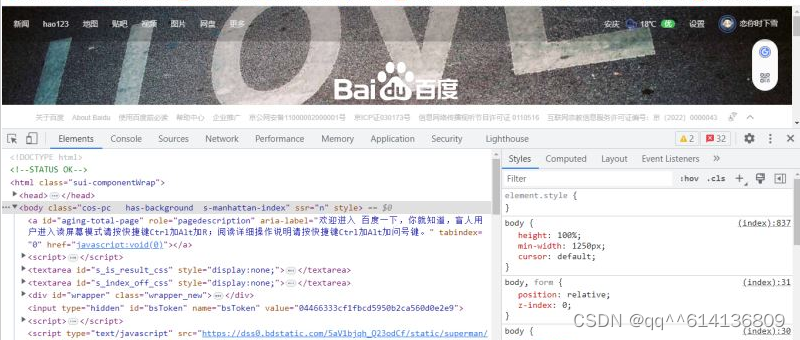

比如,对于一个登录表单,输人用户名和密码后,点击“登录”按钮,这通常会发起一个 POST请求,其数据通常以表单的形式传输,而不会体现在URL中。一般来说,登录时,需要提交用户名和密码,其中包含了敏感信息,使用GET方式请求的话,密码就会暴露在URL里面,造成密码泄露,所以这里最好以POST方式发送。了解了这些内容,有助于我们进一步了解爬虫的基本原理。GET请求中的参数包含在URL里面,数据可以在U

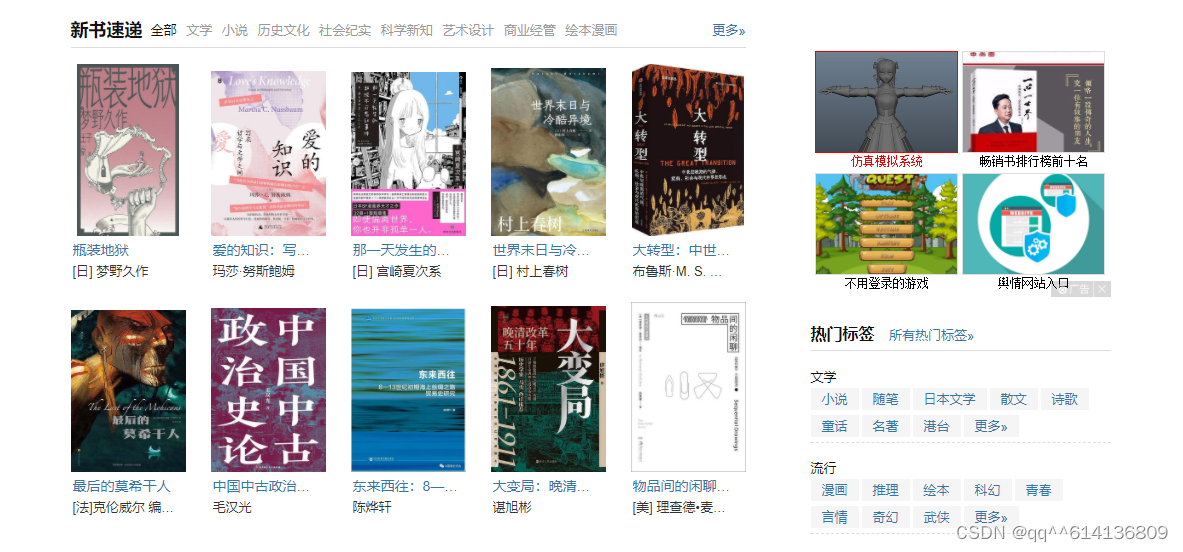

对于免费图书网站的采集程序,您可以使用Python和一些相关的库来实现。

比如,BeautifulSoup、lxml、requests等库提供了方便的HTML解析、网络请求等功能,Scrapy框架提供了高效的爬虫框架,Selenium库用于处理动态网页等。通过使用Python的数据处理库(如Pandas、NumPy)和数据可视化库(如Matplotlib、Seaborn),可以方便地对爬取到的数据进行清洗、转换、分析和可视化。综上所述,Python具有简单易学、丰富的库

规则提取器:CrawlSpider提供了一些内置的规则提取器,如LinkExtractor和LxmlLinkExtractor,用于从页面中提取链接。CrawlSpider是Python中Scrapy框架提供的一个强大的爬虫类,它基于Spider类,提供了更多的功能和灵活性,用于创建可以自动跟踪链接并提取信息的爬虫。这些规则包括允许跟踪的链接、如何跟踪链接、如何提取信息等。链接跟踪:CrawlSp