简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

迁移学习的研究正在经历从方法层面的拓展,到理论体系的重构。无论是与大模型、多模态、联邦计算的结合,还是因果推断与元学习的引入,都显示出迁移学习不再是局部技术问题,而是与智能系统未来密切相关的核心议题。它不仅影响人工智能的研究路径,也将在金融、工业、教育等领域发挥决定性作用。

阿里巴巴国际站推出针对B2B外贸的垂直AI Agent——AI Mode,能拆解需求、分析商品、找供应商、计算指标,完成整个采购流程。不同于通用AI,它基于Accio引擎,专注贸易领域,将复杂跨境采购自动化,让不懂专业知识的小商贩也能参与全球贸易。这标志着AI从通用搜索向专业Agent转变,2025年将成为各领域被AI重塑的起点。

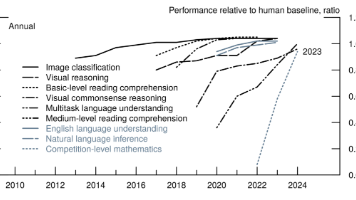

核心技术的持续创新是目前最明确的信号。生成式人工智能的性能正以惊人的速度提升,这不仅来自模型规模和训练数据的暴力扩展,更来自算法效率的根本性进步。研究人员在预训练、微调和推理阶段开发了众多新技术。例如,专家混合(MoE)架构和各类量化、剪枝技术,在保持模型性能的同时,极大降低了推理成本。DeepSeek R1等模型的出现,展示了以更低成本实现前沿性能的可能性。这场创新不仅发生在模型层面,也发生在硬

首推今年年初出版的《大模型应用开发极简入门:基于GPT-4和ChatGPT》,小红书上也有人叫它“章鱼书”(实际上是刺蛇尾Ophiothrix spiculata)。如果只读一本书,那么这本就是目前最全最容易上手的教材。

在人工智能浪潮席卷全球的今天,大模型(Large Language Models, LLM)已成为科技界最耀眼的明星。从ChatGPT的横空出世,到通义千问、文心一言等国产大模型的快速崛起,我们正见证一场由“参数规模”与“智能涌现”驱动的技术革命。然而,大模型并非凭空而来,它的背后是数十年人工智能技术的积累与演进。

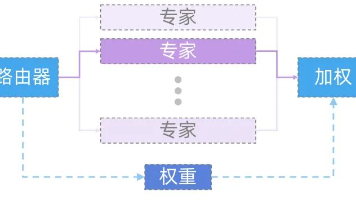

混合专家模型(MoE)是一种通过门控机制加权集成多个专家子模型计算结果的架构,在大模型中被广泛应用。它由专家和路由器组成,可分为稠密和稀疏两类。在Transformer架构中,MoE通过将FFN层替换为稀疏MoE层实现,路由器选择最活跃的K个专家进行计算,提高模型效率和质量。

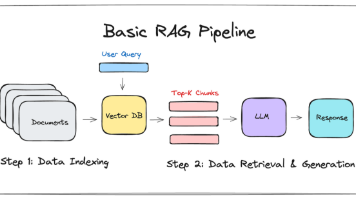

文章详细解析了RAG技术的工作流程,澄清了Langchain、向量化与RAG的关系,通过咖啡知识库案例展示了文档清洗与向量化的重要性。作者指出向量检索面临"语义相似≠答案相关"的瓶颈,提出"向量路由+结构化知识库"的混合架构,将向量库降级为语义路由器,结构化知识库作为知识载体,以提高AI系统回答问题的准确性和效率。

用正则表达式或者 DOM 解析器(如 BeautifulSoup)按照逻辑结构(标题,段落)分块。适合结构化文档,但是需要手动设计分割规则。

传统搜索更多依赖关键词匹配,比如“AI”和“人工智能”在字面上差距很大,结果往往无法对应。但 Embedding 不一样,它会把语义信息映射到向量空间,把“AI”和“人工智能”放得很近,从而实现语义级别的检索。文本经过模型编码,得到一个固定维度的向量;数据库里的候选内容也被转换成向量;系统计算“查询向量”和“候选向量”之间的相似度(常用方法有余弦相似度、欧氏距离等);最终按照相似度得分进行排序,相

总的来说,Transformer架构在诞生后的几年间,研究人员不断在不同规模、不同类型的数据集上进行探索,尝试设计新的预训练目标,并在结构上进行改进与优化。这些努力催生了数百种不同的Transformer变体,虽然它们在细节设计、训练方式和应用领域上各不相同,但从整体结构来看,依然可以归纳为三大类,如图4所示。图4 Transformer最突出的架构及生命树Transformer的出现彻底改变了深