简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

JEECGJEECG BOOT 低代码开发平台(前后端分离版本)当前最新版本: 3.1.0(发布日期:2022-03-01)AURGitHub stars GitHub forks项目介绍:Java Low Code Platform for Enterprise web applicationsJeecgBoot 是一款基于代码生成器的低代码平台!前后端分离架构 SpringBoot2.x,Sp

机器学习(ML)在最近的研究中越来越受欢迎。它已经在一个巨大的应用范围包括图像识别、多媒体概念检索、社交网络分析、视频等推荐、文本挖掘等。深度学习(DL)在这些应用中得到了广泛的应用[117]。指数计算技术的增长、令人难以置信的发展和数据可用性促成了DL的研究。深度学习的成功一直是解决更复杂的机器学习问题的激励因素。此外,深度学习的主要优势是它以层次形式表示,也就是说,它可以通过一个通用的目的学习

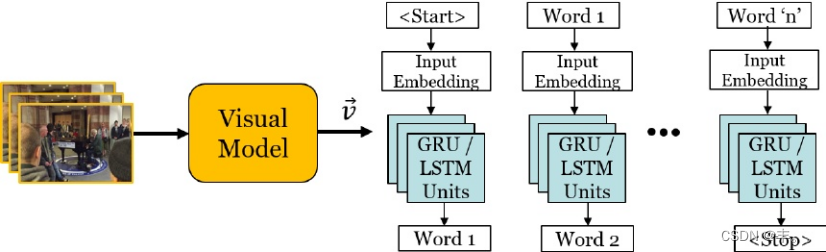

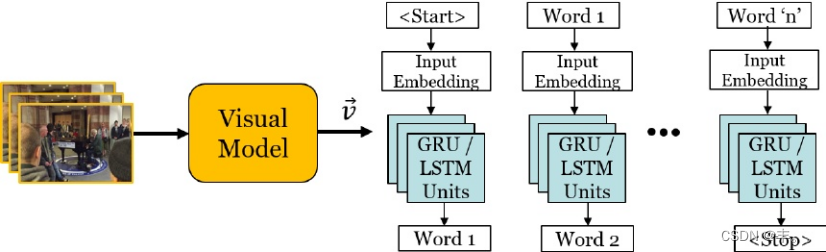

视频描述是描述给定视频内容的自然语言句子的自动生成。它在人机交互、帮助视障人士和视频字幕等方面都有应用。过去几年,由于深度学习在计算机视觉和自然语言处理方面取得了前所未有的成功,这一领域的研究激增。文献中已经提出了许多方法、数据集和评估指标,呼吁需要进行全面的调查,将研究工作集中在这个蓬勃发展的新方向上。本文通过调查最先进的方法来填补这一空白,重点关注深度学习模型;比较基准数据集的领域、类数和存储

本文为简单机翻,参考学习用1多模态机器学习:综述与分类Tadas Baltruˇsaitis, Chaitanya Ahuja,和Louis-Philippe Morency抽象——我们对世界的体验是多模态的——我们看到物体,听到声音,感觉到纹理,闻到气味,尝到味道。模态是指某件事情发生或体验的方式,当一个研究问题包含多个这样的模态时,它就被称为多模态。为了让人工智能在理解我们周围的世界方面取得进

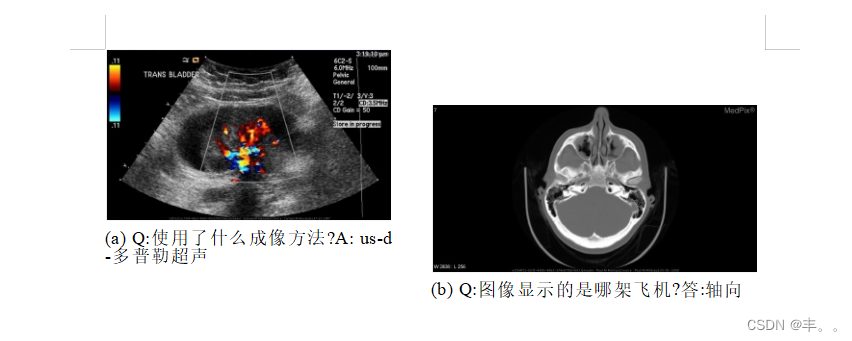

本文介绍了ImageCLEF 2019上的医学视觉问答任务(VQA-Med)的概述。参与系统的任务是根据放射学图像的视觉内容回答医学问题。在VQA-Med的第二版中,我们重点讨论了四类临床问题:模态、平面、器官系统和异常。利用分类和文本生成方法,这些类别的设计具有不同程度的难度。我们还确保所有问题都可以从图像内容中回答,而不需要额外的医学知识或特定领域的推理。我们创建了一个包含4200个放射学的新

凝聚型层次聚类(Agglomerative Hierarchical Clustering):在凝聚型方法中,每个数据点被视为一个单独的聚类,然后逐步将具有最小距离的聚类合并成更大的聚类,直到所有数据点都在一个大聚类中。分裂型层次聚类(Divisive Hierarchical Clustering):在分裂型方法中,所有数据点都被视为一个大聚类,然后逐步将聚类分裂成更小的聚类,直到每个数据点都在

目的:避免经过多层训练之后的效果不如前面的层原理:同时计算出两个数值,一个是经过多层训练的X,另一个是保留的上一层的X,两个效果进行比较一句话:不能比原来的效果差

视频描述是描述给定视频内容的自然语言句子的自动生成。它在人机交互、帮助视障人士和视频字幕等方面都有应用。过去几年,由于深度学习在计算机视觉和自然语言处理方面取得了前所未有的成功,这一领域的研究激增。文献中已经提出了许多方法、数据集和评估指标,呼吁需要进行全面的调查,将研究工作集中在这个蓬勃发展的新方向上。本文通过调查最先进的方法来填补这一空白,重点关注深度学习模型;比较基准数据集的领域、类数和存储

PowerTransformer 是用于对数据进行幂变换(也称为Box-Cox变换)的预处理工具。幂变换可以使数据更接近正态分布,这有助于某些机器学习算法的性能提升。它支持两种常用的幂变换:Yeo-Johnson变换和Box-Cox变换。MinMaxScaler 是用于将数据进行最小-最大缩放的预处理工具。它将数据缩放到指定的范围,通常是。这对于那些受到特征尺度影响的算法(如K近邻和支持向量机)非

自顶向下的视觉注意机制已广泛应用于图像字幕和视觉问答(VQA)中,通过细粒度分析甚至多步推理,实现更深层次的图像理解。在这项工作中,我们提出了一种自下而上和自上而下相结合的注意机制,使注意力能够在物体和其他突出图像区域的层面上进行计算。这是需要考虑的注意力的自然基础。在我们的方法中,自下而上的机制(基于Faster R-CNN)提出图像区域,每个区域都有一个相关的特征向量,而自上而下的机制决定特征