简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

"为什么ChatGPT能在手机上流畅运行?为什么Stable Diffusion生成图片只需1秒?这一切的秘密,都藏在「模型量化」的黑科技里!"随着大模型参数量突破万亿级,如何让这些"庞然大物"在手机、IoT设备上跑起来?本文将用最通俗的语言,带你揭开模型量化的神秘面纱!

本篇文章我们将 ONNX 引擎跑起来了,加载了 yolo 模型,大家先模仿着跑起来。

在AI技术持续突破的今天,Alexander Doria的前沿研究揭示了一个颠覆性趋势:真正的智能体将摆脱对提示词的依赖,通过模型本体的进化实现认知跃迁。这种范式转换正在重塑人工智能的发展轨迹。

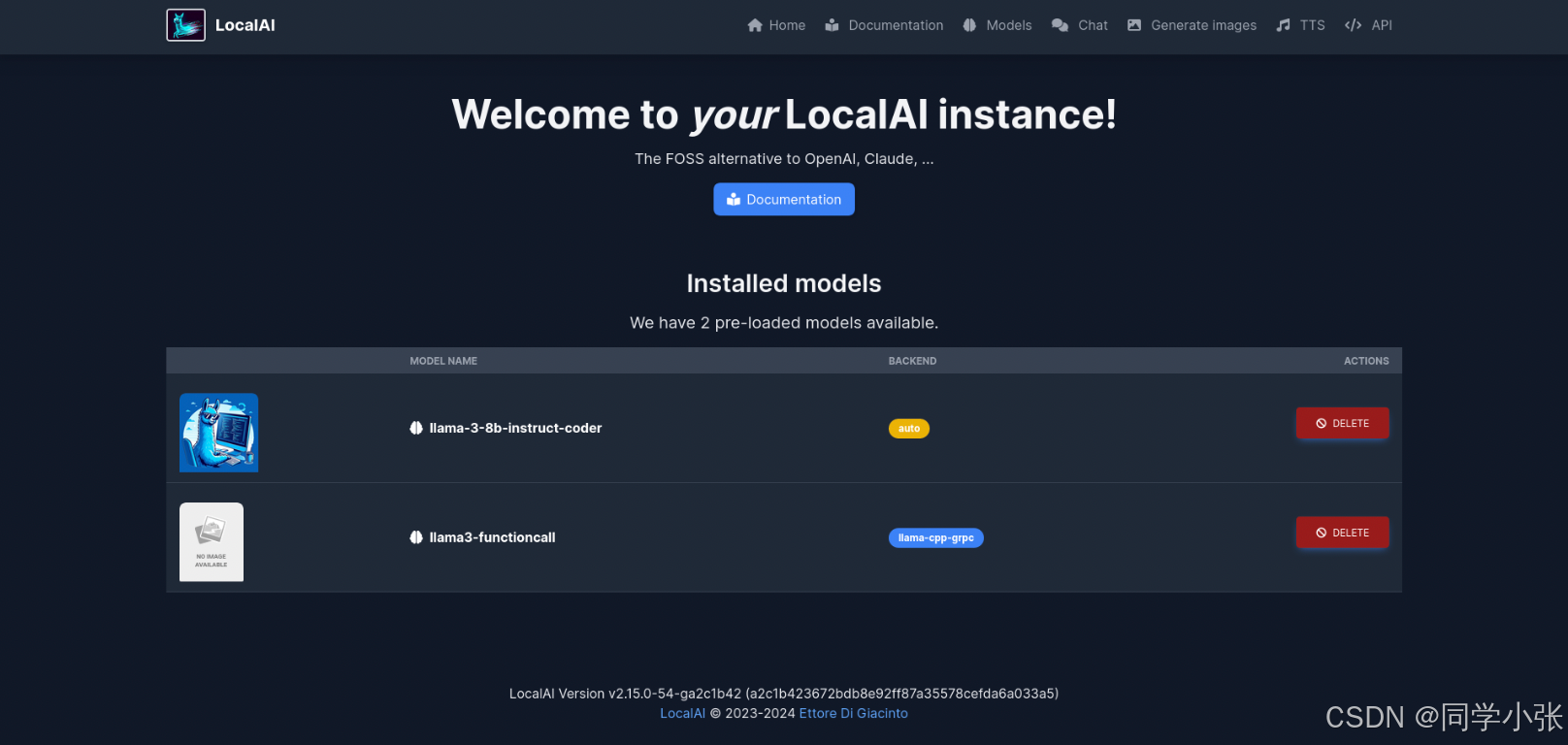

LocalAI开源项目 横空出世,它不仅让AI模型的本地部署变得轻而易举,还彻底改变了我们对AI运行环境的认知。

至此,我们大体知道了手动调用一个模型文件的总过程。

百度居然开始做慈善了!开放不限时免费机器资源,支持将 DeepSeek-R1-Distill 系列模型(最大 70B)和最新 QwQ-32B 一键部署,直接通过 OpenAI API 兼容接口调用,零成本体验大模型服务!

最近有大牛预测,中国未来只会有三家公司的模型—— DeepSeek、阿里和字节。先不管预测的准不准,国民级AI Deepseek已经进入大家的生活:宝妈用它秒编育儿干货,大学生靠它拿省奖论文,甚至连65岁奶奶都在用它做养生短视频!不用写复杂指令、不需懂代码、不花一分钱,它到底有多强?这篇文章手把手带你极速入门,看完立马用AI卷爆同行!

前几天我在自己的Mac笔记本上部署了deepseek大模型,并配置了UI对话框,但是本地模型如何调用其API呢?

在人工智能领域,Model Context Protocol(MCP)正逐渐成为连接AI模型与各类数据源及工具的重要标准。MCP究竟为何物?它又将如何改变AI应用的开发与使用?

如题,记录一下如何一次性使用多个 MCP Server。