简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

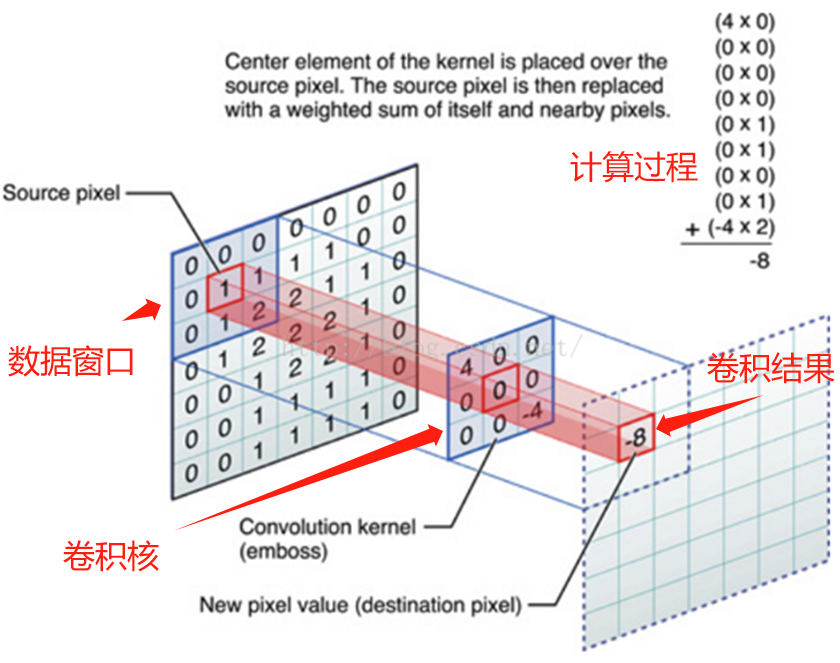

在卷积神经网络中,卷积操作是指将一个可移动的小窗口(称为数据窗口,如下图绿色矩形)与图像进行逐元素相乘然后相加的操作。这个小窗口其实是一组固定的权重,它可以被看作是一个特定的滤波器(filter)或卷积核。这个操作的名称“卷积”,源自于这种元素级相乘和求和的过程。这一操作是卷积神经网络名字的来源。上图这个绿色小窗就是数据窗口。简而言之,卷积操作就是用一个可移动的小窗口来提取图像中的特征。

本文是一个基于Python和OpenCV的身份证号识别项目。它的主要目标是自动识别和提取身份证上的身份证号码。这个项目有很多实际的应用场景,比如在自动化办公、身份验证等场合,可以大大提高工作效率和准确性,话不多说,直接进入正题。

在训练过程中,数据会被“轮”多少次,即应当完整遍历数据集多少次(一次为一个Epoch)。具体来说,我们需要将所有的数据都送入神经网络进行一次前向传播和反向传播,所以一次Epoch相当于所有数据集/batch size=N次迭代。在神经网络训练中,每一次迭代,或者说每一次“步骤”(step)或“批”(batch),我们都会将一小部分数据(也就是一个batch size)送入神经网络进行训练。一个Ep

在训练过程中,数据会被“轮”多少次,即应当完整遍历数据集多少次(一次为一个Epoch)。具体来说,我们需要将所有的数据都送入神经网络进行一次前向传播和反向传播,所以一次Epoch相当于所有数据集/batch size=N次迭代。在神经网络训练中,每一次迭代,或者说每一次“步骤”(step)或“批”(batch),我们都会将一小部分数据(也就是一个batch size)送入神经网络进行训练。一个Ep

os.mkdir(path),他的功能是一级一级的创建目录,前提是前面的目录已存在,如果不存在会报异常,比较麻烦,但是存在即有他的道理,当你的目录是根据文件名动态创建的时候,你会发现他虽然繁琐但是很有保障,不会因为你的一时手抖,创建而创建了双层或者多层错误路径,os.makedirs(path),单从写法上就能猜出他的区别,他可以一次创建多级目录,哪怕中间目录不存在也能正常的(替你)创建,想想都可

在训练过程中,数据会被“轮”多少次,即应当完整遍历数据集多少次(一次为一个Epoch)。具体来说,我们需要将所有的数据都送入神经网络进行一次前向传播和反向传播,所以一次Epoch相当于所有数据集/batch size=N次迭代。在神经网络训练中,每一次迭代,或者说每一次“步骤”(step)或“批”(batch),我们都会将一小部分数据(也就是一个batch size)送入神经网络进行训练。一个Ep

这是因为全连接层和前面一层的连接的参数数量需要事先确定,不像卷积核的参数个数就是卷积核大小,前层的图像大小不管怎么变化,卷积核的参数数量也不会改变,但全连接的参数是随前层大小的变化而变的,如果输入图片大小不一样,那么全连接层之前的feature map也不一样,那全连接层的参数数量就不能确定, 所以必须实现固定输入图像的大小。这是由于全连接层是层层相扣的,在矩阵乘法中,第一个矩阵的列数必须与第二个

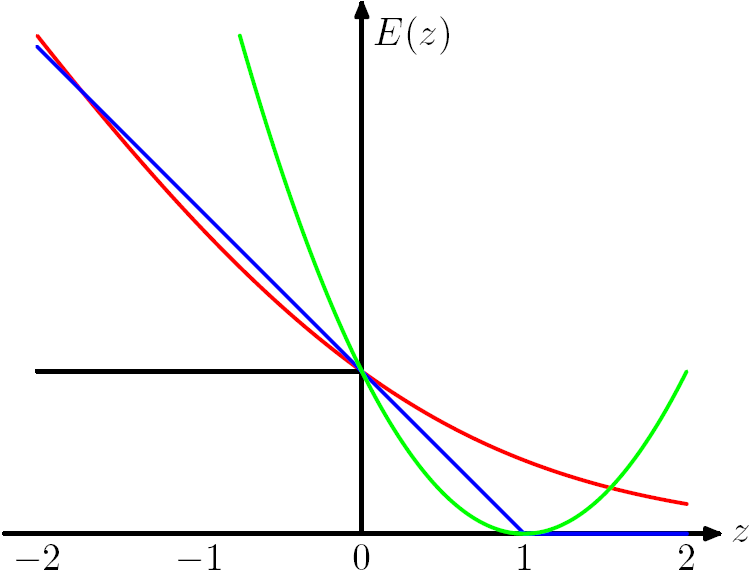

在PyTorch中,均方差(Mean Squared Error,MSE)损失函数可以用于回归问题。注意,你的预测值和真实值的维度应该匹配。在这个例子中,我们假设预测值和真实值都是一个大小为3的批量,每个样本有一个输出维度。注意,你的预测值和真实值的维度应该匹配。在这个例子中,我们假设预测值和真实值都是一个大小为3的批量,每个样本有一个输出维度。以上只是其中一部分内置损失函数,PyTorch还提供

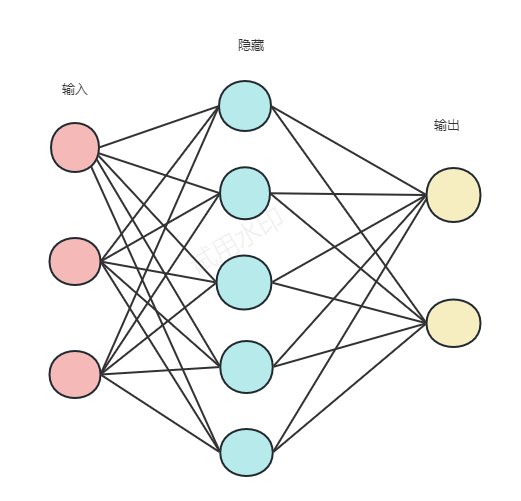

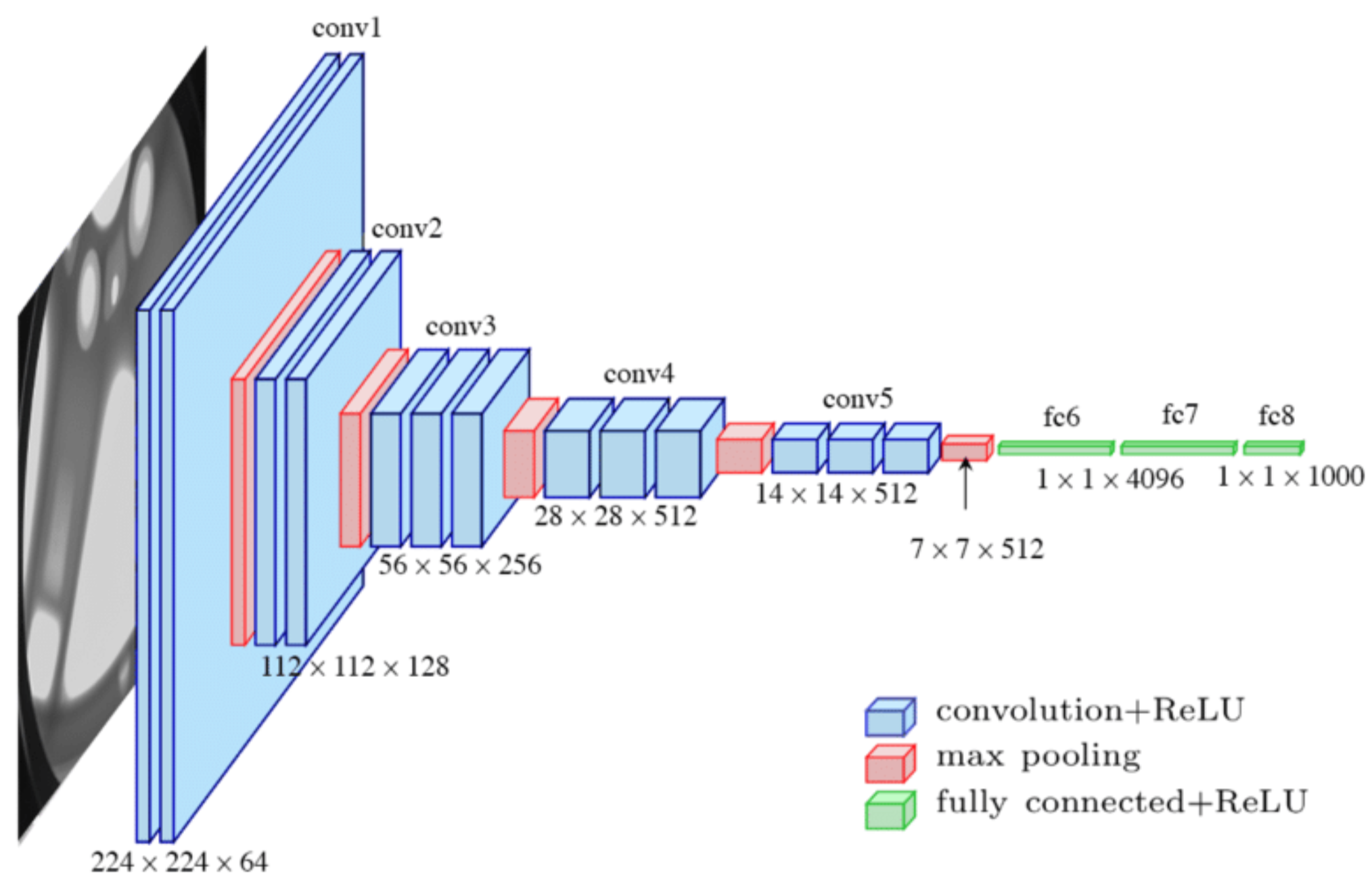

卷积神经网络(Convolutional Neural Network,简称CNN)是一种特殊的神经网络,其结构基于输入数据为图像的假设,主要由卷积层、池化(Pooling)层和全连接层构成。卷积层负责在原始图像上平移以提取特征,激活层增加非线性分割能力;池化层通过稀疏特征参数降低网络的复杂度;最后全连接层用于损失计算与分类。相比常规神经网络,卷积神经网络在前向传播函数实现上更高效,且大幅度降低了

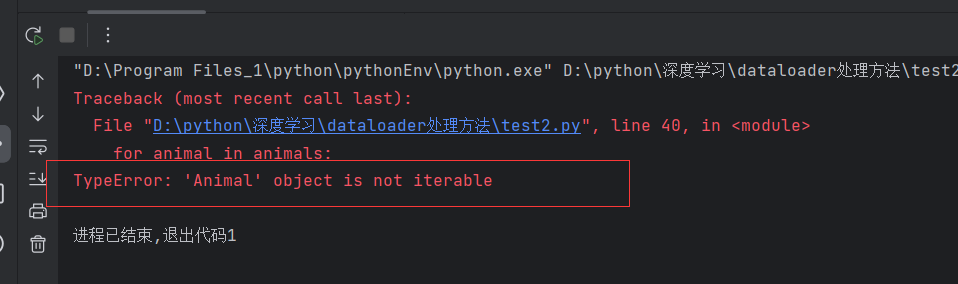

经常会遇到python类中遇到一些特殊的方法,最常见的就是__ini__方法,想必大家都遇到过,今天来谈谈另外一种非常好用的类方法--__getitem____getitem__的作用是什么呢?说白了就是类中一个特殊方法。